DOI: 10.17175/sb001_014

Nachweis im OPAC der Herzog August Bibliothek: 83020413X

Erstveröffentlichung: 19.02.2015

Medienlizenzen: Medienrechte liegen bei den Autoren

Letzte Überprüfung aller Verweise: 24.05.2016

GND-Verschlagwortung: Pädagogik | Mixed Reality | Mensch-Maschine-Kommunikation |

Empfohlene Zitierweise: Katharina Schuster, Anja Richert, Sabine Jeschke: Neue Perspektiven für die Erziehungswissenschaften – Das Potenzial von Mixed Reality für Lehr- und Lernprozesse. In: Grenzen und Möglichkeiten der Digital Humanities. Hg. von Constanze Baum / Thomas Stäcker. 2015 (= Sonderband der Zeitschrift für digitale Geisteswissenschaften, 1). text/html Format. DOI: 10.17175/sb001_014

Abstract

›Mixed Reality‹ beschreibt die Kombination aus virtuellen Umgebungen und natürlichen Benutzerschnittstellen. Das Sichtfeld der nutzenden Person wird hierbei über Head Mounted Displays durch Kopfbewegung gesteuert, Datenhandschuhe ermöglichen die Interaktion mit virtuellen Objekten und omnidirektionale Böden erlauben eine unbegrenzte Fortbewegung durch virtuelle Welten mittels natürlichen Gehens. In einer quasi-experimentellen Untersuchung konnte gezeigt werden, dass ›Mixed Reality‹ sich vor allem auf emotionaler und motivationaler Ebene positiv auswirkt. Die Ergebnisse werden vor dem Hintergrund der Frage interpretiert, inwiefern sich durch derart innovative Technologien grundlegend neue Möglichkeiten für die Erziehungswissenschaften ergeben.

›Mixed Reality‹ describes the combination of virtual environments and natural user interfaces. Here, the user's field of vision is controlled by natural head movements via a head mounted display. Data gloves allow direct interaction with virtual objects and omnidirectional floors enable unrestricted navigation through virtual worlds with natural walking movements. A quasi-experimental study showed that ›mixed reality‹ had a positive effect, particularly on affective and motivational levels. The results are interpreted in the context of the new possibilities for pedagogy offered by such innovative technologies.

- 1. Einführung – Neue Perspektiven für die Erziehungswissenschaften

- 2. Quasi-experimentelle Untersuchungen zum Potenzial von Mixed Reality für Lehr- und Lernprozesse

- 2.1 Apparat: Der Mixed Reality-Simulator ›Virtual Theatre‹

- 2.2 Ablauf der Studie

- 2.3 Variablen und Messinstrumente

- 2.4 Stichprobe und statistische Auswertung

- 2.5 Ergebnisse

- 3. Diskussion

- 4. Ausblick: Mit Mixed Reality zum ›Virtual Turn‹ in den Erziehungswissenschaften?

- Bibliographische Angaben

- Abbildungslegenden und -nachweise

1. Einführung – Neue Perspektiven für die Erziehungswissenschaften

»Das Selbstverständnis der deutschsprachigen Erziehungswissenschaft hat sich in den letzten dreißig Jahren geändert und ändert sich weiterhin. Ein solcher Wandel kann – auf den ersten Blick – verstanden werden als ein Hinweis darauf, dass sich die Disziplin neuen Herausforderungen stellt, sich neuen Fragen öffnet, diese mit neuen Methoden der Erkenntnisgewinnung untersucht und neue Lösungen entwickelt.«[1]

Diese einleitenden Worte im Vorwort eines Beiheftes der Zeitschrift für Pädagogik mit dem Titel Das Selbstverständnis der Erziehungswissenschaft: Geschichte und Gegenwart deuten auf einen vielschichtigen Paradigmenwechsel hin, dem sich die Wissenschaftsdisziplin unterzieht. In den 1960er und 1970er Jahren markierte die Ergänzung des geisteswissenschaftlich-hermeneutisch geprägten Selbstverständnisses um eine empirisch-sozialwissenschaftliche Dimension unter dem Schlagwort der ›realistischen Wende‹ einen ersten methodischen Wendepunkt für die Erziehungswissenschaft.[2] Eine Öffnung für interdisziplinäre Zusammenarbeit, u.a. mit der pädagogischen Psychologie, der Soziologie, der Ökonomie oder den Neurowissenschaften, war die Folge.[3] Auch wenn sich die im zitierten Vorwort genannten Herausforderungen und neuen Fragen eher auf eine thematisch-inhaltliche Dimension beziehen[4], können sie in methodischer Hinsicht auch vor dem Hintergrund der Digital Humanities interpretiert werden.

So geht es im Sinne der Digital Humanities darum, in und für die Geisteswissenschaften »die Prozesse der Gewinnung und Vermittlung neuen Wissens unter den Bedingungen einer digitalen Arbeits- und Medienwelt weiter zu entwickeln«[5]. Der analytische Mehrwert digitaler Werkzeuge für die Geisteswissenschaften liegt dabei nicht nur in neuen Möglichkeiten der Auswertung, wie z.B. Learning Analytics, Data- oder Text-Mining Verfahren. Durch die Entwicklung neuer Informationstechnologien werden völlig neuartige Zugänge zu bekannten Untersuchungsgegenständen ermöglicht – und dem stetigen wissenschaftlichen Fortschritt entsprechend auch neue Untersuchungsgegenstände aufgedeckt. Für die Didaktik und insbesondere die Mediendidaktik spielen dabei auf der Softwareseite multimediale Wissensräume wie virtuelle 3D-Welten eine große Rolle, die sich im Schul- und Hochschulkontext immer größerer Beliebtheit erfreuen.

Seit den 1990er Jahren werden Computerspielsimulationen für Lern- und Trainingszwecke entwickelt und eingesetzt, um komplexe technische Systeme oder den Umgang mit ökonomischen, ökologischen oder sozialen Systemen zu erlernen (z.B. Unternehmensplanung, Klimaentwicklung, Stadtplanung).[6] Anwendungen reichen von der Simulation prozeduraler Vorgänge im medizinischen Bereich über den Erwerb von Kenntnissen zur Führung eines Fahr- oder Flugzeuges bis hin zur Planung logistischer Prozesse in virtuellen Fabriken. Durch simulierte Verlangsamung oder Beschleunigung von Prozessen oder durch die Simulation von Zukunftsszenarien und historischen Ereignissen lässt sich durch Virtualität nicht nur die Raum- sondern auch die Zeitgrenze durchbrechen.[7] Unter dem Begriff ›Simulation‹ werden von verschiedenen Autoren unterschiedliche Lern- und Trainingsszenarien subsummiert:

- Visualisierungen komplexer theoretische Konstrukte (z.B. der Mathematik), die aus verschiedenen Perspektiven betrachtet und verändert werden können[8],

- Situationen, in denen Fehlverhalten zu gesundheitlichen Schäden oder schlimmstenfalls zum eigenen Tod bzw. zum Tod anderer Menschen führt, z.B. durch einen Störfall in einem Atomkraftwerk[9] oder im medizinischen Bereich während einer Operation[10],

- Situationen, die fast nie eintreten und dennoch möglich sind[11], z.B. Evakuierungen bei Massenpaniken,

- Situationen, deren Training mit hohen Kosten verbunden ist, da bspw. teures Equipment zum Einsatz kommt oder hoher Materialverschleiß mit dem Training einhergeht[12],

- Situationen, die in der Vergangenheit oder in der Zukunft liegen, wie z.B. ein Spaziergang durch das alte Pompeji oder auf dem Mars[13],

- Situationen, in denen nicht sichtbare Wirkungszusammenhängen und Zustände sichtbar gemacht werden sollen, z.B. Luftströme in einem Gebäude[14].

Für die Anwendung müssen zunächst oben beschriebene Szenarien in virtuellen Umgebungen nachgebaut werden. In Simulationen oder Lernspielen (Serious Games) können die Eigenschaften und Prinzipien mit entsprechenden Inhalten verknüpft und dadurch nachvollziehbar gemacht werden. In den Natur- und Ingenieurwissenschaften dienen virtuelle Labore dem zeit- und ortsunabhängigen Experimentieren und somit dem insbesondere in der Studieneingangsphase so wichtigen Aufbau eines wissenschaftlichen Selbstverständnisses der Studierenden. Wie die obige Aufzählung zeigt, kann der Einsatz virtueller Lernumgebungen verschiedenen Stufen des Lernens dienen. Dies betrifft erstens die Exploration fiktiver Welten, die im physisch Realen nicht umsetzbar sind. Zweitens unterstützen anspruchsvolle Visualisierungstechniken den initialen Verstehensprozess komplexer Lerninhalte und bieten durch Interaktionsmöglichkeiten eine aktive Verarbeitung der Informationen auf unterschiedlichen mentalen Ebenen. Drittens stellt eine virtuelle Lernumgebung häufig die ›vorletzte Stufe des Wissenstransfers‹ dar, die sich in der Übung realer Handlungen im virtuellen Raum manifestiert, bevor diese im physischen realen Kontext angewendet werden müssen. Wie eine bestimmte virtuelle Umgebung erlebt und rezipiert wird, hängt jedoch auch entscheidend von der jeweils eingesetzten Hardware ab.

Ein Nachteil von Simulationen in Bezug auf den Wissenstransfer besteht häufig in der physischen Künstlichkeit der Lernerfahrung. Die Stelle oder Handlung, mit der ein Mensch mit einer Maschine in Kontakt tritt, wird generell als Benutzerschnittstelle (Human Machine Interface, HMI) bezeichnet.[15] Normalerweise interagieren Nutzerinnen und Nutzer mit einer virtuellen Umgebung über einen Personal Computer. Das virtuelle Szenario wird auf einem Monitor angezeigt und das Sichtfeld üblicherweise durch eine Tastatur oder eine Maus gesteuert. Interaktionen mit virtuellen Objekten sowie Fortbewegung erfolgen meist über die gleichen Benutzerschnittstellen. Auf diese Weise überträgt der Nutzer oder die Nutzerin den Kontrollmodus des Computers auf die Aktionen seiner grafischen Repräsentation, auf den Avatar.

Dass Mensch und Computer durch Sprache und Gestik miteinander kommunizieren, ist schon lange nicht mehr der Welt von Science-Fiction-Filmen überlassen. Völlig selbstverständlich werden inzwischen Smartphones und Tablet-Computer mit Wischgesten auf dem Multi-Touch-Display bedient. Das Blättern in Fotoalben, Scrollen in langen Artikeln, Zoomen in bestimmte Bildausschnitte oder Webseiten erfolgt nicht mehr durch Anklicken entsprechender Symbole auf dem Bildschirm sondern durch ›Tippen‹, ›Wischen‹ oder ›Finger auseinanderziehen‹. Computer sind darüber hinaus in der Lage, Körperhaltungen, Bewegungen und Gesten des Menschen zu erkennen, in Befehle zu übersetzen und sie auszuführen. Dies kann sowohl gerätebasiert, z. B. über Datenhandschuhe, oder kamerabasiert geschehen, wie bei der Hardwarekomponente Kinect für die Spielkonsole Xbox. Diese Form der Mensch-Computer-Interaktion wird durch das Konzept der natürlichen Benutzerschnittstellen beschrieben (Natural User Interfaces, NUI). In Kombination mit virtuellen Umgebungen werden natürliche Benutzerschnittstellen der sogenannten gemischten Realität zugeordnet, die auch im Deutschen häufig als ›Mixed Reality‹ bezeichnet wird.

Natürliche Benutzerschnittstellen für Visualisierung, Navigation und Interaktion können im Vergleich zu einem feststehenden Rechner oder zu einem Laptop eine weitgehend authentische Lernerfahrung bieten. Bekannte Beispiele sind Flug- und Fahrsimulatoren oder bestimmte Spielkonsolen im Unterhaltungsbereich. Ziel der natürlichen Benutzerschnittstellen ist es immer, die Mensch-Computer-Interaktion intuitiver zu gestalten. Bei solchen Geräten stimmt somit die physisch reale Bewegungshandlung mit der virtuell ausgeführten Bewegungshandlung überein.

Der Nutzer oder die Nutzerin soll darüber hinaus den Eindruck haben, regelrecht in die virtuelle Welt eintauchen zu können. In diesem Zusammenhang fällt häufig der Begriff der ›Immersion‹. Als Einstieg sei Immersion zunächst als eine Kategorie der Wirkung von etwas betrachtet, das die Aufmerksamkeit von jemandem beansprucht, der sich auf dieses Etwas konzentriert und einlässt.[16] Etymologisch verweist das lateinische Wort immersio auf eine physische Erfahrung des Ein- bzw. Untertauchens in Flüssigkeit. Als Phänomen einer intensiven Grenzerfahrung zwischen zwei Realitätsmodi beschreibt Murray 1999 Immersion als

»a metaphorical term derived from the physical experience of being submerged in water. We seek the same feeling from a psychologically immersive experience that we do from a plunge in the ocean or swimming pool: the sensation of being surrounded by a completely other reality, as different as water is from air, that takes over all of our attention, our whole perceptual apparatus«[17].

Neben der häufig genannten Analogie des Eintauchens bringt die Betrachtung des Immersionsbegriffs in einer Vielzahl wissenschaftlicher Disziplinen entsprechend unterschiedliche Bedeutungsfacetten hervor. Immersive Zustände können dabei sowohl in fiktionalen Welten als auch in nicht-narrativen virtuellen Umgebungen auftreten. Oft ist es das erklärte Ziel von Entwicklern virtueller Welten oder natürlicher Benutzerschnittstellen, den Eindruck des ›Eintauchens‹ durch bestimmte technische Eigenschaften zu unterstützen. Dementsprechend ist in solchen Fällen von immersiven Lernumgebungen oder immersiven Benutzerschnittstellen die Rede. Aus technischer Sicht benötigt der Nutzer oder die Nutzerin für eine erhöhte Immersion eine nahtlose 3D-Sicht der virtuellen Umwelt. Diese wird häufig durch Head Mounted Displays (HMDs) realisiert. Für eine natürliche Navigation in der virtuellen Umgebung können omnidirektionale Laufbänder verwendet werden, die eine freie und unbegrenzte Bewegung ermöglichen und die nutzende Person doch an einem physisch klar begrenzten Ort lassen. Durch Datenhandschuhe kann der Nutzer bzw. die Nutzerin intuitiv mit der virtuellen Umgebung sowie den Objekten, die sich in ihr befinden, interagieren.

Für die Untersuchung und die Messbarkeit immersiver Erfahrungen ist jedoch eine Spezifizierung des Konstrukts vonnöten. Der Begriff des Präsenzerlebens verweist auf das Phänomen des räumlichen Eintauchens in eine virtuelle Umgebung und wird relativ einheitlich als ›sense of being there‹ beschrieben. Im Diskurs über den Einsatz virtueller Welten zu Lernzwecken taucht außerdem immer wieder die Frage auf, welche möglicherweise unterstützende Wirkung Immersion auf Lernprozesse haben könnte.[18] In diesem Zusammenhang wird Immersion häufig mit dem Konstrukt des Flow-Erlebens in Verbindung gebracht[19]:

»Immersion bezeichnet ein Eintauchen und bezieht sich, anders als der eher auf Fähigkeiten bezogene Flow, auf die Fokussierung von Aufmerksamkeit auf die medialen Inhalte […] Genau wie beim Spielen ist auch beim Lernen ein solches Eintauchen bzw. Aufgehen in der Aufgabe der Idealzustand zur Erreichung der Lernziele.«[20]

Sogenannte immersive Lernumgebungen bezeichnen meist selbst erstellte virtuelle Räume, die in kommerzielle Online-3D-Infrastrukturen wie Second Life oder entsprechende Open Source-Varianten wie OpenSim eingebettet sind.[21] Die technischen Möglichkeiten, wie z. B. multimodale Informationsaufnahme oder Interaktionsmöglichkeiten mit anderen Nutzern oder Inhalten, werden häufig gleichgesetzt mit dem beabsichtigten Erlebensaspekt der Immersion.[22] Positive Effekte von Immersion auf Lernleistung und/oder -motivation gehen oft nicht über Annahmen hinaus.[23] Gebräuchliche Formulierungen wie ›immersives Lernen‹, ›immersive virtuelle Welten‹ oder ›immersive Umgebungen‹ suggerieren, dass der beabsichtigte Effekt automatisch eintritt.

Aufgrund der Möglichkeit, virtuelle Lernumgebungen durch natürliche Bewegungen zu steuern, liegt das große Potenzial natürlicher Benutzerschnittstellen für die Erziehungswissenschaft im praktisch orientierten Teil der Mediendidaktik. Genauer lautet die zu beantwortende Frage, ob und in welcher Form Schüler und/oder Studierende in Mixed Reality-Szenarien besser lernen können als in rein virtueller oder in rein physischer Realität. Bevor natürliche Benutzerschnittstellen flächendeckend zu Lern- und Trainingszwecken zum Einsatz kommen, sind wissenschaftliche Erkenntnisse über die Wahrnehmung der Rezeptionssituation und über den tatsächlichen Lernerfolg notwendig. Deswegen wird die weitere Entwicklung der Hardware von unterschiedlichen mediendidaktischen und medienpsychologischen Studien begleitet, von denen eine im Folgenden näher beschrieben wird. Darüber hinaus stellt sich nach wie vor die Frage, welche Rolle Immersion beim Lernen in virtuellen Welten spielt. Der Grundsatz der Digital Humanities, »die Prozesse der Gewinnung und Vermittlung neuen Wissens unter den Bedingungen einer digitalen Arbeits- und Medienwelt weiter zu entwickeln«[24], lässt sich vor diesem Hintergrund auf die Motivation übertragen, das Potenzial von Mixed Reality für den Einsatz in der Lehre zu erforschen.

2. Quasi-experimentelle Untersuchungen zum Potenzial von Mixed Reality für

Lehr- und Lernprozesse

2.1 Apparat: Der Mixed Reality-Simulator ›Virtual Theatre‹

Ziel der hier beschriebenen Studie war es zu untersuchen, welchen Einfluss die Benutzerschnittstellen, mit denen eine bestimmte Lernumgebung rezipiert wird, auf Rezeptionsprozesse der Informationsverarbeitung und des Erlebens haben. Um die Effekte natürlicher Benutzerschnittstellen auf Rezeptionsprozesse präzise bestimmen zu können, wurde ein Zweigruppenplan erstellt.[25] Der Experimentalgruppe wurde als maßgebliches Treatment die Nutzung eines Mixed-Reality-Simulators (›Virtual Theatre‹) zugewiesen, während die Kontrollgruppe durch Nutzung eines Laptops definiert war. Die Lernumgebung wurde über die Experimental- und die Kontrollgruppe konstant gehalten. Die Daten wurden quantitativ erhoben und statistisch ausgewertet. Bezüglich dieser Auswertung und dementsprechend der Interpretation der Ergebnisse muss jedoch von vornherein eine Einschränkung vorgenommen werden. Der Einfluss der benutzten Hardware auf Rezeptionsprozesse kann nur mit einem Set aus unabhängigen Variablen gemessen werden, welches sich aus der Kombination mehrerer Benutzerschnittstellen zu einem Mixed Reality-Simulator ergibt. Somit ließen sich nicht alle potentiellen Störfaktoren vollständig eliminieren. Weiterhin ließ sich die Zuordnung der Studienteilnehmer zu den beiden Gruppen nicht vollständig randomisieren. Aus diesen Gründen wurde für die Studie die Bezeichnung ›quasi-experimentell‹ gewählt.[26]

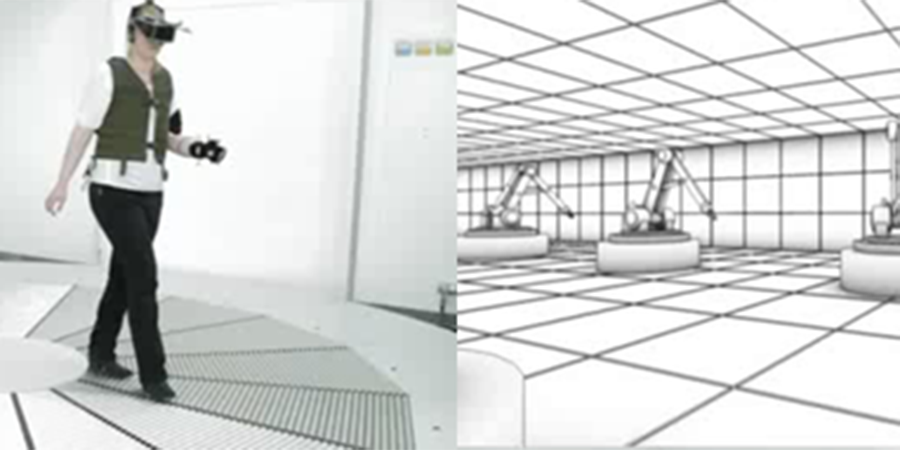

Das in der Studie eingesetzte Virtual Theatre ist ein Mixed Reality-Simulator, der die natürlichen Benutzerschnittstellen eines Head Mounted Displays und eines omnidirektionalen Bodens miteinander vereint. Abbildung 1 zeigt die Nutzung des Virtual Theatres sowie ein exemplarisches Lernszenario aus dem Gebiet der Ingenieurwissenschaften.

Das Virtual Theatre kann ausschließlich durch eine einzelne Person genutzt werden, die durch ihre natürlichen Körperbewegungen die Interaktion mit dem System steuert. Die das Virtual Theatre nutzende Person kann sich frei bewegen, indem sie die gewünschte Richtung ansteuert. Der omnidirektionale Boden besteht aus 16 trapezförmigen Elementen. Diese sind aus je 16 festen Rollen zusammengesetzt, die nach außen hin breiter werden. Die Elemente haben an der kurzen Grundseite einen gemeinsamen Ursprung und sind im Mittelpunkt über eine fixierte Plattform miteinander verbunden. Auf der Plattform in der Mitte des Bodens kann sich die nutzende Person bewegen, ohne die Bodenbewegung zu starten. Das Virtual Theatre ermöglicht dem Nutzer außerdem eine nahtlose 3D-Visualierung der virtuellen Umgebung mit einem stereoskopischen 70° Sichtfeld. Jede Kopfbewegung wird in Echtzeit in der Simulation widergespiegelt.

Das Head Mounted Display und der omnidirektionale Boden können wahlweise mit einem Datenhandschuh oder einem Hand-Tracer kombiniert werden, falls das Szenario keine direkte Objektinteraktion erfordert. An diesem etwa handgroßen Metallkreuz sind vier Infrarotmarker befestigt. Abbildung 2 zeigt den Datenhandschuh, den Hand-Tracer sowie die entsprechenden Darstellungen der Handbewegung in einer virtuellen Umgebung.

Der Hand-Tracer reagiert nicht auf Handgesten, wird jedoch für ein korrektes Positions-Tracking benötigt. Für die im Folgenden beschriebene Studie wurde der Einsatz des Hand-Tracers gewählt. Dieser erlaubt es, eine einzelne mögliche Einflussvariable auf die abhängigen Variablen, die Möglichkeit zur gestengesteuerten Objektinteraktion, zu isolieren. Aufgrund der Wahl des Hand-Tracers als Benutzerschnittstelle wird im Folgenden auch nur noch auf diesen verwiesen.

Um die Position der nutzenden Person in Echtzeit in die Virtualität zu übersetzen, ist das Virtual Theatre mit zehn Infrarotkameras ausgestattet. Die Kameras zeichnen die Positionen der Infrarot-Marker auf, die an dem HMD und dem Hand-Tracer befestigt sind.

2.2 Ablauf der Studie

Im Hinblick auf natürliche Benutzerschnittstellen ist nach wie vor die Frage offen, unter welchen Bedingungen virtuelle Umgebungen zum besten Lernergebnis führen und noch weiter gefragt, inwiefern Immersion und Lernerfolg miteinander zusammenhängen. Der medienpsychologischen Herangehensweise folgend, ist hierbei die Betrachtung von fünf Faktoren wichtig[27]:

- Charakteristika des Medienangebots,

- der Person,

- der Situation,

- des Rezeptionsprozesses, sowie

- der kurz- und langfristigen Wirkung.

Bei der vorgestellten Studie zum Einfluss natürlicher Benutzerschnittstellen auf Rezeptionsprozesse der Informationsverarbeitung und des Erlebens in virtuellen Lernumgebungen wurden die subjektive Erfahrung des Präsenzerlebens[28] und des Flow-Erlebens[29] als zentrale Kenngrößen für Immersion gemessen. Um weitere Einblicke in die Rezeptionssituation beim Lernen mit und Erleben von Mixed Reality zu erhalten, wurden situative Emotionen ebenfalls gemessen.

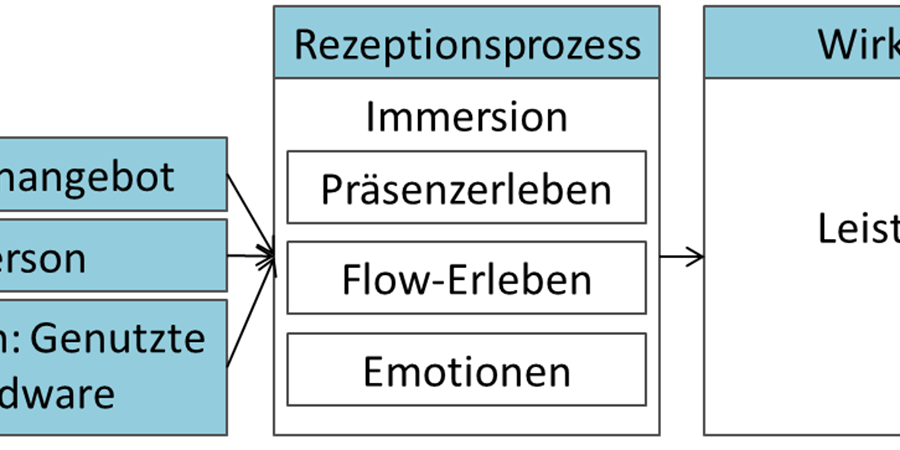

Eine der wichtigsten Fragen innerhalb eines Bildungs- und Trainingskontextes ist, ob die Erfahrung in einer virtuellen Umgebung über natürliche Benutzerschnittstellen zu einem besseren Lernergebnis führt als über einen die klassischen Benutzerschnittstellen wie Maus und Tastatur eines Personal Computers. Leistungsabfrage ist deshalb eine weitere wichtige Komponente des Studiendesigns. Die erwartete Beziehung zwischen Medienangebot, Person, Situation, Rezeptionsprozessen und Wirkung ist in Abbildung 3 dargestellt.

Um den Möglichkeiten des Virtual Theatres gerecht zu werden, wurde als Untersuchungsszenario eine Umgebung ausgewählt, die selbstgesteuertes, exploratives Erlernen räumlicher Strukturen ermöglicht.[30]. Gewählt wurde ein groß-skaliertes Labyrinth in einer Fabrikhalle. Der virtuelle Schauplatz der Fabrikhalle erschien wichtig, damit die Akustik der physisch realen Halle, in der das Virtual Theatre aufgebaut ist, nicht zu Irritationen in Kombination mit der Darstellung der virtuellen Umgebung führt. Im Labyrinth wurden elf verschiedene Objekte platziert.

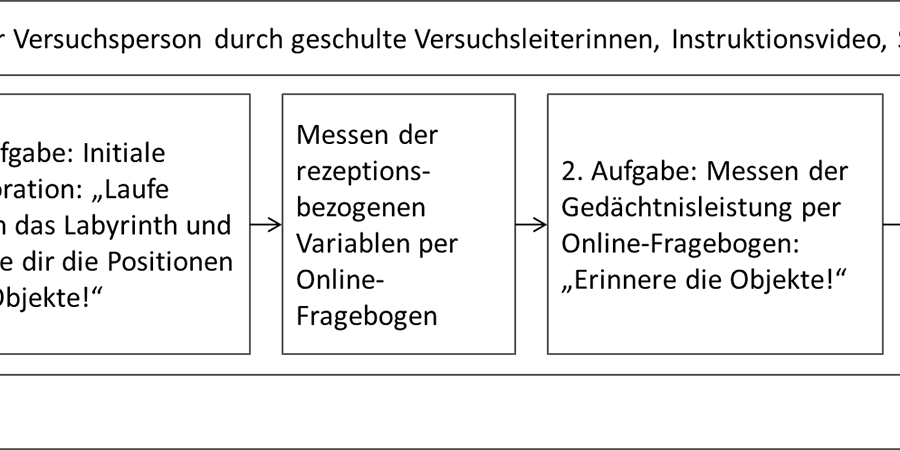

Der Versuchsablauf bestand aus insgesamt acht Teilen und dauerte etwa eine Stunde. Die Studie wurde von insgesamt drei geschulten Versuchsleiterinnen durchgeführt. Zur Standardisierung des Versuchsablaufs war zuvor eine umfangreiche Versuchsanordnung verfasst worden. Abbildung 4 zeigt den Gesamtablauf am Beispiel der Experimentalbedingung.

Auch die Aufgaben wurden so gewählt, dass sie der didaktischen Methode des explorativen Lernens entsprechen. Die Anweisung der initialen Explorationsaufgabe lautete, frei durch das Labyrinth zu navigieren und sich die Positionen der Objekte zu merken. Die Probanden erhielten keine Informationen über die Anzahl der aufzufindenden Objekte. So wurde zwar das Lernziel vorgegeben (»Merke dir die Positionen der Objekte«), jedoch nicht die zur Lösung des Problems möglichen Operatoren, wie z. B. verschiedene Orientierungs- oder Merkstrategien. Einer typischen Eigenschaft von E-Learning-Angeboten entsprechend, konnte so jeder Proband und jede Probandin unter Einschränkung der vorgegebenen Maximaldauer im eigenen, für sich am besten geeigneten Lerntempo bleiben und seine oder ihre kognitiven Fähigkeiten selbstgesteuert einsetzen. Beide Gruppen erhielten zuvor die Möglichkeit, für drei Minuten ein Testszenario (eine italienische Piazza) frei zu erkunden. Dies diente dazu, die Probanden an den jeweiligen Steuerungsmodus zu gewöhnen. Zur freien Exploration sowie zum Einprägen der Positionen der Objekte hatten die Probanden acht Minuten Zeit. Um ihnen einen Orientierungspunkt zu geben, wurde ihnen zu Beginn der ersten Aufgabe durch die Versuchsleitung mitgeteilt, dass sie mit Blick nach Norden starten.

Direkt im Anschluss füllten die Probanden am Tablet-Computer den zweiten Teil des Online-Fragebogens aus, mit dem die abhängigen Variablen des Erlebens abgefragt wurden. Zuletzt erfolgte die Leistungsmessung. Die Art der Leistungsmessung wurde über beide Gruppen konstant gehalten. Der Tablet PC (Nexus 10) wurde gewählt, damit sich das Medium der Wissensabfrage sowohl für die Experimental- als auch für die Kontrollgruppe hinreichend vom Medium der Aufgabe unterscheidet.

Für die Leistungsmessung wurden sowohl Aufgaben im Low-Level als auch im High-Level-Bereich gewählt.[31] Die zweite Aufgabe (Low-Level) lautete, die zuvor im Labyrinth gesehenen Objekte unter verschiedenen, dargebotenen Objekten wiederzuerkennen. Für die dritte Aufgabe (High-Level) mussten die Probanden die Objekte, die sie zuvor im Labyrinth gesehen hatten, auf einem Tablet-Computer über eine direkte Zeigebewegung mit dem Finger per Drag-and-Drop-Funktion an der korrekten Stelle auf einer Karte des Labyrinths positionieren. Für jedes abgelegte Objekt ertönte als auditives Feedback ein Signalton. Während der Anwendung konnten die Objekte immer wieder verschoben werden. Die Applikation (im Folgenden als ›App‹ bezeichnet) für den Tablet-Computer wurde speziell für diese Studie programmiert. Die Ansicht des Labyrinths in der initialen Explorationsaufgabe und der Zuordnungsaufgabe ist in Abbildung 5 dargestellt.

Im Rahmen eines ersten Pre-Tests (n = 16) wurde der Gesamtablauf erprobt. Dies diente gleichzeitig als praktische Schulung der Versuchsleiterinnen, nachdem diese zuvor eine theoretische und technische Einführung erhalten hatten. Weiterhin wurde der Fragebogen vom Paper & Pencil-Format auf ein Online-Befragungstool (Sosci-Survey) umgestellt. Im Rahmen eines zweiten Pre-Tests (n = 18) wurde der Ablauf erneut getestet. Nach dem zweiten Pre-Test wurde der Fragebogen im Bereich der demografischen Angaben angepasst. Es wurden keine weiteren Änderungen vorgenommen.

2.3 Variablen und Messinstrumente

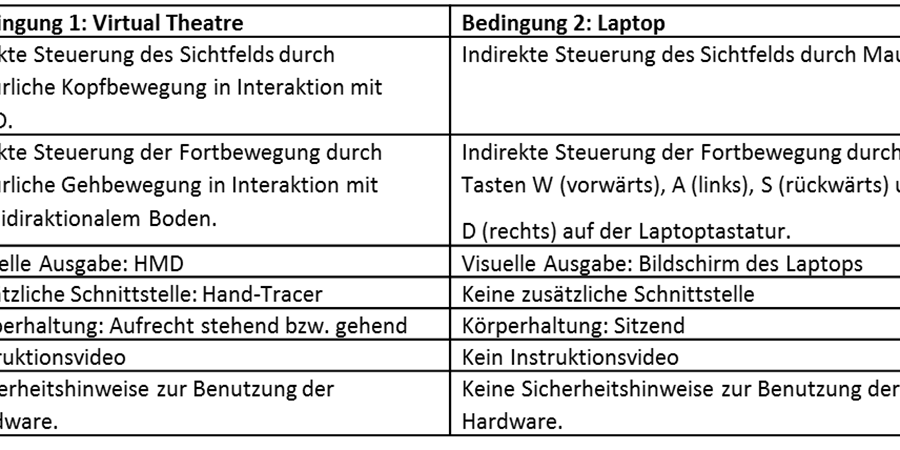

Im Folgenden werden die einzelnen Variablen des Quasi-Experiments sowie die dafür ausgewählten Messinstrumente näher beschrieben. Die Experimentalbedingung der Nutzung des Virtual Theatres unterschied sich von der Kontrollbedingung der Nutzung eines Laptops hinsichtlich der Ein- und Ausgabegeräte, der Steuerungsmodi und der daraus folgenden physischen Konsequenzen. Die erste unabhängige Variable fasst das Variablenset der Rezeptionssituation zusammen. Abbildung 6 zeigt eine Übersicht der Unterschiede zwischen den Versuchsbedingungen.

Neben demografischen Angaben wurde als personenbezogene, unabhängige Variable das domänenspezifische Interesse mit der Subskala des MEC-Spatial Presence Questionnaire[32] gemessen. Das Konstrukt bezieht sich ursprünglich auf die inhaltliche Ebene eines Medienangebots, wie z. B. das Thema eines Buchs oder eines Films. Die Instruktion zur Anwendung des MEC-SPQ sieht eine eigenständige Anpassung der Skala durch die Versuchsleitung vor.[33] Im Falle der hier entwickelten virtuellen Umgebung schien die Anpassung auf inhaltlicher Ebene jedoch unangemessen. Da sich Interessen auf bestimmte Themenfelder und Gegenstände, aber auch auf Tätigkeitsformen beziehen können[34], wurde die Subskala DSI des MEC-SPQ auf das Interesse an Computerspielen angepasst. Hier lag die Annahme zugrunde, dass Probanden, die häufig Computerspiele spielen, auch an die visuelle Ausgabe einer virtuellen Welt gewöhnt sind, was sich wiederum auf die Rezeption virtueller Lernumgebungen auswirken müsste. Dazu wurden die vier in der Subskala angelegten Items umformuliert, wie beispielsweise »An Computerspielen bin ich generell interessiert«. Zusätzlich zum Interesse an Computerspielen wurde die Spielfrequenz in pro Woche gespielten Stunden abgefragt.

Als abhängige Variablen wurden in dieser Studie Rezeptionsprozesse des Erlebens in Form von Präsenzerleben (erste abhängige Variable) und Flow-Erleben (zweite abhängige Variable) erhoben. Situative Emotionen (dritte abhängige Variable) wurden im Hinblick auf das Potenzial von Mixed Reality zur Steigerung der Lernmotivation ebenfalls abgefragt. Außerdem wurden drei verschiedene Leistungsparameter erfasst. Präsenzerleben wurde mit Subskalen des MEC-SPQ von Vorderer et al.[35] gemessen. Zu den Subskalen gehört das mentale Raummodell (Spatial Situation Model, kurz: SSM), mögliche Handlungen (Possible Actions, kurz: PA), Selbstlokalisierung (Self Location, kurz: SL), Hemmung der Rezeption durch bewusste Suche nach Fehlern, z.B. hinsichtlich der Grafik (Suspension of Disbelief, kurz: SOD) und die kognitive Involviertheit (Higher Cognitive Involvement, kurz: HCI).

Das mentale Raummodell (SSM) wurde mit vier Items abgefragt, z. B. »Ich hatte eine genaue Vorstellung von der in der virtuellen Umgebung dargestellten räumlichen Umgebung.« Mögliche Handlungen wurden ebenfalls mit vier Items, wie z. B. »Ich hatte den Eindruck, dass ich selbst in der dargestellten Umgebung aktiv werden konnte.«, gemessen. Auch Selbstlokalisierung wurde mit vier Items erhoben, z. B. »Es war so, als ob sich mein Standort in die präsentierte Umgebung verschoben hätte.« Hemmung durch Fehlersuche wurde mit vier Items, wie z. B. »Ich habe nicht besonders darauf geachtet, ob Fehler bzw. Widersprüche in der virtuellen Umgebung bestehen.«, erfasst. Die kognitive Involviertheit wurde mit acht Items gemessen, wie z. B. »Ich habe gründlich überlegt, inwiefern die dargestellten Dinge etwas miteinander zu tun haben.«

Flow-Erleben wurde mit den Subskalen der gedanklichen Absorbiertheit (vier Items, z. B. »Ich fühlte mich optimal beansprucht.«) sowie glatter automatisierter Verlauf (sechs Items, wie »Meine Gedanken bzw. Aktivitäten liefen flüssig und glatt.«) der Kurzskala von Rheinberg et al. erhoben (Flow-Kurzskala, kurz: FKS).[36] Situative Emotionen wurden mit der Differentiellen Affekt-Skala zur Erfassung von Emotionen bei der Mediennutzung (M-DAS) gemessen.[37] Dazu wurden 13 Subskalen mit jeweils drei Adjektiven (z. B. »amüsiert« für die Subskala Vergnügen) erfasst. Alle Selbsteinschätzungsvariablen wurden auf einer siebenstufigen Skala mit beschrifteten Extremen von »stimmt überhaupt nicht« bis »stimmt völlig« erfasst. Sie wurden im Rahmen des ersten Pre-Tests mit der Berechnung von Cronbachs Alpha auf interne Konsistenz geprüft und hinsichtlich interner Konsistenz und Ökonomie optimiert.

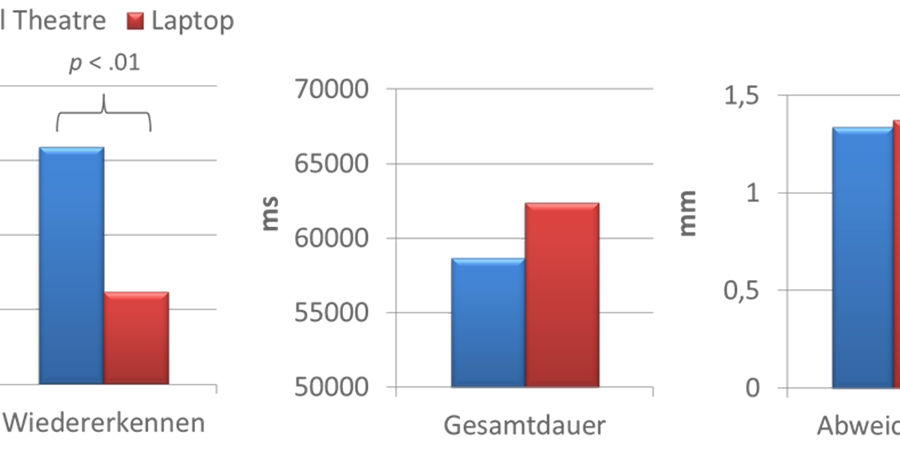

Als Leistungsparameter wurden die Anzahl korrekt aus dem Labyrinth wiedererkannter Objekte (vierte abhängige Variable), Gesamtdauer (fünfte abhängige Variable) sowie Genauigkeit (sechste abhängige Variable) der Zuordnung von Objekten zu ihren Positionen erhoben. Die Wiedererkennungsaufgabe wurde ebenfalls über das Online-Befragungstool abgefragt. Die Messung der Leistung in dieser Aufgabe wird im Folgenden als Wiedererkennen bezeichnet, gemessen wurde die Anzahl der Fehler im Test. Geschwindigkeit (Millisekunden) und Genauigkeit (Abweichung in Millimetern) wurden automatisiert von der App auf dem Tablet-Computer gemessen und gespeichert.

2.4 Stichprobe und statistische Auswertung

Die Teilnehmer der Studie waren allesamt Studierende der RWTH Aachen sowie der Fachhochschule Aachen. Um eventuellen Enttäuschungen vorzubeugen, wurden die Teilnehmer erst nach der Studie darüber in Kenntnis gesetzt, dass sie randomisiert in einer von zwei verschiedenen Bedingungen getestet wurden. In Bezug auf die Randomisierung muss jedoch einschränkend hinzugefügt werden, dass Studienteilnehmer, die angaben, starke visuelle Beinträchtigungen (z. B. starke Kurzsichtigkeit) oder Beinträchtigungen des Bewegungsapparats (z. B. Knieprobleme) zu haben, der Kontrollbedingung zugewiesen wurden.

Im Folgenden wird die Stichprobe genauer beschrieben. Genannt wird der Mittelwert eines gemessenen Wertes (allgemein bezeichnet mit M) und die Standardabweichung (allgemein bezeichnet mit SD, Standard Deviation) als Maß der Streuung. An der Studie nahmen insgesamt N = 38 Studierende teil, davon 25 männlich (65.8 %). Zwei Fälle mussten aufgrund von Versuchsabbruch im Virtual Theatre ausgeschlossen werden. Von den Probanden wurden 44.7 % im Mixed Reality-Simulator Virtual Theatre (n = 17) und 55.3 % am Laptop (n = 21) getestet. Auf Bedingungen bezogen war das Geschlechterverhältnis weitgehend ausgeglichen: Im Virtual Theatre wurden sechs Frauen (35.3%) und am Laptop sieben Frauen (33.3%) getestet. Das Durchschnittsalter betrug 24.71 Jahre (SD = 3.06). Auf die Bedingungen bezogen betrug das Durchschnittsalter im Virtual Theatre 25.33 Jahre (SD = 3.07) und am Laptop 23.94 Jahre (SD = 2.95).

Mit statistischen Methoden wurde untersucht, ob die Ergebnisse der Untersuchungen zufälliger oder systematischer Natur sind. Eine ausführliche Beschreibung über die hier genutzten Auswertungsmethoden und Hinweise darüber, wie die genannten Werte zu lesen sind, findet sich in zahlreichen Lehrbüchern der Statistik.[38] Mit univariaten, einfaktoriellen Varianzanalysen (ANOVAs) wird getestet, ob der Faktor der genutzten Hardware statistisch bedeutsame (= signifikante) Unterschiede in Bezug auf eine Zielvariable (z. B. Emotionen) hervorruft. Hierbei wird einerseits zur Überprüfung der Ergebnisse die relevante Teststatistik angegeben (z. B. F (1,36) = 10.93) und andererseits, ob es sich bei einem Unterschied um einen statistisch bedeutsamen Befund handelt. Ausschlaggebend hierfür ist die Über- oder Unterschreitung des gewählten Signifikanzniveaus, z. B. 5%, also die akzeptierte Fehlerwahrscheinlichkeit des Tests. Diese Fehlerwahrscheinlichkeit und die Über- oder Unterschreitung dieser Schwelle wird ebenfalls in der Teststatistik genannt (z. B.p > .05). Alle statistischen Ergebnisse wurden mit dem Computerprogramm SPSS ausgewertet.

2.5 Ergebnisse

Die Ergebnisse zeigen, dass die Nutzung des Virtual Theatres zu mehr Präsenzerleben führt als die Nutzung des Laptops (Abbildung 7). Signifikante Bedingungseffekte zeigen sich bei den Subskalen der Selbstlokalisierung (Self Location, F (1,36) = 15.75; p < .001) und den möglichen Handlungen (Possible Actions, F (1,36) = 4.90; p < .05).

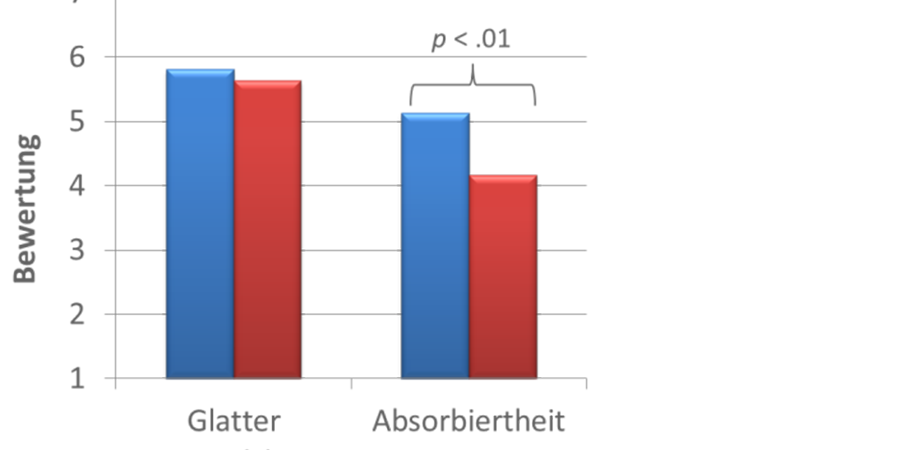

Der positive Einfluss von natürlichen Benutzerschnittstellen auf Flow-Erleben kann nur teilweise bestätigt werden. Hier zeigt sich ein signifikanter Unterschied zwischen den Bedingungen in der intendierten Richtung nur für die Subskala ›Absorbiertheit‹ (F (1, 36) = 10.63; p < .01, sig.). In der Subskala des glatten automatisierten Verlaufs gibt es keinen Unterschied zwischen den beiden Bedingungen (Abbildung 8).

Exemplarisch an Items der jeweiligen Subskalen beschrieben, führt die Nutzung des Mixed Reality-Simulators Virtual Theatre also dazu, dass Probanden vertieft in das sind, was sie gerade machen, selbstvergessen sind und nicht merken, wie die Zeit vergeht (= gedankliche Absorbiertheit). Die Nutzung des Mixed Reality-Simulators führt jedoch nicht dazu, dass die Probanden das Gefühl haben, den Ablauf unter Kontrolle zu haben, dass sie bei jedem Schritt wissen, was zu tun ist oder dass die Gedanken und Aktivitäten flüssig und glatt laufen (= glatter automatisierter Verlauf).[39]

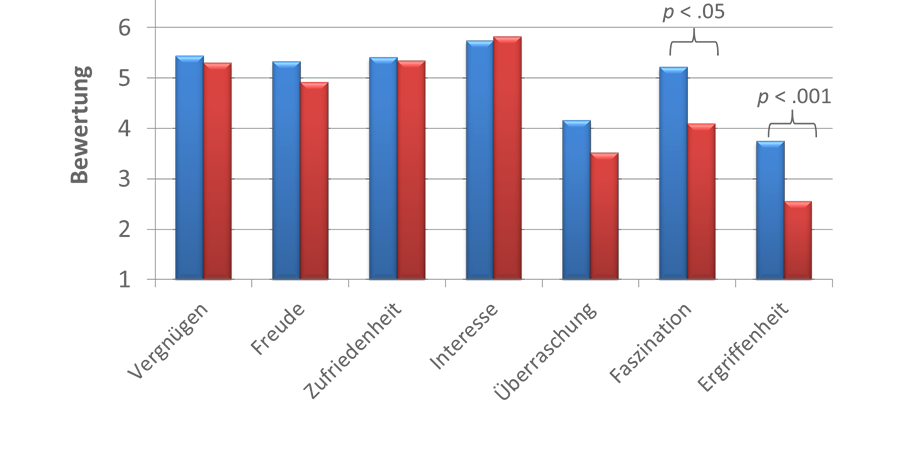

In Bezug auf die in der Rezeptionssituation erlebten Emotionen lässt sich festhalten, dass insgesamt mehr positive Emotionen im Virtual Theatre erlebt wurden (F (1, 36) = 6.18; p < .05; Abbildung 9). Dieser Effekt lässt sich auf die Subskalen ›Faszination‹ (F (1,36) = 6.22; p < .05) und ›Ergriffenheit‹ (F (1,36) = 15.62; p < .001) zurückführen, welche im Virtual Theatre deutlich ausgeprägter vorkamen.

Das Virtual Theatre führt nicht zu besseren Leistungen als die Laptop-Bedingung. In Bezug auf die Anzahl der Fehler im Gedächtnistest ›Labyrinth‹ zeigt sich ein gegenteiliger Effekt: Im Virtual Theatre werden signifikant mehr Fehler gemacht (F (1,36) = 10.93; p < .01) als am Laptop (Abbildung 10).

3. Diskussion

Im Vorfeld wurde angenommen, dass allein die technische Beschaffenheit der natürlichen Benutzerschnittstellen dazu beitragen kann, sich eher in einer virtuellen Umgebung als in der physisch realen Umwelt präsent zu fühlen. Die hochsignifikanten Ergebnisse der Varianzanalyse haben die positive Wirkung der natürlichen Benutzerschnittstelle auf Präsenzerleben bestätigt.

Im Vorfeld wurde außerdem angenommen, dass die technische Beschaffenheit der natürlichen Benutzerschnittstellen dazu beitragen kann, sich fokussiert einer Aufgabe zu widmen und somit Flow-Erleben zu initiieren. Dies haben die Ergebnisse der Datenauswertung bestätigt. In Bezug auf den glatten, automatisierten Verlauf wurde kein Unterschied zwischen den beiden Bedingungen festgestellt, was wiederum darauf zurückzuführen ist, dass Flow ein tätigkeitsspezifisches Konstrukt ist. Der flüssige Verlauf der Gedanken in Bezug auf eine Tätigkeit wird somit anscheinend nach der virtuellen Umgebung beurteilt.

Die positiveren Emotionen im Virtual Theatre lassen sich dadurch erklären, dass alleine das Erlebnis, virtuelle Umgebungen mit natürlichen Benutzerschnittstellen zu erkunden, positive Emotionen initiiert. Das Virtual Theatre als solches vermag insbesondere mehr Faszination und Ergriffenheit auszulösen, als die gleiche Aufgabe an einem Laptop auszuführen. Dies könnte durch den Neuigkeitswert der Technologie begründet sein, welcher wiederum an das Motiv der Neugier der Probanden appelliert haben könnte.[40]

Eines der entscheidendsten Ergebnisse dieser Studie ist, dass die Probanden im Virtual Theatre keine besseren Ergebnisse erzielt haben, als die Probanden am Laptop. Im Gegenteil: in Bezug auf das Wiedererkennen der Objekte lieferte diese Gruppe sogar eine signifikant schlechtere Leistung als die Gruppe am Laptop. Das Ergebnis könnte zum einen schlicht auf zu viele Störfaktoren zurückzuführen sein, die noch mit der Technik des Virtual Theatre einhergehen, wie z. B. der Lautstärkepegel des omnidirektionalen Bodens oder ergonomische Aspekte des Head Mounted Displays. Wären solche technischen Optimierungsaspekte einmal abgeschlossen, so könnte man auch im Virtual Theatre bessere Lernergebnisse erwarten. Zum anderen drängt sich an dieser Stelle jedoch der Verdacht auf, dass die Steuerung virtueller Lernumgebung über natürliche Benutzerschnittstellen zumindest bei Erstbenutzung eine Aufgabe ist, die kognitive Ressourcen benötigt. Mit anderen Worten: So natürlich, wie es der Steuerungsmodus vorgibt zu sein, ist er nicht. Es scheint sich um Eingabemuster zu handeln, die den natürlichen Bewegungen zwar stark ähneln, aber sich so hinreichend von ihnen unterscheiden, dass sie zumindest geübt werden müssen.[41]. Hierfür ist die in der Studie gegebene Vorbereitungszeit von drei Minuten nicht ausreichend. Ist das motorische Programm einmal gespeichert und automatisiert, so stünden den Rezeptionsprozessen der Informationsverarbeitung wieder mehr kognitive Ressourcen zur Verfügung.

Eine weitere Interpretation der schlechteren Lernergebnisse im Mixed Reality-Szenario ist die Überlappung von Immersion und Kognition. So ist es allein schon durch die technische Isolation des Head Mounted Displays bedingt, dass mehr Aufmerksamkeit auf die virtuelle Lernumgebung gelenkt wird, als dies beim Vergleichsszenario am Laptop der Fall ist. Die Aufnahme dieser zusätzlichen visuellen Reize aus der Lernumgebung könnte von der Bearbeitung der eigentlichen inhaltlichen Aufgabe ablenken.

4. Ausblick: Mit Mixed Reality zum ›Virtual Turn‹ in den

Erziehungswissenschaften?

Insbesondere zu einem späteren Zeitpunkt im Rahmen der Forschung an natürlichen Benutzerschnittstellen in der Hochschullehre wird es notwendig sein, neben Daten der potenziellen Nutzergruppe der Studierenden auch die Anforderungen von Lehrenden zu erheben. Hier geht es vor allem um inhaltliche Aspekte der Gestaltung von virtuellen Lernumgebungen, damit diese auch ein bestimmtes didaktisches Anliegen einlösen.

Das vermeintlich unbefriedigende Ergebnis der schlechteren Leistung im Mixed Reality-Szenario verdeutlicht paradoxerweise das große Potenzial, was sich hinter der neuen Technologie verbirgt: Die realistische Nachbildung einer späteren Anwendungssituation des im schulischen oder hochschulischen Kontext erworbenen Wissens. Denn auch die physische Realität zeichnet sich durch ein hohes Maß an Komplexität und sachfremder Beanspruchung aus. Hierauf kann eventuell ein Lernmodul im Mixed Reality-Simulator besser vorbereiten, als eines, das am Laptop absolviert wird. Aus ethischer Perspektive scheint dies insbesondere für jene Situationen sinnvoll zu sein, in denen Fehlverhalten zu gesundheitlichen Schäden der Person selbst oder anderer beteiligter Personen führen würde. Im Hinblick auf den im Bereich der Hochschullehre häufig diskutierten mangelnden Praxisbezug liefert das junge Forschungsgebiet der Mixed Reality also neue Möglichkeiten.

Die Ergebnisse bestätigen die Notwendigkeit, natürliche Benutzerschnittstellen hinsichtlich ihres technischen Potenzials immer mit den tatsächlich erlebten Emotionen und Wahrnehmungsparametern der Nutzergruppen abzugleichen. Durch eine genaue Überprüfung des Zusammenhangs zwischen Nutzerin bzw. Nutzer, Hardware, virtueller Umgebung und Lernerfolg ist es möglich, die Bedeutung von Immersion für Lernprozesse in virtuellen Umgebungen weiter zu erforschen. Die technische Optimierung natürlicher Benutzerschnittstellen in enger Verzahnung mit der durchdachten und reflektierten Entwicklung passender virtueller Lernszenarien ist für die Erziehungswissenschaften eine mögliche Option, sich mit dieser Art der neuen Methodik der Entwicklung neuer Lösungen für die Vermittlung von Lerninhalten zu widmen.[42] In Zeiten fortschreitender Digitalisierung aller Gesellschaftsbereiche, demografischen Wandels und hohen Bedarfs nach gut ausgebildeten Fachkräften werden auch die Erziehungswissenschaften nicht umhin kommen, neue Informations- und Kommunikationstechnologien hinsichtlich ihrer Effektivität und ihrer Effizienz zu testen. Ob sich damit auch eine weitere methodische Wende im Sinne eines ›Virtual Turns‹ der Didaktik vollziehen wird, kann nur eine stetige Forschung im Gebiet der virtuellen und gemischten Realität in Bezug auf Lernprozesse zeigen.

Fußnoten

-

[1]Fatke / Oelkers 2014, S. 7.

-

[2]Vgl. Fatke / Oelkers 2014, S. 8.

-

[3]Vgl. Fatke / Oelkers 2014, S. 9.

-

[4]Vgl. Fatke / Oelkers 2014, S. 12.

-

[5]Sahle et al. 2011, S. 4.

-

[6]Vgl. Kerres 2012, S. 12.

-

[7]Vgl. Höntzsch 2013, S. 2.

-

[8]Vgl. Jeschke 2004, S. 172.

-

[9]Vgl. Ewert et al. 2013, S. 5.

-

[10]Vgl. Flin et al. 2010, S. 40.

-

[11]Vgl. Höntzsch 2013, S. 2.

-

[12]Vgl. Ewert et al. 2013, S. 1.

-

[13]Vgl. Hoffmann et al. 2013, S. 46.

-

[14]Vgl. Willenbrock 2012, S. 89.

-

[15]Vgl. Groner et al. 2008, S. 427.

-

[16]Vgl. Curtis / Voss 2008, S. 3.

-

[17]Murray 1999, S. 98f.

-

[18]Vgl. Witmer / Singer 1998, S. 238; Höntzsch et al. 2013, S. 3.

-

[19]Vgl. Höntzsch et al. 2013, S. 3; Breuer 2010, S. 11.

-

[20]Breuer 2010, S. 11.

-

[21]Vgl. Höntzsch et al. 2013, S. 2; Hebbel-Seeger 2012, S. 29; Bredl / Groß 2012, S. 37; Zender / Lucke 2012, S. 47; Tarouco et al. 2013, S. 774.

-

[22]Vgl. Höntzsch et al. 2013, S. 4, Bredl / Groß 2012, S. 37.

-

[23]Vgl. Witmer / Singer 1998, S. 238, Bredl / Groß 2012, S. 37.

-

[24]Sahle et al. 2011, S. 4.

-

[25]Vgl. Bortz / Döring 2006, S. 523.

-

[26]Vgl. Cook / Campbell 1979, S. 6; Kelle 2007, S. 208.

-

[27]Vgl. Wirth / Hofer 2008, S. 161.

-

[28]Vgl. Vorderer et al. 2004, S. 3.

-

[29]Vgl. Rheinberg et al. 2003, S. 271.

-

[30]Vgl. Köhler et al. 2008, S. 481.

-

[31]Vgl. Nash et al. 2000, S. 3.

-

[32]Vgl. Vorderer et al. 2004, S. 12.

-

[33]Vgl. Vorderer et. al, S. 5.

-

[34]Vgl. Krapp 2009, S. 53.

-

[35]Vgl. Vorderer et al. 2004, S. 3.

-

[36]Vgl. Rheinberg et al. 2003, S. 271.

-

[37]Vgl. Renaud / Unz 2006, S. 73.

-

[38]Vgl. Bortz / Döring 2006, S. 196.

-

[39]Vgl. Rheinberg et al. 2003, S. 271.

-

[40]Vgl. Edelmann 1996, S. 361.

-

[41]Vgl. Kiesel / Koch 2012, S. 115.

-

[42]Vgl. Fatke / Oelkers 2014, S. 7.

Bibliographische Angaben

- Jürgen Bortz / Nicola Döring: Forschungsmethoden und Evaluation für Human- und Sozialwissenschaftler. 4. überarbeitete Auflage. Heidelberg 2006. [Nachweis im GBV]

- Klaus Bredl / Amrei Groß: Gestaltung und Bewertung von Lernszenarien in immersiven virtuellen Welten. In: Lernen und Lehren in virtuellen Welten. Zeitschrift für E-Learning – Lernkultur und Bildungstechnologie 7 (2012), H. 1, S. 36–46. [Nachweis im GBV]

- Johannes Breuer: Spielend Lernen? Eine Bestandsaufnahme zum (Digital) Game-Based Learning. Landesanstalt für Medien Nordrhein-Westfalen (LfM). Düsseldorf 2010. [online]

- Thomas D. Cook / Donald T. Campbell: Quasi-Experimentation. Design & Analysis Issue for Field Settings. Chicago 1979. [Nachweis im GBV]

- Robin Curtis / Christiane Voss: Theorien ästhetischer Immersion. In: Montage AV. Zeitschrift für Theorie und Geschichte audiovisueller Kommunikation (2008), S. 3–10. [Nachweis im GBV]

- Walter Edelmann: Lernpsychologie. 5. Auflage. Weinheim 1996. [Nachweis im GBV]

- Daniel Ewert / Katharina Schuster / Daniel Schilberg / Sabine Jeschke: Intensifying learner’s experience by incorporating the virtual theatre into engineering education. In: Proceedings of the 2013 IEEE Global Engineering Education Conference (EDUCON 2013). Hg. von Institute of Electrical and Electronics Engineers (IEEE). Berlin 2013, S. 207–2012. [Nachweis im GBV]

- Reinhard Fatke / Jürgen Oelkers: Das Selbstverständnis der Erziehungswissenschaft: Geschichte und Gegenwart. In: Zeitschrift für Pädagogik 60 (2014), Beiheft 60, S. 7–13. [Nachweis im GBV]

- Rohna Flin / Rona Patey / Ronnie Glavin /Nikki Maran: Anaesthesists’ non-technical skills, in: British Journal of Anaesthesia 105 (2010), H. 1, S. 38–44. [Nachweis im GBV]

- Rudolf Groner / Simon Raess / Phillip Sury: Usability: Systematische Gestaltung und Optimierung von Benutzerschnittstellen. In: Medienpsychologie. Hg. von B. Batinic / M. Appel. Heidelberg 2008, S. 425–446. [Nachweis im GBV]

- Andreas Hebbel-Seeger: Motiv: Motivation?! – Warum Lernen in virtuellen Welten (trotzdem) funktioniert. In: Lernen und Lehren in virtuellen Welten. Zeitschrift für E-Learning – Lernkultur und Bildungstechnologie 7 (2012), H.1, S. 23–35. [Nachweis im GBV]

- Susan Höntzsch / Uwe Katzky / Klaus Bredl / Frank Kappe / Dirk Krause: Simulationen und simulierte Welten. Lernen in immersiven Lernumgebungen. In: Martin Ebner / Sandra Schön: Lehrbuch für Lernen und Lernen mit Technologien. 2013. [online]

- Max Hoffmann / Katharina Schuster / Daniel Schilberg / Sabine Jeschke: Bridging the Gap between Students and Laboratory Experiments. In: Virtual, Augmented and Mixed Reality. Applications of Virtual and Augmented Reality. 6th International Conference, VAMR 2014, Held as Part of HCI International 2014, Heraklion, Greece, June 22–27, 2014, Proceedings, Part II. Hg. von R. Shumaker / S. Lackey. Heidelberg, S. 39–50. [Nachweis im GBV]

- Sabina Jeschke: Mathematik in Virtuellen Wissensräumen – IuK-Strukturen und IT-Technologien in Lehre und Forschung. Berlin, Techn. Univ., Diss., 2004. [Nachweis im GBV]

- Udo Kelle: Die Integration qualitativer und quantitativer Methoden in der empirischen Sozialforschung. Theoretische Grundlagen und methodologische Konzepte. Wiesbaden 2007. [Nachweis im GBV]

- Michael Kerres: Mediendidaktik. Konzeption und Entwicklung mediengestützter Lernangebote. München 2012. [Nachweis im GBV]

- Andrea Kiesel / Iring Koch: Lernen. Grundlagen der Lernpsychologie. Wiesbaden 2012. [Nachweis im GBV]

- Thomas Köhler / Nina Kahnwald / Martina Reitmaier: Lehren und Lernen mit Multimedia und Internet. In: Medienpsychologie. Hg. von B. Batinic / M. Appel. Heidelberg 2008, S. 477–501. [Nachweis im GBV]

- Andreas Krapp: Interesse. In: Handbuch der Allgemeinen Psychologie – Motivation und Emotion. Hg. von V. Brandstätter / J. H. Otto. Göttingen 2009, S. 52–57. [Nachweis im OPAC]

- Janet H. Murray: Hamlet on the Holodeck. The Future of Narrative in Cyberspace. Cambridge, Mass. 1999. [Nachweis im GBV]

- Eric. B. Nash / Gregory W. Edwards / Jennifer A. Thompson / Woodrow Barfield: A Review of Presence and Performance in Virtual Environments. In: International Journal of Human-Computer Interaction 12 (2000), H. 1, S. 1–41. [Nachweis im GBV]

- Dagmar Renaud / Dagmar Unz: Die M-DAS – eine modifizierte Version der Differentiellen Affekt Skala zur Erfassung von Emotionen bei der Mediennutzung. In: Zeitschrift für Medienpsychologie 18 (2006), H. 2, S. 70–75. [Nachweis im GBV]

- Falko Rheinberg / Regina Vollmeyer / Stefan Engeser: Die Erfassung des Flow-Erlebens. In: Diagnostik von Motivation und Selbstkonzept. Test und Trends. Hg. von J. Stiensmeier-Pelster / F. Rheinberg. Göttingen 2003, S. 261–279. [Nachweis im GBV]

- Patrick Sahle: Digitale Geisteswissenschaften. Hg. vom CCeH, Universität zu Köln. Erstellt im Rahmen des Projekts DARIAH-DE; gefördert vom Bundesministerium für Bildung und Forschung (BMBF) 2011. [online]

- Liane Tarouco / Bárbara Gorziza / Ygor Corrêa / Erico M.H. Amaral / Thaísa Müller: Virtual Laboratory for Teaching Calculus: an Immersive Experience. In: Proceedings of the 2012 IEEE Global Engineering Education Conference (EDUCON 2012). Hg. von Institute of Electrical and Electronics Engineers (IEEE). Berlin 2012, S. 774–781. [Nachweis im GBV]

- Peter Vorderer / Werner Wirth / Felize Ribeiro Gouveia / Frank Biocca / Timo Saari / Lutz Jäncke / Saskia Böcking / Holger Schramm / Andre Gysbers / Tilo Hartmann / Christoph Klimmt / Jari Laarni / Nicklas Ravaja / Ana Sacau / Thomas Baumgartner / Petra Jäncke: MEC Spatial Presence Questionnaire (MEC-SPQ): Short Documentation and Instructions for Application. Report to the European Community, Project Presence: MEC (IST-2001-37661), 2004. [online]

- Harald Willenbrock: Wie im richtigen Leben. In: Brandeins 14 (2012), H. 10, S. 86–91. [Nachweis im GBV]

- Werner Wirth / Matthias Hofer: Präsenzerleben. Eine medienpsychologische Modellierung. In: Montage AV. Zeitschrift für Theorie und Geschichte audiovisueller Kommunikation 2008, S. 159–175. [Nachweis im GBV]

- Bob G. Witmer / Michael J. Singer: Measuring Presence in Virtual Environments: A Presence Questionnaire. In: Presence: Teleoperators and Virtual Environments 7 (1998), H. 3, S. 225–240. [Nachweis im GBV]

- Raphael Zender / Ulrike Lucke: Synchronisationsmechanismen in Mixed Reality-Arrangements. In: Lernen und Lehren in virtuellen Welten. Zeitschrift für E-Learning – Lernkultur und Bildungstechnologie 7 (2012), H. 1, S. 47–60. [Nachweis im GBV]

Abbildungslegenden und -nachweise

- Abb. 1: Das Virtual Theatre mit Nutzerin und (vereinfachter) virtueller Umgebung (Foto: Walter Spanjersberg, 2013).

- Abb. 2: Datenhandschuh, Hand-Tracer sowie entsprechende Darstellungen in einer virtuellen Umgebung (Fotos: Peer Schlieperskötter, 2014).

- Abb. 3: Erwarteter Zusammenhang zwischen Medienangebot, Person, Situation, Rezeptionsprozessen und Wirkung (Grafik: Katharina Schuster, 2013).

- Abb. 4: Versuchsablauf des ›Quasi-Experiments‹ am Beispiel der Experimentalbedingung (Grafik: Katharina Schuster, 2013).

- Abb. 5: Ansicht der virtuellen Umgebung in der ersten und dritten Aufgabe (Foto: Walter Spanjersberg, 2013).

- Abb. 6: Übersicht: Unterschiede beider Versuchsbedingungen des ›Quasi-Experiments‹ (Grafik: Katharina Schuster, 2014).

- Abb. 7: Präsenzerleben im Vergleich beider Versuchsbedingungen (Grafik: Katharina Schuster, 2014; Screenshot aus Excel, 14.03.2014).

- Abb. 8: Flow-Erleben im Vergleich beider Versuchsbedingungen (Grafik: Katharina Schuster, 2014; Screenshot aus Excel, 14.03.2014).

- Abb. 9: Positive Emotionen im Vergleich beider Versuchsbedingungen (Grafik: Katharina Schuster, 2014; Screenshot aus Excel, 14.03.2014).

- Abb. 10: Leistung im Vergleich beider Versuchsbedingungen (Grafik: Katharina Schuster, 2014; Screenshot aus Excel, 14.03.2014).