DOI: 10.17175/sb001_002

Nachweis im OPAC der Herzog August Bibliothek: 830123016

Erstveröffentlichung: 19.02.2015

Medienlizenzen: Medienrechte liegen bei den Autoren

Letzte Überprüfung aller Verweise: 24.05.2016

GND-Verschlagwortung: Bildwissenschaft | Kunstgeschichte (Fach) | Digital Humanities | Bildverarbeitung |

Empfohlene Zitierweise: Katja Kwastek: Vom Bild zum Bild – Digital Humanities jenseits des Textes. In: Grenzen und Möglichkeiten der Digital Humanities. Hg. von Constanze Baum / Thomas Stäcker. 2015 (= Sonderband der Zeitschrift für digitale Geisteswissenschaften, 1). text/html Format. DOI: 10.17175/sb001_002

Abstract

Dieser Beitrag widmet sich der historischen Entwicklung und den methodischen Herausforderungen der digitalen Bildforschung. Obwohl bereits früh argumentiert wurde, der Computer sei für formale Analysen besser geeignet als für ikonographische, war die digitale Bildwissenschaft lange Zeit von Projekten der ikonographischen Codierung bildlicher Darstellungen und der strukturierten Erfassung von Metadaten bestimmt. Gleichzeitig wurden schon früh Rufe nach einer ›Ideologiekritik‹ laut. Heute umfasst die digitale Bildwissenschaft ein breites Spektrum nicht nur formalanalytischer und ikonographischer, sondern auch rezeptionsästhetischer Forschungen. Ihr ideologiekritischer Ansatz kann zudem dazu beitragen, die kritische Reflektion methodischer Implikationen als Kernaufgabe der Digital Humanities zu etablieren.

This paper outlines the historical development and methodical challenges of digital visual studies. Although it was argued early on that the strength of the computer lay in formal rather than iconographic analysis, in practice the iconographic encoding of images and the collection of metadata dominated for a long time. However, scholars and practitioners of digital visual studies soon demanded a thorough ›Ideologiekritik‹ (›critique of ideology‹) of its methods. Today, the field encompasses a broad spectrum of formal and iconographical, as well as reception-based studies. Furthermore, it can help to establish the critical reflection on methodical implications as a core issue for the digital humanities.

1. Disclaimer

Ich möchte diesen Beitrag[1] mit einer Art Disclaimer beginnen: Wenn ich hier und heute als Kunsthistorikerin und als ›Advokatin des Bildes‹ spreche, dann bedeutet das keineswegs, dass eine ›digitale Kunstgeschichte‹ ausschließlich im Bereich der Sammlung, Analyse und Interpretation von Bilddaten aktiv sein sollte. Eine rein bildbasierte Wissenschaft ist wohl weder möglich noch erstrebenswert. Auch Kunsthistorikerinnen und Kunsthistoriker wenden sich mich mit Worten an ihr Publikum, publizieren ihre Forschungen in Form von Texten. Auch für die Kunstgeschichte liegt ein großes Potential sowohl in den neuen Formen der Wissenschaftskommunikation und -organisation, die digitale Medien bieten, als auch in der Text- und (Meta-)Datenanalyse.

Jedoch nehmen unsere Forschungen ihren Ausgangspunkt in historischen und zeitgenössischen Artefakten, die (meist) visuell und (noch) zum überwiegenden Teil materiell sind. Daher sind wir natürlich daran interessiert, wie sich diese visuelle und materielle Überlieferung mittels digitaler Technologien analysieren lässt und welche Rolle wiederum visuelle Medien und bildbasierte Technologien – als Medium dieser Analyse selbst – spielen können.

Denn neben der meist auf Giorgio Vasari zurückgeführten, textlich fixierten Kunstgeschichtsschreibung gab es immer auch Versuche, die Geschichte der Kunst anhand von Objektsammlungen und Zusammenstellungen visueller Reproduktionen zu (re)konstruieren. Während erstere zur Einrichtung von Museen und Ausstellungen führten, reichen letztere von frühen Galeriebildern über Stichsammlungen und Gipsabgusssammlungen bis hin zu Aby Warburgs Mnemosyne-Atlas. Letztlich basieren sie alle auf der Idee des Erkenntnisgewinns durch vergleichendes Sehen.

Fragt man aber nach den Ursprüngen der digitalen Kunstgeschichte, so schließt diese weder direkt an die textuelle Analyse noch an die Tradition des vergleichenden Sehens an. Ihre Anfänge liegen vielmehr in Versuchen der Bildcodierung, die sich zunächst dem Bildinhalt (der Ikonographie) und darauf der formalen Komposition zuwandten. Damit komme ich zum zweiten Abschnitt meines Beitrags, den ich biographisch einleiten möchte.

2. Von ICONCLASS zur Ideologiekritik

Der erste internationale Kunsthistorikerkongress, den ich besucht habe, fand 1992 in Berlin statt. Auf diesem Kongress gab es einen Stand des Deutschen Dokumentationszentrums Kunstgeschichte, das damals noch unter dem Namen Foto Marburg firmierte. Beim Besuch an diesem Stand lernte ich vier Akronyme kennen: HiDA, MIDAS, DISKUS und ICONCLASS. HiDA, der ›Hierarchische Dokument-Administrator‹, ist eine Software, mittels derer MIDAS, das ›Marburger Informations-, Dokumentations- und Administrations-System‹[2], bereitgestellt wird. DISKUS steht schließlich für ›Digitales Informationssystem für Kunst und Sozialgeschichte‹, ein von der Volkswagenstiftung geförderter Datenverbund, dem sich zunächst große deutsche Museen, später auch Archive und Denkmalämter anschlossen, um ihre mittels HiDA-MIDAS erfassten Daten kontinuierlich auszutauschen.[3]

Ich war begeistert von der vorgestellten Vision, mit diesen Systemen eine große, kollaborative Bilddatenbank zur Kunst und Architektur zu erstellen. Da ich in Köln studierte und das dortige Rheinische Bildarchiv Projektpartner von Foto Marburg war, sprach ich sofort dort vor und wurde prompt als studentische Hilfskraft angestellt. Hier lernte ich dann ICONCLASS kennen, ein System zur Dezimalklassifikation von Ikonographie, das – wie ich lernen sollte – seit den 1950er Jahren durch den niederländischen Kunsthistoriker Henry van de Waal entwickelt worden war. Mithilfe dieses Systems kann man eine Abendmahlsdarstellung, die den Streit unter den Aposteln darüber, wer unter ihnen der Größte ist, zeigt, in den Dezimalcode 73D22 übersetzen, der aus der hierarchischen Folge ›7 Bibel / 73 Neues Testament / 73D Passion Christi / 73D2 Abendmahl / 73D22 Streit unter den Aposteln, wer unter ihnen der Größte ist‹ resultiert. Solche Verschlagwortungen erscheinen uns im Zeitalter von Web 2.0 vielleicht recht normativ, aber sie ermöglichen es heute, im Online-Archiv von Foto Marburg faszinierende ikonographische Suchanfragen durchzuführen.

Prägend für meine Sozialisation innerhalb dessen, was wir heute ›digitale Geisteswissenschaften‹ nennen, waren allerdings weniger DISKUS und ICONCLASS, als die Tatsache, dass die Museumsinformatik an den Kölner Museen schon damals unter der Ägide von Tobias Nagel stand. Er ist nicht nur Theologe und Kunsthistoriker, sondern auch begeisterter Fachinformatiker. Dennoch trat er vehement für eine Ideologiekritik der ›EDV im Museum‹ (so hieß es damals noch unprätentiös) ein: »Nicht das Prinzip des Machbaren hat zu gelten«, so Nagel, »sondern jeder einzelne Schritt muss auf seine Konsequenzen hin untersucht werden.«[4] Ich lernte also, bei der Anwendung digitaler Technologien immer kritisch zu hinterfragen, in welcher Relation sie zur kunsthistorischen Methodik stehen und ob sie dem zu bearbeitenden Forschungsgegenstand gerecht werden.

Die Frage nach den methodischen Konsequenzen des Einsatzes digitaler Technologien stellte zur gleichen Zeit auch der britische Kunsthistoriker William Vaughan, Spezialist für die Kunst des 19. Jahrhunderts und langjähriger Vorsitzender der bereits 1986 gegründeten, britischen CHArt (Computers and the History of Art) Vereinigung. Vaughan war davon überzeugt, dass digitale Technologien der kunsthistorischen Forschung die Möglichkeit eröffneten, sich von der Orientierung an der Linguistik als »Meisterdisziplin«[5] wieder zu lösen.

Dies bringt uns zurück zu dem Vergleich von textbasiertem und bildbasiertem Ansatz. Während der linguistic turn dazu geführt habe, formanalytische Methoden zugunsten ikonographischer Analysen zu vernachlässigen, liege, so Vaughan »[i]m Hinblick auf die Computerisierung der Kunstgeschichte […] die Ironie dieser Situation darin begründet, daß sich der formanalytische Zugriff erheblich besser automatisieren lässt als der ikonographische und der erzähltheoretische.«[6] Seine These basiert auf der Überzeugung, dass Maschinen formale Charakteristika besser identifizieren können als ikonographische. Auch wenn diese Argumentation einleuchtet, hat sie sich auf die breite Praxis der digitalen Kunstgeschichte lange Zeit kaum ausgewirkt. Dies liegt daran, dass Vaughans These auf der Annahme einer Automatisierung der kunstwissenschaftlichen Bildanalysepraktiken beruhte. Auch wenn sich – darauf komme ich im Folgenden zurück – formanalytische Ansätze besser automatisieren lassen, so basieren unsere großen digitalen Bildrepositorien wie prometheus oder der Marburger Bildindex jedoch bis heute primär auf von Menschen vorgenommenen, textuellen Verschlagwortungen von Bildinhalten und externen Informationen. Die automatische Bildanalyse ist hingegen – noch? – auf einzelne Forschungsprojekte beschränkt.

Für mich persönlich wurde die Notwendigkeit einer ideologiekritischen Reflexion jedoch weniger hinsichtlich einer Abwägung zwischen formanalytischen und ikonographischen Analyseansätzen relevant, als vielmehr in dem Moment, als mir 1994 die Aufgabe übertragen wurde, die Neuerwerbungen des Museum Ludwig mittels HiDA-MIDAS zu inventarisieren. Eines der ersten Werke, das ›auf meinen Tisch kam‹, war eine Arbeit des amerikanischen Künstlers James Lee Byars. Er hatte gerade den Wolfgang-Hahn-Preis gewonnen und führte eine seiner in diesem Zusammenhang vom Museum erworbenen Arbeiten anlässlich der Preisverleihung auf. Die Arbeit mit dem Titel The Perfect Smile besteht in einer Performance, in der der Künstler dem Publikum für einen kurzen Moment sein Lächeln schenkt. Selbstverständlich wollte Byars' Lächeln als Neuerwerbung des Museum Ludwig ordnungsgemäß inventarisiert werden. Informationen wie Inventarnummer und Ankaufsdatum ließen sich denn auch problemlos erfassen. Selbst der ›lächelnde Mann‹ ist noch mittels ICONCLASS codierbar. Doch eigentlich wird er ja nicht dargestellt, sondern er verkörpert das Werk. Und welcher Gattung ist die Arbeit zuzuordnen? Was ist ihr Material? Besteht die Arbeit wirklich im Lächeln selbst – oder doch eher in der Idee des Verkaufs eines Lächelns?

Sicher hatten die Schwierigkeiten, die ich mit der datenbanktechnischen Erfassung dieser Arbeit hatte, zum Teil damit zu tun, dass Byars' Lächeln ein Werk der Performancekunst ist, während HiDA-MIDAS seinen Ausgangspunkt in der Erfassung von Objekten nimmt. Das eigentliche Problem liegt aber darin begründet, dass Werke der Kunst sich einer eindeutigen ontologischen Festlegung oft entziehen. Nicht ohne Grund verfügt die Kunstgeschichte ja neben der ikonographischen und formalanalytischen Methode noch über viele andere, kultur- und sozialhistorische sowie rezeptionsästhetische Analysemethoden – die Frage ist nur, wie diese sinnvoll in eine digitale Kunstgeschichte zu integrieren sind. Darauf wird zurückzukommen sein.

Mir wurde spätestens bei der Erfassung von Byars' Lächeln klar, wer eigentlich von der computergestützten Erfassung am meisten profitiert: der Erfasser selbst. Datenbanklogik und individuelle Charakteristika eines Kunstwerks zusammenzubringen erfordert von der Wissenschaftlerin oder dem Wissenschaftler eine äußerst intensive Auseinandersetzung mit der jeweiligen Arbeit; sie oder er wird gezwungen, deren Eigenheiten auf den Grund zu gehen, um diese entsprechend abstrahiert in einer Datenbank repräsentieren zu können. Denn die Datenbank stellt mittels vorgegebener Felder auch genau die Fragen, die wir in der traditionellen Werkanalyse allzu gerne immer dann ignorieren, wenn sie unserem aktuellen Forschungsinteresse entgegenstehen, schwer beantwortbar oder vermeintlich ›irrelevant‹ sind.

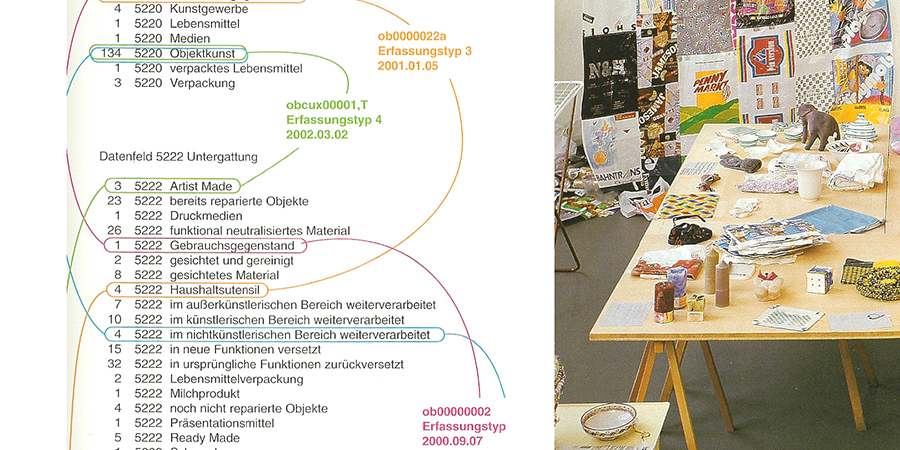

Das hat beispielsweise auch die Künstlerin Nana Petzet realisiert und die Inventarisierung ihrer aus Alltagsgegenständen selbst gefertigten Objekte mittels HiDA-MIDAS als eigenständiges, institutionskritisches Kunstprojekt präsentiert. In ihrem System SBF (seit 1995) – schon der Titel ironischer Kommentar zum ›Sammeln-Bewahren-Forschen‹-Paradigma der musealen Kunstgeschichte – lud sie zur Inventarisierung ihrer Objekte mittels HiDA-MIDAS ein. Damit stellte sie die Archivare beispielsweise vor die Herausforderung, die verschiedenen Plastiktüten, aus denen ein von der Künstlerin genähter Duschvorhang bestand, minutiös nach jeweiligem Hersteller, Herstellungsort und Ikonographie zu dokumentieren oder die ›Provenienz‹ mehrfach wiederverwendeter und umfunktionierter Gegenstände – von Schenkungen der Großmutter über Umarbeitungen durch den Onkel, über partielle Zerstörung durch einen Gast, die Reparatur durch den Besitzer bis zur Aneignung als Kunstwerk durch die Künstlerin – en détail zu erfassen (Abbildung 1).[7]

3. Maschinenlesbarkeit: Vom Digitalisat zur Formanalyse

Ich habe im ersten Teil meines Beitrags drei wichtige Fragen der digitalen Geisteswissenschaften angesprochen: Wie repräsentiere ich materielle Artefakte in Form maschinenlesbarer Information? Wie verhalten sich digitale Technologien zu tradierten Methoden des Faches? Und wie gehe ich mit Kunstprojekten um, die weder Text noch Bild, sondern ›Gebilde‹ oder sogar Prozesse sind?

Kehren wir dennoch zunächst zum zweidimensionalen Bild zurück – und zwar in Bezug auf die Frage nach seiner Maschinenlesbarkeit. Gerade in der Frühzeit der Computergraphik lag der Einwand nahe, dass das Bild in seiner traditionellen Form als individuell gefertigtes Artefakt eben nicht aus diskreten Informationseinheiten besteht, was zur Folge hat, dass bei seiner digitalen Reproduktion unweigerlich Informationen verloren gehen.

Heute stellt diese Tatsache für den Großteil der kunsthistorischen Forschung allerdings eher ein ontologisches als ein praktisches Hindernis dar. Wir sind es gewohnt, mit Reproduktionen zu arbeiten, kennen aber auch ihre Grenzen und wissen, dass bei spezifischen stilistischen oder rezeptionsästhetischen Forschungsfragen letztlich ohnehin die Konsultation des Originals notwendig ist. Dass die Reproduktionen, mit denen wir arbeiten, lange Zeit auf analoger Fotografie basierten, heute aber auf digitalen Technologien, ist für die praktischen Fragestellungen der Kunstgeschichte letztlich auch weniger bedeutend. Auch die analoge Fotografie löst ihr Motiv durch die Körnung des Films in winzige Einzelteile auf, die die Materialität des Originals wenn überhaupt nur noch abbilden, nicht verkörpern.

Der durch Digitalisierung verursachte Informationsverlust ist in der Praxis meist zu vernachlässigen, übersteigt doch die mögliche Auflösung unser Wahrnehmungsvermögen um ein Vielfaches: Sollten Sie einmal ins österreichische Linz kommen, besuchen sie das sogenannte Deep Space des Ars Electronica Center und lassen Sie sich Leonardos Abendmahl auf der dortigen 16 x 9m großen Projektionsfläche anzeigen (Abbildung 2). Diese Reproduktion wurde aus über 1500 Abbildungen vom Haltadefinizione Lab zusammengestellt und hat eine Gesamtgröße von über 16 Milliarden Pixeln. Bei einer Größe des Originals von 4,60 x 8,80m sind das 20 Pixel pro Millimeter, in der Projektion immer noch 10. Zwar lässt sich diese Auflösung für Detailaufnahmen auch schon in der analogen Fotografie erzielen, aber eine 2:1 Gesamtreproduktion in dieser Größe – zoombar und scrollbar – ist mit analogen Mitteln unmöglich.

Solcherart hochaufgelöste Abbildungen faszinieren nicht nur – wie in Linz – ein breites Publikum, sondern sind beispielsweise für materialtechnische Untersuchungen von Einzelwerken äußerst wertvoll. Die vergleichende Analyse hingegen arbeitet interessanterweise oft gerade mit der Reduzierung der Bilddaten oder deren Verfremdung mittels Filtern. Entsprechende Projekte sind in der einschlägigen Literatur zur digitalen Kunstgeschichte gut dokumentiert,[8] ich möchte hier daher nur kurz einige prägnante Beispiele in Erinnerung rufen:

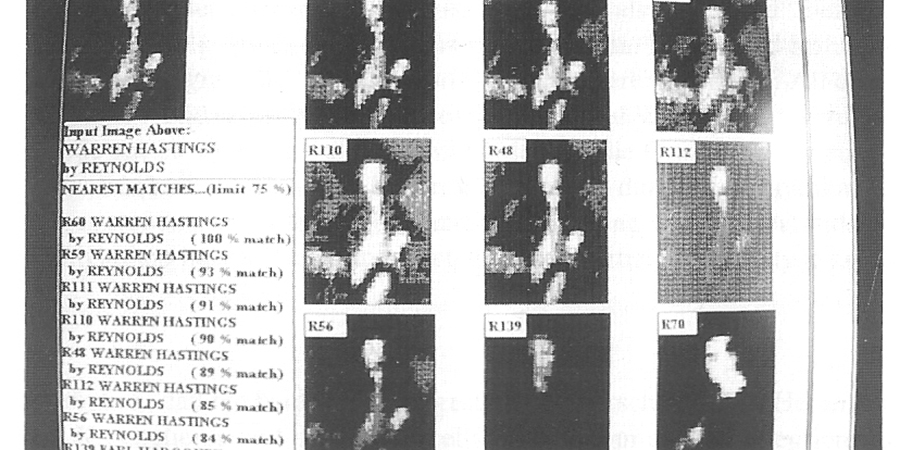

Ich hatte anfangs bereits William Vaughans These zitiert, dass sich formale Analysen besser automatisieren ließen als ikonographische. Vaughan hat es keineswegs bei dieser theoretischen Überlegung belassen, sondern als Vorreiter auf diesem Gebiet ein eigenes Forschungsprojekt durchgeführt: Das von ihm konzipierte, nach dem frühen italienischen Kunstkritiker Giovanni Morelli benannte Programm ermöglichte bereits Ende der 1980er Jahre die Suche nach formal bzw. kompositorisch ähnlichen Bildern mithilfe eines in seiner Datenmenge stark reduzierten ›Visual Identifiers‹ (Abbildung 3).[9]

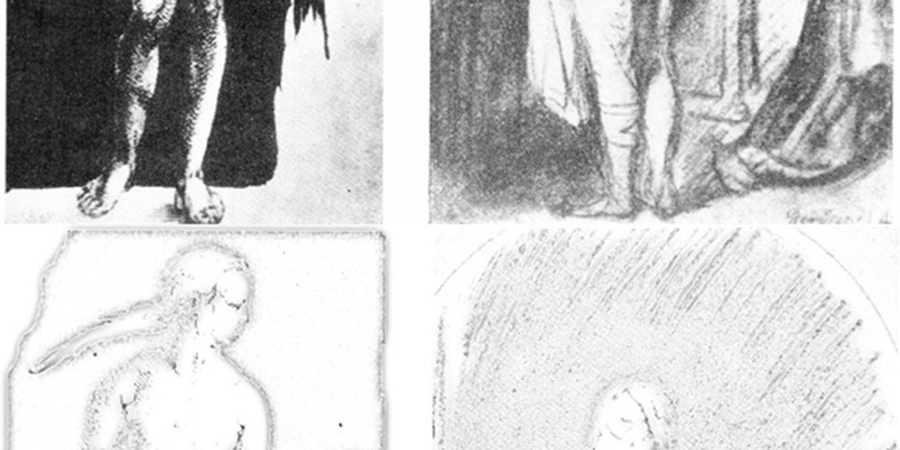

Hinsichtlich computergestützter Verfahren zur stilistischen Analyse war für viele von uns ein 2003 von Stefan Heidenreich durchgeführtes Experiment prägend: Er versuchte mittels recht einfacher Verfahren, nämlich durch Subtraktion eines weichgezeichneten Bildes vom (digitalisierten) Original, die von Heinrich Wölfflin 1915 vorgenommene Unterscheidung des linearen Stils der Renaissance vom malerischen Stil des Barock rechnerisch nachzubilden. Das verblüffend deutliche Ergebnis (Abbildung 4)[10] gab Grund zu der Erwartung, dass stilistische Analysen in Zukunft vermehrt mit digitalen Technologien unterstützt werden könnten.

Tatsächlich sind in den letzten zehn Jahren die Methoden, die zur automatisierten Bildanalyse verwendet werden, maßgeblich weiterentwickelt worden und können beileibe nicht mehr auf die einfache Formel von ›Stil und/oder Ikonographie‹ gebracht werden. Ein Beispiel für eine höchst komplexe, auf der Kombination ikonographischer und stilistische Fragestellungen beruhende Analyse ist das Heidelberger Forschungsprojekt zur Gestenerkennung in mittelalterlichen Handschriften. Ein anderes ist ein laufendes Projekt an der University of California, Riverside, das die mögliche Identifizierung von historischen Porträts mithilfe von Gesichtserkennungssoftware untersucht. Verständlicherweise betonen die dortigen Kollegen, ein solches Unterfangen sei ungleich schwieriger als die Identifizierung lebender Menschen mittels hierfür ausgerichteter Kameras, da in der Analyse künstlerischer Porträts zunächst vom Individualstil der Künstler abstrahiert werden müsse.[11]

4. Rezeptionsforschung

Es ist zu hoffen, dass die Künstler der von den kalifornischen Kollegen untersuchten Porträts nicht ähnlich kritisch mit der Frage nach einer möglichen Identifizierbarkeit umgingen, wie der amerikanische Künstler Adam Harvey in seinem CV Dazzle (2012) (Abbildung 5). In einem zwischen künstlerischer Forschung, Medienaktivismus und Konzeptkunst zu lokalisierendem Ansatz entwickelt er Makeup und Frisuren, die sich gerade dadurch auszeichnen, dass sie ihren Träger vor Identifikation durch automatisierte Gesichtserkennungssysteme schützen.

Keinesfalls geht es mir bei dieser Gegenüberstellung darum, den interessanten Forschungsansatz der amerikanischen Kollegen zu kritisieren – ich möchte etwas anderes deutlich machen: Kunst bedarf der Wahrnehmung, und Wahrnehmung ist ein extrem komplexer neurologischer und kognitiver Prozess. Künstler instrumentalisieren ihn, Kunstwissenschaftler analysieren ihn, und Informatiker suchen ihn zu simulieren. Wie die bisher erwähnten Projekte zeigen, bieten sich digitale Technologien offensichtlich zunächst zur Behandlung von traditionellen Themen der Kunstgeschichte an: Ikonographie, Stilgeschichte, Zuschreibungsfragen, Motiv-Identifikation. Wie können aber Fragen des Umgangs mit Bildern, ihrer Wahrnehmung und ihres Kontexts in den Digital Humanities einen Platz finden?

Raphael Rosenberg, Kunsthistoriker in Wien, hat ausgehend von seinem Interesse an literarischen Beschreibungen von Kunstrezeptionen begonnen, tatsächliche Prozesse der Kunstbetrachtung zu untersuchen. Gemeinsam mit Kollegen aus der Psychologie nutzt er Eye-Tracking-Technologien, um in einem ›Labor für empirische Bildbetrachtung‹ Blickbewegungen von Kunstrezipienten zu analysieren (Abbildung 6).[12]

An die Frage, wie etwas individuell wahrgenommen wird, schließt sich dann aber die Frage an, wie es individuell und kontextabhängig interpretiert wird. Möglicherweise gelangen wir hier an die Grenzen einer bildbasierten Analyse bzw. an den Punkt, wo gerade die Kombination bildbasierter und textbasierter Verfahren erfolgversprechend wird. Raphael Rosenberg stellt seine Ergebnisse historischen Bildbeschreibungen gegenüber. Hubertus Kohle lässt in seinem ARTigo-Spiel möglichst viele Internetnutzer Tags für Bilder vergeben, auch um durch deren Analyse Hinweise auf individuelle Interpretationen und Wahrnehmungsmuster zu erhalten.

Mein Eindruck ist, dass die Kunstgeschichte hier – in der Entwicklung von Methoden, die digitale Analyseverfahren und menschliche Interpretationsleistung intelligent kombinieren – noch relativ am Anfang steht, dass aber digitale Technologien dazu beitragen können, die traditionelle, auf den impliziten Betrachter gerichtete Rezeptionsästhetik stärker um eine empirisch gestützte Rezeptionsforschung zu ergänzen. Und ich möchte auch hier noch ein bisschen weiter gehen und noch einmal auf eine bereits zu Beginn gemachte Beobachtung zurückkommen, dass Kunst sich nicht auf das visuelle Artefakt beschränkt. – Was bedeutet also Rezeptionsforschung in diesem weiteren Sinne?

Kunstrezeption geschieht nicht nur durch Blickbewegungen, sondern auch durch Körperbewegungen. Während die Analyse von Bewegungen im Raum für die architekturwissenschaftliche Forschung, aber auch etwa im Rahmen von curatorial studies meines Wissens noch wenig genutzt wird, haben Künstler sich für die Möglichkeiten, die neue Technologien diesbezüglich bieten, schon früh interessiert. Gleich mit der kommerziellen Einführung von GPS-Geräten entstanden Projekte wie Amsterdam Realtime (2002–2003): Esther Polak hat in diesem Projekt mit Unterstützung der Waag-Society einen Stadtplan von Amsterdam erstellt, der nur auf der GPS-gestützten Aufzeichnung von realen Bewegungen von Bewohnern basiert. Auch hier interessiert uns dann aber natürlich, wie oben bereits erwähnt, nicht nur die Bewegung oder Aktion der Rezipienten selbst sondern auch deren Interpretation und Kontext. Zu diesem Zweck sind dann wiederum kombinierte Methoden notwendig.

An dieser Stelle möchte ich ein Projekt erwähnen, welches ich selbst im Rahmen meiner Forschungen zur interaktiven Medienkunst[13] durchgeführt habe, denn gerade die partizipative und interaktive Kunst stellt die individuelle Erfahrung des einzelnen Rezipienten ins Zentrum ihrer ästhetischen Strategien. – Wie kann man diese also untersuchen, ohne– wie sonst oft in der Kunstgeschichte üblich– nur von seiner eigenen Erfahrung als einer Art idealem Betrachter bzw. idealer Betrachterin auszugehen? Gemeinsam mit zwei Kolleginnen aus Kanada und Australien habe ich hierfür eine von ihnen als Video Cued Recall bezeichnete Methode angewandt.[14] Sobald die Rezeption sich nicht auf das reine Anschauen beschränkt, sondern Gesten, Bewegungen, oder sogar Sprache einschließt, lassen sich diese Aktionen per Video dokumentieren. Dies haben wir getan, um die entstandene Dokumentation anschließend den jeweiligen Rezipienten noch einmal vorzuspielen, und sie zu bitten, ihre eigene Aktion zu kommentieren. Dieser Kommentar wurde als eine Art Voice-Over mit der Dokumentation gespeichert. Auf diese Weise erstellte Dokumentationen verschiedener Werkrezeptionen ergeben zusammen mit Künstlerinterviews eine sehr interessante, multiperspektivische Dokumentation. Eine solche Dokumentation haben wir für eine Arbeit des amerikanischen Künstlerduos Tmema mit dem Titel Manual Input Workstation (2004–2006) erstellt. Sie ist über das Online-Archiv der Daniel Langlois Foundation zugänglich. In der Interaktion mit dieser Arbeit kann man mit einem handelsüblichen Tageslichtprojektor Schattenformationen erzeugen, die dann digital analysiert und mit animierten Formen und Sounds überlagert werden. Es geht bei dieser Arbeit weniger um das audiovisuelle Ergebnis selbst, als um die Erfahrung der Interaktion mit Formen und Tönen. Daher kann man sie letztlich nur dann angemessen analysieren, wenn man verschiedene Besucherinteraktionen beobachtet hat, idealerweise ergänzt durch Reaktionen oder Interpretationen verschiedener Besucher. Dies wird durch die oben genannte multiperspektivische Dokumentation möglich. Allerdings – und dies möchte ich ausdrücklich betonen – ist diese Form Dokumentation letztlich gar nicht auf avancierte digitale Technologie angewiesen. Während die Arbeit digital gesteuert wird, basiert die erwähnte Dokumentation nicht zwangsläufig auf digitalen Technologien sondern auf einer gewöhnlichen Videoaufnahme. Zwar machen digitale Technologien das Zusammenschneiden verschiedener Spuren um ein vielfaches einfacher, möglich war dies aber auch mit analogen Mitteln. Und damit kommen wir zurück zur Frage der Ideologiekritik: Primär muss es darum gehen, Analysemethoden zu finden, die dem Untersuchungsgegenstand und der Fragestellung am besten dienen. Das kann eine crowdbasierte Sammlung von Metadaten sein, eine graphische Wiedergabe von Bewegungsmustern, oder eben eine videogestützte Analyse.

Im letzten Teil meines Beitrags möchte ich jetzt wieder zum Bild zurückkommen, diesmal aber zum Bild als Medium der Forschung. Bezüglich des Nutzens von Visualisierungen für die Kunstgeschichte denkt man meist zunächst an die Architekturgeschichte, die digitale Modelle zur Rekonstruktion zerstörter Gebäude, zur Visualisierung von Bauphasen oder zur Untersuchung von Hypothesen bezüglich historischer Eingriffe verwendet. Dies ist ein sehr wichtiger und vielversprechender Aspekt der digitalen Kunstgeschichte, auf den ich hier aber nicht weiter eingehen möchte. Stattdessen sollen zwei andere Formen der Visualisierung angesprochen werden: die interpretierende Visualisierung am Bild und die Visualisierung sogenannter ›Big Data‹.

5. Visualisierung

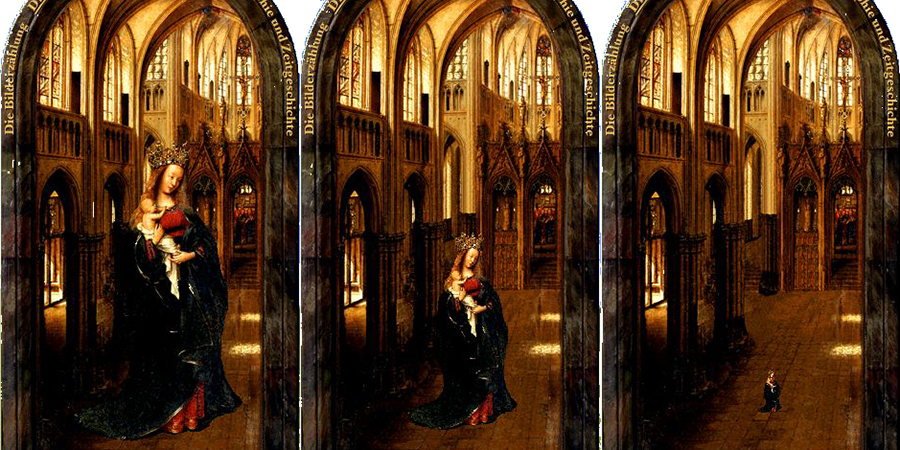

Die Berliner Museen haben in den 1990er Jahren eine Reihe von werkmonographischen CDs herausgebracht, die interaktive Bildanalysen ermöglichen. Eine davon widmet sich der Madonna in der Kirche (ca. 1440) (Abbildung 7)[15], dem berühmten >Gemälde Jan van Eycks, das die Madonna nicht nur in der Kirche, sondern vielmehr als Kirche darstellt. Die monumentale Größe der Figur im Verhältnis zu der sie beherbergenden Architektur wurde in wegweisenden Texten interpretiert, wie etwa hier durch Otto Pächt:

»Nur zu Jan paßt es, daß die Madonna wie eine riesige Statue in einem allerdings luftigen Schrein steht, denn für ihn ist räumliche Einpassung in erster Linie nicht eine Frage der Größenverhältnisse – alle Janschen Architekturszenerien sind zu niedrig –, sondern der meßbaren Beziehung von Körpervolumen und Raumschale. […] Von der abstrakten Idee der Personifikation der Kirche durch Maria hat sich die künstlerische Phantasie eines unentwegten Empirikers zu dem Bilde des realen Kirchengebäudes inspirieren lassen, das nun als Umwelt der Himmelskönigin beigesellt wird. So wird aus Maria als die Kirche Maria in der Kirche.«[16]

Gerade vor dem Hintergrund solcher interpretierender Beschreibungen ist die von den Berliner Museen angebotene Möglichkeit, die Größe der Madonna im Verhältnis zum Innenraum in einer digitalen Reproduktion zu manipulieren, interessant (Abbildung 8).[17] Es handelt sich hier um eine Form des ›vergleichenden Sehens‹, allerdings nicht im Sinne eines Vergleichs zweier Kunstwerke, sondern eines Vergleichs der Auswirkungen von am Bild vorgenommener Manipulationen, von imaginären Bildalternativen, die jedoch helfen, die im Original gewählte Lösung zu verstehen. Das Experimentieren mit dieser interaktiven Anwendung macht schnell deutlich, wie unterschiedlich Argumentations- und Erkenntnisprozesse in der textuellen Interpretation einerseits, der explorativen Manipulation andererseits verlaufen. Letztere kann erstere keineswegs ersetzen, sondern ist ihr komplementär.

Solche Formen der interaktiven Bildanalyse bleiben in der Kunstgeschichte dennoch bis heute die Ausnahme. Visualisierungen dienen in erster Linie nicht zur Analyse einzelner Kunstwerke sondern zur Darstellung der Ergebnisse von Analysen großer Datenmengen. Solche Analysen werden durch computergestützte Methoden extrem vereinfacht. Da ihre Ergebnisse jedoch oft nur schwer textuell vermittelbar sind, bietet es sich geradezu an, visuelle Darstellungen derselben anzubieten. Dies kann in Form von Zeitleisten geschehen, aber auch als Visualisierung von Netzwerkanalysen. In verschiedenen Projekten, die wir am Ludwig Boltzmann Institut Medien.Kunst.Forschung in Linz durchgeführt haben, ging es um die Erstellung von Themenlandschaften, die versuchen, thematische und konzeptuelle Zusammenhänge räumlich darzustellen, um die Visualisierung quantifizierbarer Entwicklungen, die etwa die Anzahl von Einreichungen von Werken in bestimmte Preiskategorien bei Wettbewerben darstellen und sogar um die Visualisierung der Verteilung von Begriffen im Text als einer Form der visuellen Diskursanalyse (Abbildung 9).[18]

All diesen Projekten gemein ist jedoch letztlich eine Visualisierung von als Text vorliegenden Daten, auch wenn diese visuelle Artefakte beschreiben oder auf deren Existenz basieren. Anders ist dies bei Projekten, die Lev Manovich, Kunsthistoriker an der City University of New York, durchführt. Seine Visualisierungen basieren auf Zusammenstellungen großer Mengen digitaler Reproduktionen. So analysiert er z. B. Reproduktionen von Gemälden van Goghs aus verschiedenen Schaffensperioden auf deren Helligkeit und Sättigung. Die vergleichende Anordnung in einem Koordinatensystem zeigt für die verschiedenen Schaffensorte und damit -perioden ein verblüffend ähnliches Muster und stellt damit die gängige Auffassung in Frage, van Goghs Stil habe je nach Aufenthaltsort stark variiert. Während das van Gogh-Beispiel die kritische Überprüfung einer These darstellt, interessiert Manovich bei diesen Forschungen letztlich die Frage, inwiefern solche Bildzusammenstellungen neue Erkenntnisse liefern, ohne dass man mit einer direkten Fragestellung an sie herangegangen wäre:

»However, for media researchers, starting with well-formulated questions does not exploit what visualization is best at: exploring without preconceptions a large dataset to discover ›what is there‹ and revealing unexpected patterns, as opposed to testing already formulated ideas. We can call such process exploratory visualization.«[19]

Die Tragweite der Frage, wie wir große Mengen von Bildern im Zusammenhang analysieren können, wird uns in Zukunft mit Sicherheit weiter beschäftigen –, und dies schlichtweg, weil die Menge der produzierten Bilder immer noch rasant ansteigt. Ich möchte daher mit einem weiteren medienkünstlerischen Projekt schließen, das nah an rezeptionsästhetischen Fragestellungen operiert. Die französische Künstlerin Corinne Vionnet hat immer wieder beobachtet, dass Touristen Bilder berühmter Sehenswürdigkeiten sehr häufig aus fast identischen Blickwinkeln aufnehmen. Um diese amateurfotographische Praxis weiter zu analysieren, hat sie in den sozialen Medien Fotos von Sehenswürdigkeiten gesucht und in ihrer Serie Photo Opportunities (2005–2013) (Abbildung 10) zu großen Bildern zusammengesetzt, die damit so etwas wie unser kollektives Bildgedächtnis visualisieren. Solche Projekte lassen sich durchaus als eine Form der künstlerischen Bildwissenschaft bezeichnen, und können der geisteswissenschaftlichen Forschung, gerade im Bereich der Digital Humanities, interessante Impulse geben.

6. Vom Bild zum Bild

Wenn ich meinem Beitrag den Titel ›Vom Bild zum Bild‹ gegeben habe, so ging es mir darum zu betonen, dass wir es in den digitalen Geisteswissenschaften mit sehr unterschiedlichen Formen von digitalen und digitalisierten Bildern zu tun haben, die durch verschiedenste digitale Methoden – und damit immer über den Umweg des Codes – in neue Bilder übersetzt werden, sei es durch die digitale Reproduktion eines Originalgemäldes, die interaktive Animation einer digitalen Reproduktion, die Visualisierung der Wahrnehmung eines Kunstwerks, die Visualisierung quantitativer Daten zum Kunstmarkt oder die Visualisierung von Bildsammlungen anhand von Bildberechnungen. Die Digital Humanities analysieren nicht nur Bilder, sondern produzieren auch neue Bilder – auch insofern betreffen die ›Digital Humanities jenseits des Texts‹ nicht nur die Kunstgeschichte sondern in gleichem Maße die Disziplinen, die sich mit der Analyse schriftlicher Überlieferung befassen, und diese durch Visualisierungen präsentieren.

Wenn ich also meinen Beitrag mit dem Disclaimer begonnen habe, dass eine digitale Kunstgeschichte selbstverständlich großen Nutzen an textbasierten Methoden der Digital Humanities hat, so möchte ich mit der Bemerkung schließen, dass andererseits das Bild ein nicht zu unterschätzender Akteur der digitalen Geisteswissenschaften im Allgemeinen ist: auch Historiker und Literaturwissenschaftler haben schon immer Bilder als Quellen herangezogen, und sie benutzen auch in zunehmendem Maße Bilder, um die Analyseergebnisse großer Datenmengen zu visualisieren und lesbar zu machen.

Fußnoten

-

[1]Da dieser Beitrag als einführende Keynote im Rahmen der DHd-Tagung in Passau konzipiert war, wird für die schriftliche Version der mündliche Charakter des Vortrags weitestgehend beibehalten.

-

[2]Vgl. Bove et al. 2001.

-

[3]Vgl. Laupichler 1998, passim.

-

[4]Nagel 1997, S. 95.

-

[5]Vaughan 1997, S. 98.

-

[6]Vaughan 1997, S. 98.

-

[7]

-

[8]

-

[9]Vaughan 1997, passim.

-

[10]

-

[11]

-

[12]Betz et al. 2009, passim.

-

[13]Kwastek 2013, passim.

-

[14]

-

[15]Abbildung zu finden in der Bildergalerie der Berliner Gemäldegalerie.

-

[16]Pächt 1993, S. 205.

-

[17]Ein kurzer Film, der diese CD vorstellt, ist online abrufbar.

-

[18]Vgl. Yavuz 2009 [online].

-

[19]Manovich 2013, S. 257–258.

Bibliographische Angaben

- Kat. Ausst. Nana Petzet: System SBF. Inventarisierung der Sammlung. Metainventur. Hg. vom Cuxhavener Kunstverein; Kunstverein und Stiftung Springhornhof. Neuenkirchen, Nürnberg 2003. [Nachweis im GBV]

- Juliane Betz / Martina Engelbrecht / Christoph Klein / Raphael Rosenberg: Dem Auge auf der Spur: Eine historische und empirische Studie zur Blickbewegung beim Betrachten von Gemälden. In: Image. Zeitschrift für interdisziplinäre Bildwissenschaft 11 (2009), S. 29–41. [Nachweis im GBV]

- Jens Bove / Lutz Heusinger / Angela Kailus: Marburger Informations-, Dokumentations- und Administrationssystem (MIDAS). Handbuch und CD. München 2001. [Nachweis im GBV]

- Stefan Heidenreich: Form und Filter – Algorithmen der Bilderverarbeitung und Stilanalyse. In: zeitenblicke 2 (2003), Nr. 1. [online]

- Hubertus Kohle / Katja Kwastek: Computer, Kunst und Kunstgeschichte. Köln 2003. [Nachweis im GBV]

- Hubertus Kohle: Digitale Bildwissenschaft. Glückstadt 2013. [Nachweis im OPAC]

- Kunstgeschichte digital. Eine Einführung für Praktiker und Studierende. Hg. von Hubertus Kohle. Berlin 1997. [Nachweis im GBV]

- Katja Kwastek: Aesthetics of Interaction in Digital Art. Cambridge, MA 2013. [Nachweis im GBV]

- Fritz Laupichler: MIDAS, HIDA, DISKUS – was ist das? In: Arbeitsgemeinschaft der Kunst- und Museumsbibliotheken-News 4 (1998), Nr. 2/3, S. 18–24. [online]

- Lev Manovich: Museum Without Walls, Art History without Names: Visualization Methods for Humanities and Media Studies. In: Oxford Handbook of Sound and Image in Digital Media. Hg. von Carol Vernallis / Amy Herzog / John Richardson. Oxford 2013, S. 253–278. [Nachweis im GBV]

- Bettye Miller: Research on Application of Face-recognition Software to Portrait Art Shows Promise. In: UCR Today, 31. Mai 2013. [online]

- Lizzie Muller: Towards an Oral History of Media Art. In: Publications by the Daniel Langlois Foundation. 2008. [online]

- Tobias Nagel: Zur Notwendigkeit einer Ideologiekritik der EDV im Museum. In: Kunstgeschichte digital. Eine Einführung für Praktiker und Studierende. Hg. von Hubertus Kohle. Berlin 1997, S. 84–96. [Nachweis im GBV]

- Otto Pächt: Van Eyck. Die Begründer der altniederländischen Malerei. 1. Auflage 1989. München 1993. [Nachweis im GBV]

- William Vaughan: Computergestützte Bildrecherche und Bildanalyse. In: Kunstgeschichte digital. Eine Einführung für Praktiker und Studierende. Hg. von Hubertus Kohle. Berlin 1997, S. 97–106. [Nachweis im GBV]

- Mahir Yavuz: Mapping The Archive: 30 Years of Ars Electronica Visualized in Huge Scale. Information Aesthetics Weblog. 16.09.2009. [online]

Abbildungslegenden und -nachweise

- Abb. 1: © Cuxhavener Kunstverein, Nana Petzet: System SBF. Inventarisation der Sammlung. Metainventur, 2003, Nana Petzet.

- Abb. 2: Deep Space. © Archiv Ars Electronica Linz GmbH, Fotograf Rudolf Brandstätter.

- Abb. 3: »Screenshot mit Abfrageresultat aus ›Morelli‹: Die Suche wurde ausgehend von einem Portrait Warren Hastings von Joshua Reynolds durchgeführt. Das System identifiziert andere Bilder und Reproduktionen, die mit dem Reynolds-Porträt in Beziehung stehen«. Quelle: William Vaughan: Computergeschütze Bildrecherche und Bildanalyse. In: Kunstgeschichte digital. Eine Einführung für Praktiker und Studierende. Hg. von Hubertus Kohle. Berlin 1997.

- Abb. 4: Gegenüberstellung von zwei Frauenakten. Aus: Heinrich Wölfflin: Kunstgeschichtliche Grundbegriffe. München 1915, S. 36/37 (oben); Subtraktion einer weichgezeichneten Version der obigen Abbildungen von eben diesen Abbildungen. In: Stefan Heidenreich: Form und Filter - Algorithmen der Bilderverarbeitung und Stilanalyse. Zeitenblicke 2 (2003), Nr. 1 (unten). Quelle: © Zeitenblicke, 2003.

- Abb. 5: CV Dazzle. © Adam R. Harvey, 2010.

- Abb. 6: Visualisierung einer Blickanalyse. Quelle: Zwischen Kunst und Alltag (Interview mit Helmut Leder und Raphael Rosenberg). © Labor für empirische Bildwissenschaft, Universität Wien, 2012.

- Abb. 7: Jan van Eyck: Die Madonna in der Kirche, Ident. Nr. 525C. © Foto: Gemäldegalerie, Staatliche Museen zu Berlin, Fotograf/in: GG-Fotowerkstatt. CC BY-NC-SA 3.0.

- Abb. 8: Eyck. CD: Manipulierte Reproduktion Die Madonna in der Kirche © Gemäldegalerie, Staatliche Museen zu Berlin auf der Grundlage von Abb. 7. CC BY-NC-SA 3.0.

- Abb. 9: Evelin Münster: »A Theme Landscape for Tagged Data«, Ludwig Boltzmann Institut Medien.Kunst.Forschung 2009 (oben); Jaume Nualart: »Texty«, Ludwig Boltzmann Institut Medien.Kunst.Forschung 2009 (Mitte); Moritz Stefaner: »X by Y«, 2009 [online] (unten).

- Abb. 10: © Corinne Vionnet: athína, 2006, series Photo Opportunities.

![Abb. 9: Evelin Münster: »A Theme

Landscape for Tagged Data«, Ludwig Boltzmann Institut Medien.Kunst.Forschung 2009 (oben); Jaume

Nualart: »Texty«, Ludwig Boltzmann Institut Medien.Kunst.Forschung 2009 (Mitte); Moritz Stefaner: »X

by Y«, 2009 [online] (unten).](http://www.zfdg.de/sites/default/files/styles/medium_in_artikel/bild_2015_009.jpg)