DOI: 10.17175/sb002_006

Nachweis im OPAC der Herzog August Bibliothek: 89843615X

Erstveröffentlichung: 15.03.2018

Medienlizenzen: Medienrechte liegen bei den Autoren

Letzte Überprüfung aller Verweise: 07.03.2018

GND-Verschlagwortung: Rezension | Edition | Informationsvermittlung |

Empfohlene Zitierweise: Ulrike Henny: Reviewing von digitalen Editionen im Kontext der Evaluation digitaler Forschungsergebnisse. In: Digitale Metamorphose: Digital Humanities und Editionswissenschaft. Hg. von Roland S. Kamzelak / Timo Steyer. 2018 (= Sonderband der Zeitschrift für digitale Geisteswissenschaften, 2). text/html Format. DOI: 10.17175/sb002_006

Abstract

Erste Empfehlungen für die Einordnung und Bewertung digitaler Editionen sind bereits im Zuge der Etablierung des WWW als primärem Publikationsmedium für digitale Inhalte in den späten 90er-Jahren veröffentlicht worden. Trotzdem und auch aufgrund von methodischen und technischen Weiterentwicklungen stehen selbst grundlegende Fragen zur Evaluation von digitalen Editionen noch immer zur Diskussion. Dieser Beitrag setzt sich insbesondere mit dem Reviewing als einer möglichen Form der Beurteilung von wissenschaftlichen digitalen Editionen auseinander, tut dies aber vor dem Hintergrund der den Rezensionen zugrundeliegenden Bewertungskriterien und dem weiteren Kontext der Evaluation digitaler Forschungsergebnisse insgesamt. Auf diese Weise werden wesentliche Bereiche für die Bewertung digitaler Editionen herausgearbeitet: die angemessene Repräsentation des edierten Gegenstandes in digitalen Daten zum Beispiel durch Textcodierung, ein innovativer Umgang mit dem digitalen Medium, eine sinnvolle Abstimmung von Inhalt und Form in der Präsentation des edierten Materials, etc. Trotz der allfälligen Veränderungen in der Wissenschaftskommunikation bleibt die Rezension als ›Evaluationstextsorte mit Tradition‹ ein geeignetes Mittel zur Diskussion der Qualität von digitalen Editionen.

The first recommendations for the classification and evaluation of digital editions were already published in the process of establishing the WWW as the primary medium of publication for digital content in the late 1990s. However, owing in part to methodological and technical developments, basic questions about the evaluation of digital editions are still being discussed. This article explores the review process as a means of evaluating scholarly digital editions, building on the background of the evaluation criteria that provide the basis for reviewing and the broader context of evaluating digital research results as a whole. In this way, many aspects can be worked out for the evaluation of digital editions: the appropriate representation of the edited object in digital data, for example, through text encoding; the innovative interaction with the digital medium; a meaningful consensus between content and form in the presentation of the edited material, etc. Despite the future changes in scholarly communication, the review as an ›evaluative genre with tradition‹ remains an ideal tool for discussing the quality of digital editions.

» Evaluation – Das Unwichtige läßt sich am genauesten

messen. Aber wie stellt man fest, was wichtig ist? – Es ist das, was

übrigbleibt, wenn alles gemessen wurde.«

Rainer Kohlmayer in

Die Schnake

15/16 (2000).

Das Rezensieren wissenschaftlicher Veröffentlichungen und die Publikation von Rezensionen in wissenschaftlichen Zeitschriften haben eine lange Tradition. Das gilt jedoch nicht in gleicher Weise für Rezensionen zu digitalen Forschungsergebnissen. Die Bewertung digitaler Arbeiten wirft allgemein viele Fragen auf: Wann hat ein digitales Produkt einen Bearbeitungsstand erreicht, der evaluiert werden kann? Haben Bewertungen digitaler Projekte und Ressourcen andere Funktionen und Ziele als bei gedruckten Publikationen? Wer sollte und kann eine Evaluation durchführen? Welche Aspekte und Bestandteile digitaler Forschung sind sinnvollerweise zu evaluieren?

Da die Evaluation digitaler Ressourcen insgesamt noch nicht ausgereift ist, werden im ersten Teil dieses Beitrags allgemeine Problemfelder aufgezeigt und diskutiert. Bestehende Ansätze werden in den Blick genommen. Der Beitrag geht im zweiten Teil auf digitale Editionen ein und untersucht, inwiefern ein Bedarf an Evaluation besteht und welche Aspekte für diese Art von digitaler Ressource im Hinblick auf die Bewertung spezifisch sind. Anhand zweier Beispiele werden im dritten Teil Bewertungskriterien von digitalen Editionen daraufhin untersucht, inwieweit sie auf der einen Seite auf digitale Forschungsergebnisse im Allgemeinen anwendbar sind und auf der anderen Seite auf wissenschaftliche Editionen, unabhängig von deren medialer Realisierung. So kristallisieren sich Kriterien heraus, die sich nicht in einen digitalen und einen Editionsbestandteil auflösen lassen und Hinweise darauf geben, wo das ›Zentrum‹ der Bewertung digitaler wissenschaftlicher Editionen liegt. Im vierten Teil wird auf Rezensionen als Bewertungsform für digitale Editionen eingegangen und diskutiert, inwieweit Reviews eine für digitale wissenschaftliche Editionen geeignete Evaluationsform sind.[1]

1. Evaluation von digitalen Forschungsergebnissen

Es ist darauf hingewiesen worden, dass digitale Forschungsergebnisse bei der Einschätzung wissenschaftlicher Leistungen noch nicht in gleichem Maße berücksichtigt werden wie traditionelle, gedruckte Publikationen.[2] Dafür gibt es verschiedene Gründe: Die Ergebnisse digitaler geisteswissenschaftlicher Forschung münden nicht immer in einen Text, mit dem sie vollständig und ausschließlich dargelegt werden. Sie können ganz unterschiedliche Formen annehmen, z. B. ein durchdachtes digitales Datenmodell, ein gut aufbereitetes und dokumentiertes digitales Korpus, parametrierte Skripte und programmierte Werkzeuge, die auf Theorien aufbauen, Forschungsmethoden implementieren, Forschungsprozesse digital unterstützen und somit auch selbst Ergebnisse sind, sowie Anwendungen und Präsentationen von wissenschaftlichen Inhalten im Web.

Obwohl Publikationen in Online-Zeitschriften und ausschließlich digital publizierte Monographien und Sammelbände wegen der Nähe zu gedruckten Publikationen noch den einfachsten Fall darstellen – es sind Forschungsergebnisse, die in linearer Textform dargestellt und fixiert werden – gibt es wie bei allen digitalen Forschungsergebnissen Zweifel und Unsicherheiten hinsichtlich der Qualität, der Verlässlichkeit und dauerhaften Verfügbarkeit. Die Erstellungs-, Bewertungs- und Publikationsprozesse für wissenschaftliche Veröffentlichungen und ihre Sicherung sind im Digitalen noch nicht so etabliert und erscheinen dadurch unsicher. Das Magazin für digitale Editionswissenschaften beispielsweise versteht sich als »offenes Forum zur Vorstellung von ›best practises‹ für Online-Editionen«.[3] Einreichungen werden von einem Redaktionsteam geprüft und die Artikel dann »sofort eingestellt«. Die Aussagen auf der Webseite des Magazins vermitteln den Eindruck von größerer Offenheit hinsichtlich des Inhalts und der Form der Beiträge und den Veröffentlichungsprozess betreffend. Bei Druckpublikationen wird dagegen zumeist von einem dahinter stehenden Wissenschaftsverlag ausgegangen, bei dem eine inhaltliche Begutachtung, ein Lektorat, die Vergabe einer ISBN oder ISSN und eine professionelle Distribution als prinzipiell gesichert angenommen werden. Auch die potentielle Unabgeschlossenheit digitaler Ergebnisse spielt bei der Skepsis gegenüber digitalen Veröffentlichungen eine Rolle: sie können leicht verändert, überarbeitet oder erweitert werden. Dazu kommt noch, dass digitale Forschungsergebnisse aufgrund ihrer möglichen Vielschichtigkeit, Komplexität und des großen Umfangs oft durch die Zusammenarbeit mehrerer Personen entstehen, die auf einzelne Bereiche spezialisiert sind. Das erschwert ihre Bewertung, wenn es um die Feststellung der Leistung Einzelner geht.

Wer sollte evaluieren?

Die Evaluation von

Forschungsergebnissen, die digital publiziert werden, stellt spezifische

Anforderungen an die bewertende Person: Es braucht Erfahrung im Umgang mit

den vielfältigen Formen, die solche Ergebnisse annehmen können, also eine

methodische Kompetenz, die über die fachlich-inhaltliche Expertise

hinausgeht und die noch nicht selbstverständlich geworden ist. Die

Schwierigkeiten und Herausforderungen, die sich durch das digitale Medium

für die Praxis des Evaluierens ergeben, werfen nicht nur Fragen zu den

Produkten digitaler Wissenschaft auf, sondern auch zum Evaluieren selbst:

Wer soll bewerten? Was soll bewertet werden? Wann wird bewertet? In welcher

Form kann Evaluation stattfinden? Welche Zwecke erfüllt Evaluation? Dass

diese Fragen vermehrt aufkommen, zeigt, dass sie neu beantwortet werden

müssen, unabhängig davon, ob sich aus der Diskussion um die Evaluation

digitaler Forschungsergebnisse im Verhältnis zur Bewertung von in gedruckter

Form veröffentlichten Erkenntnissen jeweils neue und andere Antworten

ergeben werden oder nicht.[4]

Zunächst stellt sich die Frage, ob Einzelne überhaupt alle diese Fähigkeiten in sich vereinen müssen. Pfannenschmidt und Clement merken hierzu an: »Another concern in evaluation is the degree of expertise the reviewers should have in both the technology and the subject area that covers the material under consideration. The eclectic nature of digital scholarship poses challenges to the traditional method of finding one or two experts to take on review. The difficulty is partially due to the issue of determining what aspect is evaluated and why. […] Yet no one person can be an expert in every method, field, and medium: seemingly, collaborative work requires collaborative review.«[5] Eine Möglichkeit, mit den vielfältigen Anforderungen an Gutachter umzugehen, wäre also eine Arbeitsteilung: Nachdem die zu bewertenden Bereiche des digitalen Produkts ausgemacht sind, werden sie auf verschiedene Experten verteilt. Wenn auch Textcodierung, Programmierung, Konzeption und Design bewertet werden, kann es dazu führen, dass der Kreis der Gutachter sich von etablierten Wissenschaftlern in den jeweiligen Fachbereichen auf andere Akteure aus den digitalen Geisteswissenschaften ausweitet, was die Zusammensetzung von Teams spiegeln würde, welche digitale Projekte umsetzen und Ressourcen erarbeiten. Nachteilig daran könnte sein, dass der aus dem Medienwechsel folgende methodische Wandel sich nicht ganzheitlich vollzieht, wenn die Zusammenarbeit und der Austausch nicht eng genug sind. Weitere Möglichkeiten sind, ein Peer-Review für die Evaluationen selbst einzuführen, falls diese veröffentlicht werden sollen, womit die Qualität der Bewertungen gesichert würde und eventuelle Unsicherheiten in inhaltlichen oder technischen Bereichen durch die Rückmeldung von Fachkollegen ausgeglichen werden könnten. Schließlich wird bereits an dieser Stelle die Bedeutung von Handreichungen und Kriterien zur Bewertung deutlich, die Gutachtern dabei helfen können, alle Aspekte im Blick zu haben, welche für die Evaluation digitaler Forschungsergebnisse wichtig sind.

Was soll bewertet werden?

Für einen in einer

Online-Zeitschrift veröffentlichten wissenschaftlichen Artikel wird diese

Frage wesentlich leichter zu beantworten sein als z. B. für eine digitale

Edition, wobei sogar im ersten Fall erwogen werden kann, auch

Forschungsdaten zu begutachten, die möglicherweise hinter den in dem Artikel

formulierten Ergebnissen stehen. Im Fall der Edition ist zu fragen, ob nur

das an der Oberfläche sichtbare Ergebnis bewertet werden sollte, also

derzeit in den meisten Fällen eine Web-Anwendung, oder auch die dahinter

liegende digitale Form der Inhalte, welche die Anwendung füllen – digitale

Faksimiles, codierte Texte, daraus abgeleitete, ergänzende, mit weiteren

Daten angereicherte Materialien und Metadaten. In Frage kommen außerdem

Programmteile, welche die Anwendung steuern, durch die letztlich die Auswahl

der anzuzeigenden Inhalte erfolgt und durch die Funktionalitäten definiert

oder zumindest implementiert werden, sowie schließlich noch technische

Grundlagen und organisatorische Rahmenbedingungen. Da sich der

Forschungsbeitrag einer digitalen Ressource nicht auf die Form ihrer

medialen Präsentation beschränkt, sollten möglichst viele der genannten

Aspekte in eine Begutachtung einbezogen werden. In Abgrenzung zum Druck geht

es gerade darum, die ausschließliche Konzentration auf die Präsentation der

Ergebnisse zu überwinden, um die einfließenden Forschungsleistungen in

angemessener Weise zu berücksichtigen. Verschiedene Ergebnisebenen

einzubeziehen wird dem kooperativen und interdisziplinären Charakter vieler

digitaler Vorhaben gerecht. Es trägt zu der Diskussion bei, was als

Forschungsergebnis gelten kann und vermag vielleicht manche Form der

Zuarbeit, die jedoch Teil des Wesens digitaler Forschungsarbeit ist, aus den

Tiefen großer Projekte zu heben.

Wichtig erscheint auch eine Bestimmung dessen, was als Ergebnis gelten kann und beurteilungsfähig ist. So fragen Pfannenschmidt und Clement: »How should evaluators assess digital tools used in the production of scholarship«[6]? Sollten also nicht nur Ergebnisse bewertet werden, sondern auch Arbeitsweisen, die zu digitalen Forschungsergebnissen führen? Rockwell ist der Meinung, dass man hier trennen kann. Er definiert Forschung als die Aktivität, die zu Wissenschaft führt, und Wissenschaft als das Ergebnis, das man teilen (und beurteilen) könne. Man könne sich bei der Evaluation auf Wissenschaft konzentrieren und digitale Ergebnisse bewerten, aber nicht digitale Praktiken.[7] Dabei würde die Nutzung digitaler Ressourcen und Methoden unberücksichtigt bleiben, wenn sie ausschließlich zu gedruckten Ergebnissen führt. Auf der anderen Seite würden Arbeiten berücksichtigt werden, die allein analog vorbereitet wurden, aber zu digitalen Ergebnissen führen. Rockwell zufolge ist entscheidend, dass die Arbeit in elektronischer Form mit der Community geteilt wird und dass sie in elektronischer Form wahrgenommen werden soll.[8]

Der Ansatz, Ergebnisse zu beurteilen und nicht Praktiken, erscheint sinnvoll. Was als Ergebnis wahrgenommen werden soll, kann flexibel gestaltet werden: Wird etwas publiziert, kann es als Ergebnis ge- und bewertet werden, ob nun ein Text, ein Skript oder ein Forschungsdatensatz oder eine Methode, die beschrieben wird. Dadurch, dass etwas zugänglich gemacht und veröffentlicht wird, wird ein Signal gegeben. Dieses kann auch erfolgen, wenn etwas noch nicht einen als final betrachteten Status erreicht hat, sondern vielleicht ein Etappenziel, bis hin zur kontinuierlichen Offenlegung von Zwischenergebnissen. Das gilt zwar unabhängig vom Präsentationsmedium grundsätzlich für jegliches wissenschaftliches Arbeiten, jedoch erleichtert das digitale Medium die Veröffentlichung verschiedener Arbeitsstände z. B. als Versionen und ebenso die Veröffentlichung auch umfangreicher Daten, ohne dass diese in eine Form gebracht werden müssen, die für eine Publikation in Buchform geeignet ist. In jedem Fall kann Offenheit gefordert und gefördert werden, wenn einerseits nicht nur eine Darlegung in Textform, sondern auch Datensätze und Programmteile als Ergebnisse gewertet werden und andererseits die Publikation digitaler Forschungsergebnisse als Voraussetzung für deren Beurteilung betrachtet wird. Wenn z. B. die TEI-Codierung edierter Texte als Teil einer digitalen Edition bewertet werden soll, kann, sofern es keine rechtlichen Einschränkungen gibt, auch die Veröffentlichung der zugrundeliegenden TEI-Dateien eingefordert werden.

Wann soll bewertet werden?

Ob der

Ergebnischarakter digitaler Forschungsprodukte als Bedingung für eine

Bewertung angesetzt werden kann, ist aber auch vom Zeitpunkt einer

Evaluation und ihrem Zweck abhängig. Im Sinne einer klassischen Rezension

würde eine Evaluation erst erfolgen, wenn die Arbeiten abgeschlossen sind;

das Ergebnis wird in Augenschein genommen, eingeordnet und bewertet. Neben

der Einbindung eines Forschungsergebnisses in den wissenschaftlichen Diskurs

und eine Positionierung der oder des Rezensierenden zu dem Rezensat ist der

Zweck eine nachträgliche und zugleich in die Zukunft gerichtete

Qualitätssicherung, wenn Leser auf die Güte des besprochenen Gegenstandes

schließen und zukünftige Unternehmungen aus der Rezension Lehren ziehen

können. Eine Begutachtung kann aber auch zu Beginn erfolgen, wenn ein Antrag

vorliegt, aber noch keine Ergebnisse, oder ›mittendrin‹, wenn eine

Zwischenevaluation das bisher Erreichte bewerten soll und zu Korrekturen und

Kursänderungen führen kann. Beratungen, bei denen die Initiative von den

Erstellern einer digitalen Ressource bzw. von den Mitarbeitern eines

digitalen Projektes ausgeht, welche Externe um eine Beurteilung und

Ratschläge bitten, sind vorstellbar und in jeder Phase und zu jedem

Zeitpunkt denkbar. Sie haben den Zweck, die Qualität der

Forschungsergebnisse noch vor deren Fertigstellung zu sichern. Ein

Peer-Review schließlich würde kurz vor dem Abschluss erfolgen und soll

insbesondere im Hinblick auf die Veröffentlichung eine letzte Hilfestellung

und Qualitätssicherung bieten. Evaluationen gehen auch von digitalen

Vorhaben selbst aus, wenn Entscheidungen darüber getroffen werden müssen,

welche Datenmodelle, Standards und Werkzeuge für die Bearbeitung der eigenen

Materialien und Ziele am besten geeignet sind. Dahinter können dann

theoretische, methodische und praktische Erwägungen stehen und es geht

weniger darum, die wissenschaftliche Leistung von Personen, Gruppen oder

Institutionen festzustellen.

Zu der Frage, in welchen Phasen eine Evaluation für digitale Projekte besonders wichtig ist, gibt es verschiedene Ansichten: Pfannenschmidt und Clement stellen fest, dass Bewertungen, die zu einem frühen Zeitpunkt erfolgen und den Planungs- und Entwicklungsprozess noch beeinflussen können, zu Kosteneffizienz beitragen und helfen können, typische Fehler zu vermeiden.[9] Pierazzo dagegen meint, dass eine Vorab-Bewertung in Form von Antragsbegutachtungen für digitale Projekte bereits üblich sei, Evaluationen in späteren Phasen und nach Veröffentlichung aber noch kaum etabliert seien, während es sich mit dem Peer-Review und Rezensionen zu gedruckten Publikationen genau umgekehrt verhalte.[10] In beiden Fällen wird die Bedeutung von Evaluationen für digitale Projekte hervorgehoben und erkannt, dass die Praxis des Evaluierens in diesem Bereich noch am Anfang steht. Da digitale Projekte in den meisten Fällen vor Aufnahme der Arbeiten begutachtet werden, erscheint eine vermehrte Diskussion von veröffentlichen digitalen Forschungsergebnissen dringlicher.

In welcher Form soll Evaluation erfolgen?

Einige

Formen, welche die Evaluation von digitaler Forschung und deren Ergebnissen

annehmen kann, wurden bereits genannt: Gutachten zu Projektanträgen und

laufenden Projekten, Beratung, Peer-Review und Rezensionen. Wie diese

Evaluationsformen genau ausgestaltet werden, ist damit aber noch nicht

gesagt und es ist anzunehmen, dass sie selbst aus zwei Gründen einer

Transformation unterliegen: sie behandeln Gegenstände, die eine neue mediale

Gestalt annehmen oder in ihrem Wesen gänzlich neuartig sind und werden

selbst in den meisten Fällen in digitaler Form stattfinden.[11] Als ein

Beispiel ist das Open Peer-Review zu nennen, bei dem Beiträge vor ihrer

›finalen‹ Publikation in bestehenden Online-Foren, sozialen Medien oder

eigens dafür eingerichteten Web-Plattformen öffentlich diskutiert werden.

Hierzu sind einige Experimente zu finden, z. B. vom Arbeitskreis Digitaler

Wandel und Geschichtsdidaktik, bei dem Beiträge zur Tagung »Wikipedia

in der Praxis« auf dem Blog des Arbeitskreises kommentiert werden

können. Die Autoren werden zu einer abschließenden Entgegnung aufgefordert

und am Ende sollen die Kommentare zusammen mit den Beiträgen publiziert

werden.[12] Beim Open Editing können Beiträge direkt

von ›peers‹ bearbeitet werden. Vor allem Fitzpatrick geht auf bereits

existierende, neue Ansätze der Bewertung digitaler Forschungsarbeit ein, die

es zu erkennen und zu nutzen gelte, auch wenn sie auf den ersten Blick nicht

leicht sichtbar und als Qualitätsmerkmale erkennbar seien, wie Kommentare

oder Links zu anderen Webseiten.[13] Auch die Verbreitung von Informationen

und die Diskussion von digitalen Forschungsergebnissen in sozialen Medien

kann als eine Form von Evaluation angesehen werden. Yates schließlich

schlägt vor, einen Preis für die beste digitale Edition bzw. das beste

digitale Online-Archiv zu vergeben, um den notwendigen Wandel vom Druck hin

zum Digitalen zu fördern und zu besonders innovativen Vorgehensweisen zu

ermuntern und diese zu würdigen.[14] Es sollte eine Offenheit gegenüber neuen

Evaluationsverfahren und entsprechende Experimente geben. Trotzdem erscheint

es zunächst sinnvoller, auf etablierte Formen zurückzugreifen, damit der

Bewertungsprozess digitaler Forschungsergebnisse überhaupt in Gang gebracht

wird. Auch im Hinblick auf die Verbesserung der Reputation digitaler

Forschungsarbeiten sind anfangs solche Verfahren in den Vordergrund zu

stellen, die möglichst vielen Bewertenden und Bewerteten bekannt sind. Neue

Ansätze können in der Folge weiter reifen.

Welche Ansätze für Evaluation gibt es bereits?

Zu den Initiativen zur Förderung der Evaluation digitaler Forschung zählen

die Entwicklung von Richtlinien und Best Practices und die Einrichtung von

Plattformen, die zur Erstellung und Veröffentlichung von Bewertungen genutzt

werden können. Die Aktivitäten beziehen sich auf digitale Forschungsprojekte

und -ressourcen im Allgemeinen oder, spezieller, auf bestimmte Fachbereiche

oder bestimmte Gegenstände wie digitale wissenschaftliche Editionen oder

Archive. Im Folgenden werden verschiedene Ansätze genannt:

Richtlinien zur Bewertung digitaler Forschungsarbeiten im Allgemeinen:

- Die von der Modern Language Association (MLA) herausgegebenen »Guidelines for Evaluating Work in Digital Humanities and Digital Media«[15].

- Der »Short Guide To Evaluation Of Digital Work« von Geoffrey Rockwell, der sowohl mögliche Fragen für Gutachter formuliert, die digitale Arbeiten bewerten sollen, als auch Best Practices in Form einer Checkliste sowie Tipps, wie man Experten zur Unterstützung finden kann.[16]

- Die Guidelines »How to Evaluate Digital Scholarship« von Todd Presner, welche als Grundlage für die Evaluation von Wissenschaft in »the Humanities, Social Sciences, Arts, and related disciplines«[17] dienen sollen.

Allgemeine Rezensionszeitschriften und Fragebögen mit eigenen Richtlinien:

- Das DHCommons Journal, in dem noch laufende Projekte ein Statement veröffentlichen können, auf das in zwei unabhängigen Reviews Bezug genommen wird. Das Journal bietet eigene »Review Guidelines« zur Orientierung für die Autoren an.[18]

- Ein Formular zur Evaluation digitaler geisteswissenschaftlicher Projekte, das von dem mexikanischen Netzwerk Red de Humanidades Digitales entwickelt worden ist und online ausgefüllt werden kann sowie begleitende Best Practices (»Guía de buenas prácticas«)[19].

Ansätze aus einzelnen Fachbereichen und für bestimmte Forschungsgebiete:

- Die »Guidelines for the Evaluation of Digital Scholarship in History« von der American Historical Association (AHA)[20].

- Die vom Institute of Historical Research der University of London herausgegebene Rezensionszeitschrift »Reviews in History«,[21] die sowohl Rezensionen zu gedruckten Büchern als auch zu digitalen Ressourcen einschließt.

- Das von Eighteenth-century Scholarship Online (18th Connect) eingerichtete Peer-Review-System für digitale Ressourcen und Archive zum 18. Jahrhundert.[22]

- Die von der Networked Infrastructure for Nineteenth-Century Electronic Scholarship (NINES) etablierte Struktur für Peer-Reviews mit »Guidelines for Promotion and Tenure Committees in Judging Digital Work«[23].

Richtlinien für die Evaluation wissenschaftlicher, einschließlich digitaler Editionen:

- Die von der MLA herausgegebenen »Guidelines for Editors of Scholarly Editions«[24], die auch eine Liste von Fragen für Gutachtern enthalten.

- »Förderkriterien für wissenschaftliche Editionen in der Literaturwissenschaft«[25] der Deutschen Forschungsgemeinschaft.

Kriterien für die Evaluation digitaler wissenschaftlicher Editionen:

- Die von der Association for Documentary Editing verfassten »Minimum Standards for Electronic Editions«[26].

- »Bewertungskriterien für elektronische Editionen« von Fotis Jannidis, bei denen der »Bedarf einer Klärung« betont wird, den elektronische Editionen als »neue Gegenstände im philologischen Alltag« im Vergleich zu gedrucken Editionen hervorrufen, bei denen die Kriterien »mehr oder wenige selbstverständlicher Teil des Fachs«[27] sind.

- Die vom Institut für Dokumentologie und Editorik (IDE) herausgegebenen »Kriterien für die Besprechung digitaler Editionen«[28].

Rezensionszeitschriften für digitale wissenschaftliche Editionen:

- Das »Magazin für digitale Editionswissenschaften« vom Interdisziplinären Zentrum für Editionswissenschaften der Friedrich-Alexander-Universität Erlangen-Nürnberg, welches ein Forum zur Vorstellung von Best Practices für digitale Editionen bieten möchte und bei dem laufende Editionsprojekte mit Beiträgen verschiedene Aspekte ihrerde Arbeit vorstellen können.[29]

- Das vom IDE herausgegebene Rezensionsjournal ride (A Review Journal for Digital Editions and Resources)[30], zu dem auch ein Fragebogen ( »Questionnaire«) gehört, mit dem umfassende Informationen zu den rezensierten Editionen systematisch erfasst werden.

Es gibt also eine Reihe von Hinweisen für die Evaluation digitaler Forschung und Experimente mit unterschiedlichen Formen der Bewertung. Die Initiatoren der Entwicklung von Richtlinien und Foren für Evaluation sind einerseits Einzelpersonen, häufiger aber Gruppen von Wissenschaftlern und Forschungsinstitutionen. Es ist auffällig, dass Rezensionsjournale und -plattformen in den meisten Fällen von eigenen Vorschlägen für Bewertungskriterien begleitet werden, welche als Hilfestellung oder Anleitung fungieren. Dies zeugt von einem Bewusstsein dafür, dass im Digitalen neue Maßstäbe für die Bewertung laufender oder abgeschlossener Forschungsarbeiten angesetzt werden müssen, welche nicht als selbstverständlich vorausgesetzt werden können. Zugleich erfüllen die Kriterien oft die doppelte Funktion, eine Bewertungsgrundlage für Gutachter zu sein und zugleich eine Checkliste für Wissenschaftler, die digitale Projekte planen und umsetzen. Zu erkennen ist, dass mit der als Unterstützung gedachten Explizierung von Kriterien eine gewisse Formalisierung des Bewertungsprozesses einhergeht. Auch Fragebögen, mit denen detailliert und strukturiert Informationen zu der jeweils betrachteten digitalen Ressource abgefragt werden, deuten in diese Richtung.

2. Evaluation von digitalen Editionen

Es ist nun bereits viel über die Evaluation von digitaler Forschung und digitalen Forschungsergebnissen im Allgemeinen gesagt worden. Die Herausforderungen und Fragen, die sich bei der Bewertung digitaler Arbeit insgesamt stellen, treffen gleichermaßen auf digitale wissenschaftliche Editionen zu, in vielen Aspekten sogar ganz besonders.

Um eine digitale Edition erstellen und bewerten zu können, sind neben den fachlichen und technischen Kompetenzen zusätzlich Kenntnisse in editionswissenschaftlicher Theorie und Methodik notwendig. Die entstehenden Ausgaben können in ihrem Aufbau und der Präsentation einen hohen Grad an Komplexität erreichen. Wegen der Unterschiedlichkeit der edierten Gegenstände, der theoretischen Fundierung, der unterschiedlichen Methodiken und Zielstellungen wird kaum eine Edition einer anderen gleichen. Bei Bewertungen müssen all diese Aspekte berücksichtigt werden.

Speziell für Editionen ergibt sich ein zusätzlicher Bedarf für Evaluation daraus, dass dieselben Gegenstände – historische Dokumente und literarische Werke etwa – auch in nicht-wissenschaftlicher Form digital aufbereitet und präsentiert werden. War dies auch bereits im Gedruckten der Fall, so scheint es, dass die Grenzen im Digitalen nicht so deutlich zu ziehen sind und eine Abgrenzung dringender wird. Das mag auch damit zu tun haben, dass die Gestalt wissenschaftlicher Editionen im Digitalen weniger festgelegt ist als sie es im Druck noch ist. Neben dem Attribut der Wissenschaftlichkeit kann auch die Kennzeichnung als ›Edition‹ zur Debatte stehen. Einige Tendenzen, die im Zusammenhang mit digitalen Editionen häufiger genannt werden, lassen diese in die Nähe digitaler Archive rücken, so dass auch in dieser Hinsicht definitorische und begriffliche Klärungen nötig sind.[31]

Eine weitere Frage betrifft den digitalen Charakter einer wissenschaftlichen Edition. Ist überhaupt ein Unterschied zu machen zwischen einer ›traditionellen‹ wissenschaftlichen Edition und einer digitalen wissenschaftlichen Edition? Hierzu gibt es unterschiedliche Standpunkte. Fließen diese in die Formulierung von Best Practices und Bewertungskriterien ein, dann kann das die Ergebnisse der Evaluation von digitalen Editionen beeinflussen. Es wird deutlich, dass nicht nur die Editionen selbst diskutiert werden müssen, sondern auch Guidelines, Fragenkataloge und deren theoretische Fundierung. Schon die Titel von Richtlinien, Rezensionszeitschriften und -plattformen kommunizieren eine bestimmte Haltung: Taucht ›digital‹ im Titel auf oder nicht? Wird es also zumindest vorübergehend als notwendiger Bestandteil der Benennung von Gegenständen angesehen, als Verweis auf eine eigene Art, oder spielt das Medium keine Rolle? Die Deutsche Forschungsgemeinschaft z. B. spricht allgemein von »Förderkriterien für wissenschaftliche Editionen in der Literaturwissenschaft«[32]. Empfohlen wird, bei der Erstellung von Editionen digitale Werkzeuge zu verwenden und die Textdaten in digitaler Form zu sichern und bereitzustellen, aber »[n]icht für jedes Editionsprojekt wird eine digitale Veröffentlichtungsform erwartet«[33]. An anderer Stelle wird ein wesentlicher Unterschied zwischen gedruckten und digitalen Editionen angenommen. Die Kriterien des Instituts für Dokumentologie und Editorik sind in dieser Hinsicht streng: »›Digitale Editionen‹ werden nicht nur in digitaler Form publiziert, sondern folgen in ihrer Methodologie einem digitalen Paradigma. […] Retrokonvertierte gedruckte Editionen oder vertiefende Digitalisierungs- und Erschließungsprojekte in Bibliotheken und Archiven überschreiten oft nicht die Schwelle zu ›digitale Editionen‹ im hier verwendeten Sinne.«[34]

Die Ziele der Evaluation digitaler wissenschaftlicher Editionen können also sein: Zu überprüfen, ob Konzepte und Pläne förderungswürdig sind; bei laufenden Vorhaben zu unterstützen und zu beraten; wissenschaftliche Leistungen festzustellen und zu beurteilen; überhaupt festzustellen, ob eine digitale Ressource eine digitale wissenschaftliche Edition ist und damit auch in eine theoretische und methodische Diskussion um das Wesen, die Grenzen und die Entwicklung des Gegenstandes einzutreten; die Erstellung digitaler Editionen zu fördern. Strenge Kriterien, was die Wissenschaftlichkeit und Digitalität von Editionen betrifft, sollten nicht in erster Linie als Ausschlussprinzipien und exklusive Merkmale angesehen werden, sondern als ein Angebot von Vorschlägen, die bei einer Evaluation als Leitfaden dienen und bei der Erarbeitung einer digitalen Edition eine Orientierung bieten können. Denn nicht alle wissenschaftlichen Editionen werden bereits in digitaler Form erstellt. Kriterien und Evaluationen sollen auch dazu beitragen, das Vertrauen in digitale Editionen zu stärken und die Überführung grundlegender historischer Texte und Objekte in digitale Repräsentationen zu fördern.

Werden Bewertungen wie ausgefüllte Fragebögen, Rezensionen und Gutachten gesammelt und veröffentlicht, können sie dazu beitragen, einen Eindruck vom Stand der Dinge in der digitalen Editorik zu vermitteln. Noch systematischer gelingt dies mit Katalogen, die eine Vielzahl digitaler Editionen erfassen und einordnen. Solche Übersichten können selbst wieder den Bedarf an Evaluation sichtbar machen, wenn sie zeigen, in welchen Bereichen es noch nicht viele digitale Editionen gibt oder wo es – reduziert auf die erfassten Charakteristika der Editionen – Verbesserungsmöglichkeiten gibt.

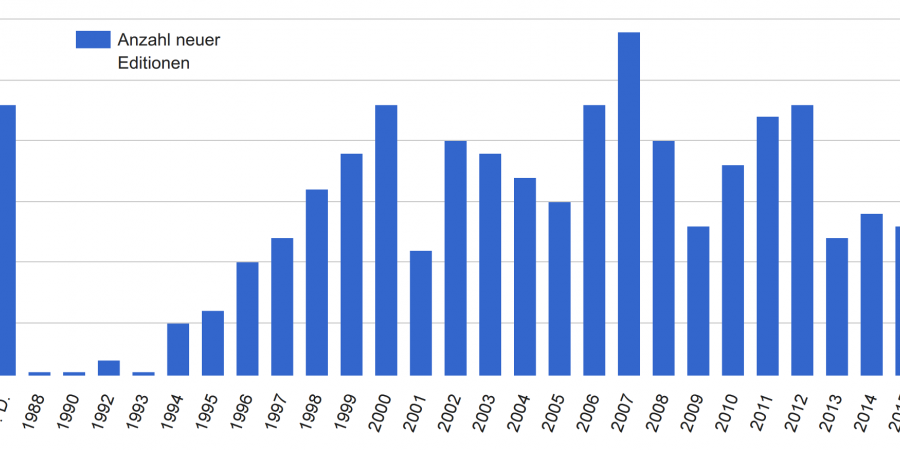

Die folgenden Abbildungen basieren auf dem Katalog »Digital Scholarly Editions«[35]. Abbildung 1 zeigt die jährliche Anzahl neuer digitaler wissenschaftlicher Editionen, die im Katalog erfasst wurden. Insgesamt sind dies aktuell 391 Editionen. Es ist zu berücksichtigen, dass insbesondere die geringen Zahlen in den letzten Jahren darauf zurückzuführen sind, dass vom Herausgeber des Katalogs noch nicht alle neuen Editionen aufgenommen werden konnten. Einer groben Schätzung zufolge werden etwa 100 weitere Editionen vorliegen, weshalb die folgenden Interpretationen durch weitere Daten zu stützen wären und nur eine erste Annäherung darstellen können. Erkennbar ist, dass die Zahl neuer Editionen vor allem in den 90er Jahren kontinuierlich und deutlich angestiegen ist, dass dieser Trend aber ab dem Jahr 2000 nicht in gleicher Weise angehalten hat. Erwähnenswert ist auch, dass sich bei über 20 Editionen keine Angabe zum Erstellungsdatum oder dem Datum der letzten Änderung ausmachen ließ. Wenn digitale wissenschaftliche Editionen zitierfähig sein sollen und Zweifel an ihrer Wissenschaftlichkeit und Verlässlichkeit ausgeräumt werden sollen, ist das ein Missstand, auf den Evaluationen hinweisen müssen.

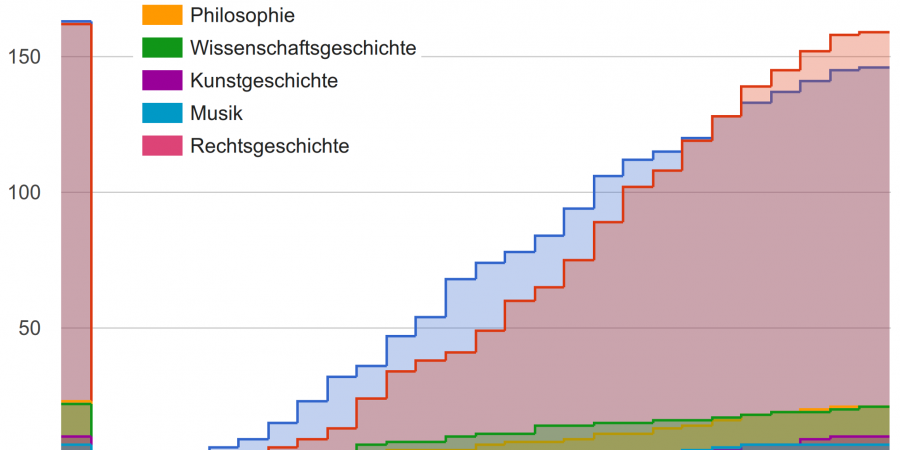

Abbildung 2 zeigt die Gesamtzahl digitaler wissenschaftlicher Editionen nach Fachbereichen und Jahren. Den Katalogauswertungen zufolge kommt der Großteil der digitalen Editionen aus der Literatur- und Geschichtswissenschaft, was zu dem Eindruck passt, dass besonders in diesen Fachbereichen eigene Best Practices und Guidelines formuliert werden bzw. ihre Erarbeitung von diesen Fächern ausgeht.[36] Abbildung 3 veranschaulicht die Anteile an Editionen nach Art des edierten Materials. Gab es mehrere Zuordnungen, so wurde hier nur die jeweils erste berücksichtigt. Insgesamt zielen etwas mehr als 40% der Editionen auf einzelne oder gesammelte Werke, während etwa 55% dokument- oder objektzentriert sind.[37] Hier könnte noch näher untersucht werden, ob es Tendenzen im Zeitverlauf gibt. Die Auswertungen deuten an, welche Bereiche der digitalen Editorik – gemessen an der Zahl der entstandenen Editionen – bisher den Schwerpunkt ausmachen und wo der Raum für Entwicklungen – auch von Empfehlungen für Ersteller digitaler Editionen, Gutachter und Rezensenten – noch größer ist. Wenn das kulturelle Erbe in den nächsten Jahrzehnten umfassend digital gespeichert, verwaltet und zugänglich gemacht werden soll, ist es zentral, die Erstellung digitaler wissenschaftlicher Editionen zu fördern und ihre Qualität durch Evaluationen zu sichern.[38]

3. Kriterien zur Bewertung digitaler Editionen

Welche Kriterien sollten bei der Bewertung von digitalen

Editionen angesetzt werden?

Es soll an dieser Stelle nicht

darum gehen, Kriterien aus bestehenden Katalogen vollständig aufzuführen

oder neue Kriterien zu entwickeln. Die Hauptbereiche der Bewertung, wie sie

sich aus der Gliederung von Kriterienkatalogen ableiten lassen, sollen

skizziert und an zwei Beispielen soll eine visuell unterstützte Analyse von

Kriterienarten vorgenommen werden. Das Ziel ist, diejenigen Kriterien

auszumachen, die für digitale Editionen spezifisch sind.

Bei allen ›Guidelines‹ wird deutlich, dass das Bewerten digitaler wissenschaftlicher Editionen auf der einen Seite zu einem großen Teil mit dem Bewerten wissenschaftlicher Editionen gleichzusetzen ist und auf der anderen Seite mit dem Bewerten digitaler (wissenschaftlicher) Ressourcen im Allgemeinen. Für die Frage nach der Besonderheit digitaler Editionen im Hinblick auf ihre Evaluation sind daher vor allem die Bereiche von Bedeutung, in denen »wissenschaftliche Edition« und »digitale Ressource« bei der Formulierung der Kriterien zusammenkommen. Dies kann als Hinweis darauf gedeutet werden, in welchen Bereichen die digitale wissenschaftliche Edition aus Sicht der Guidelines nicht nur die Summe ihrer Teile, sondern in ihrem Wesen integrativ ist.

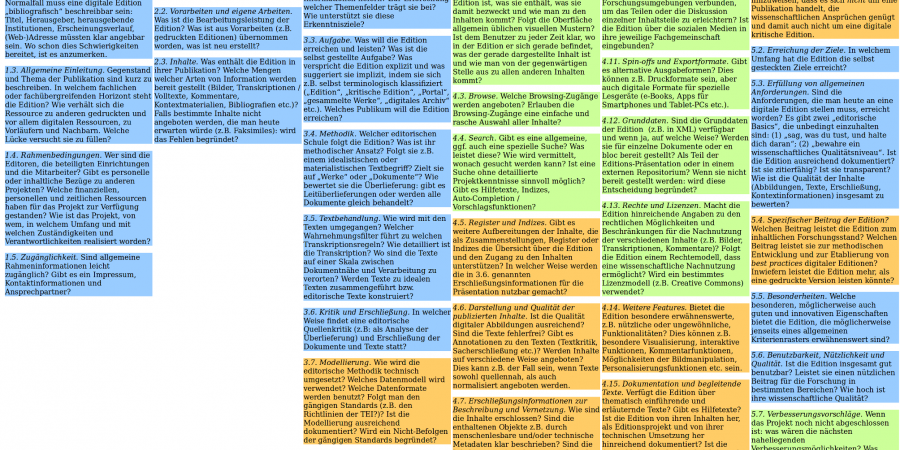

Abbildung 4 zeigt den Kriterienkatalog des Instituts für Dokumentologie und Editorik (IDE) mit farblich hinterlegten Kriteriengruppen. Die blau hinterlegten Bereiche sind Kriterien, die generell auf wissenschaftliche Editionen anwendbar sind, die grünen solche, die allgemein auf digitale (wissenschaftliche) Ressourcen zutreffen und die orange eingefärbten Punkte solche, die speziell für digitale wissenschaftliche Editionen von Bedeutung sind. Der Katalog des IDE ist in die Bereiche »Präliminarien der Besprechung«, »Gegenstand und Inhalte der Edition«, »Ziele und Methoden«, »Umsetzung und Präsentation« und »Fazit« eingeteilt. Bis zum letzten Unterpunkt des dritten Abschnitts »Ziele und Methoden« treffen die zugehörigen Kriterien auf wissenschaftliche Editionen im Allgemeinen zu. Es geht z. B. darum, welche Relevanz die Edition für die Forschung haben kann, welche Materialien ausgewählt wurden, inwieweit es Vorarbeiten gab, welche Inhalte in der Edition angeboten werden, ob die Ziele und Methoden der Edition reflektiert und dokumentiert werden, wie mit den Texten umgegangen wird und inwieweit Texte und Dokumente kritisch erschlossen werden. Erst beim Punkt »3.7 Modellierung« wird der digitale Aspekt relevant, wenn nach dem Datenmodell, Datenformaten und Standards und insbesondere danach gefragt wird, wie die editorische Methodik technisch umgesetzt wird. Der Bereich »Umsetzung und Präsentation« besteht weitgehend aus Kriterien, die auf digitale (wissenschaftliche) Ressourcen allgemein anwendbar sind. Es gibt Fragen nach der technischen Architektur, der Benutzungsoberfläche, Referenzierbarkeit, Schnittstellen, Exportformaten, Grunddaten, Rechten und Lizenzen, dauerhaften Nutzbarkeit. Die in diesem Abschnitt des Katalogs für digitale Editionen spezifischen Kriterien fragen danach, wie die Inhalte der Edition (Abbildungen, Texte und darüber hinausgehende Zusammenstellungen wie Indices) im Digitalen aufbereitet sind und wie sie in der digitalen Oberfläche weiter erschlossen wurden, z. B. durch interne und externe Vernetzung und Metadaten. Es wird nach weiteren, »ungewöhnlichen« Funktionalitäten wie Visualisierungen und Kommentarfunktionen gefragt und danach, ob Dokumentation und Editionsrichtlinien in die Präsentation aufgenommen sind. Im Fazit kommen die verschiedenen Arten von Kriterien, die zuvor in eigenen Bereichen behandelt wurden, zusammen, wenn es um eine abschließende Bewertung der Wissenschaftlichkeit, Digitalität, der Zielstellungen, Methoden und Ergebnisse der Edition geht. Für digitale Editionen wesentlich sind vor allem die Punkte 5.1 und 5.4: »5.1 Terminologische Einordnung. Handelt es sich eigentlich um eine digitale (wissenschaftliche, kritische) Edition und in welchem Sinne? Wie würde man die Ressource präzise beschreiben? [...]«[39], »5.4 Spezifischer Beitrag der Edition? Welchen Beitrag leistet die Edition zum inhaltlichen Forschungsstand? Welchen Beitrag leistet sie zur methodischen Entwicklung und zur Etablierung von best practices digitaler Editionen? Inwiefern leistet die Edition mehr, als eine gedruckte Version leisten könnte?«[40]

Auch bei dem Katalog, den Yates als Grundlage für die Verleihung eines Preises für die beste digitale Edition / das beste digitale Archiv formuliert, kommen Kriterien zusammen, die auf wissenschaftliche Editionen im Allgemeinen, digitale Ressourcen im Allgemeinen und digitale wissenschaftliche Editionen im Speziellen zutreffen. Die Kriterien sind in die Bereiche »Criteria for Inclusion: Scholarly standards«, »Criteria for Inclusion: Field«, »Criteria for Inclusion: Technical«, »Judging Standards: Usability« und »Judging Standards: Usefulness« eingeteilt. »Scholarly standards« und »Field« beziehen sich auf wissenschaftliche Genauigkeit und Strenge, den Beitrag zur Forschung und den relevanten Fachbereich einer wissenschaftlichen Edition. Beim Abschnitt »Usability« geht es um eine heuristische Evaluation der Oberfläche aus Nutzersicht, ein Aspekt, der für digitale Ressourcen im Allgemeinen relevant ist. Die für digitale wissenschaftliche Editionen spezifischen Kriterien sind in den Abschnitten »Criteria for Inclusion: Technical« und »Judging Standards: Usefulness« zu finden: »it should go further than a print edition can go, taking full advantage of the capacities of its medium«[41]. Die Edition sollte für das digitale Medium konzipiert worden sein, »live links« und Markup verwenden und vollständig im Web verfügbar sein. Gefragt wird danach, wie sich die digitale Edition zur neuesten Druckausgabe verhält, inwiefern sie interdisziplinäre Forschung und Lehre unterstützt, was ihre hervorragenden Merkmale sind und inwiefern die technischen Entscheidungen auf die ›Bedürfnisse‹ des Textes abgestimmt sind: »how does the medium contribute to the message of this work? […] The most difficult factor of evaluation is the fit of the material with the form of its digital edition. This question is not just a matter of whether the edition has taken advantage of every available technological option, but of the sensitivity shown by the editors to the philological demands of the text in making decisions about markup policy«[42]. Es wird auf das Spannungsverhältnis zwischen dem Streben nach ›individueller Spezifizität‹ in den Geisteswissenschaften und dem Streben nach Einheitlichkeit in der Technologie hingewiesen: »A good digital edition should walk this line in ways that are sensitive to its subject matter«[43].

Aus der Betrachtung der beiden Kriterienkataloge kristallisieren sich folgende Aspekte als ›wesentlich‹ für die digitale wissenschaftliche Edition heraus: (1) Ein grundlegender Bestandteil ist die digitale Modellierung und Codierung der Texte bzw. die erschließende Repräsentation des Editionsgegenstandes, die zunächst unabhängig von der medialen Präsentation ist. In der Textcodierung schlagen sich theoretische Haltungen und methodische Herangehensweisen nieder und wird sichtbar, inwieweit das Konzept der Edition stimmig ist. (2) Ein weiterer wesentlicher Aspekt ist ein möglichst innovativer Umgang mit dem digitalen Medium, insbesondere in der Gestaltung der Editionsoberfläche und ihrer Präsentation. Erneuerung und Experimentalität sind hier ein Standard, eine Best Practice, wenn Bewertungskriterien diese einfordern. Diese eigentliche Unvereinbarkeit ist den Autoren der Richtlinien aber bewusst, wenn sie darauf hinweisen, dass die Standardisierung an dieser Stelle in Konflikt mit neuen Ansätzen steht und dass auch die Kriterien selbst immer wieder diskutiert werden müssen, dass manches (noch) nicht standardisiert ist und einige Standards sich (noch) ändern.[44] Die spannende Frage ist, ob das ›Ausreizen‹ des Mediums ein wesentliches Merkmal digitaler Editionen bleiben wird oder ob es sich um eine Übergangsphase hin zu stabilen Modellen handelt.[45] (3) Im Markup und in der Präsentation sollten Inhalt und digitale Methode nicht unabhängig voneinander, sondern sinnvoll aufeinander bezogen sein.

4. Rezensionen als Evaluationsform

Die Bewertungskriterien, die aus theoretischen und methodischen Erwägungen heraus formuliert sein mögen und auch auf einem bestimmten praktischen Erfahrungsstand mit digitalen Editionen basieren können, treten erst durch ihre Anwendung in direkten Kontakt mit dem Gegenstand, für dessen Evaluation sie geschaffen wurden. Mit der Evaluation kann dann nicht nur die Edition diskutiert werden, sondern auch die Kriterien, so dass konkrete Bewertungen als Mittler zwischen Theorie und Praxis, zwischen Standards und individuelle Umsetzungen treten können.

Es wurden bereits verschiedene mögliche Formen der Evaluation genannt. Rezensionen, ›Reviews‹, stellen eine Möglichkeit dar, auf die hier kurz eingegangen werden soll. Aus dem Englischen kommend kann das Review allgemeinsprachlich die Handlung des genauen Betrachtens und Untersuchens von etwas sein, im Hinblick auf die Qualität des Betrachteten, aber auch auf seinen allgemeinen Zustand. Es kann zugleich Ausdruck und Niederschlag der Meinung sein, die sich jemand zur Qualität von etwas gebildet hat oder eine Zeitschrift, die Gedanken und Meinungen zu etwas versammelt. Das Präfix »re« darauf hin, dass man zu etwas zurückkehrt, sich einer Sache erneut zuwendet. Werden digitale Editionen in Rezensionen besprochen, so bedeutet dies also eine genaue Inspektion des Forschungsergebnisses, jedoch mit einer klaren individuellen Position, die von den Rezensenten bezogen wird und in die Bewertung einfließt. Angesichts des Aufkommens von Richtlinien, Fragebögen und weiteren formalisierten Zugängen zur Bewertung von digitalen Editionen sind individuelle Besprechungen wichtig, damit es nicht zu schematischen Bewertungen kommt, die eine Weiterentwicklung der Editionsmethoden oder der Evaluationsformen und -prinzipien selbst verhindern könnten. Die stärker geregelten Ansätze stellen zwar einen wichtigen Rahmen dar, der eine Etablierung von Best Practices für die digitale Editorik fördert, doch sollten Evaluationen sich nicht beispielsweise im Ausfüllen von Fragebögen erschöpfen, bei denen Bewertungskategorien und gegebenenfalls auch verschiedene Antworten vorgegeben sind. Eine Kombination und ein Wechselspiel verschiedener stärker und weniger stark formalisierter Evaluationsmethoden bietet sich an, um sowohl eine Festigung als auch Reifung der Methoden und Praxis des digitalen Edierens zu ermöglichen.

Traditionell ist die Rezension eine freie Form: »Häufig ist die Klage zu vernehmen, das Rezensieren kenne im Grunde keine Regeln und kein Gesetz. Allgemein anerkannte Programme oder Partituren, die rezensive Kritik verbindlich leiten könnten, existieren in der Tat nicht.«[46] Wenn Rezensionen von digitalen Editionen auf Katalogen mit Bewertungskriterien aufbauen, könnte das dazu führen, dass sich auch die Praxis des Rezensierens und die Rezension als Textsorte verändern, hin zu einem geregelteren und schematischeren Aufbau. So werden die Rezensionstexte in der vom IDE herausgegebenen Rezensionzeitschrift ride jeweils von einem sogenannten Factsheet begleitet, in dem die wichtigsten Fakten zu der besprochenen Edition noch einmal tabellarisch und überblicksartig zusammengefasst sind.[47] Die strukturierten Informationen zur digitalen Edition werden mit einem ausführlichen Fragebogen erhoben. Die Ergebnisse der bisher 25 ausgefüllten Fragebögen werden auf der Webseite von ride zusätzlich in Form von Datenvisualisierungen ausgewertet und präsentiert, z. B. zu den Fragen, ob die Editionen Resolver verwenden, wie das edierte Material lizenziert ist, ob Standards wie TEI verwendet werden, die Grunddaten zugänglich sind und welche Browsing-Zugänge die Editionsoberflächen bieten. Die Rezensionen werden also von formalen Darstellungen und Auswertungen begleitet. Um die Diskussion der digitalen Editionen nicht zu sehr anzuleiten und einzuengen, sollte darauf geachtet werden, dass der regelnde Einfluss der formalisierten Begleitmaterialien auf die Besprechungen in Textform nicht zu groß wird.

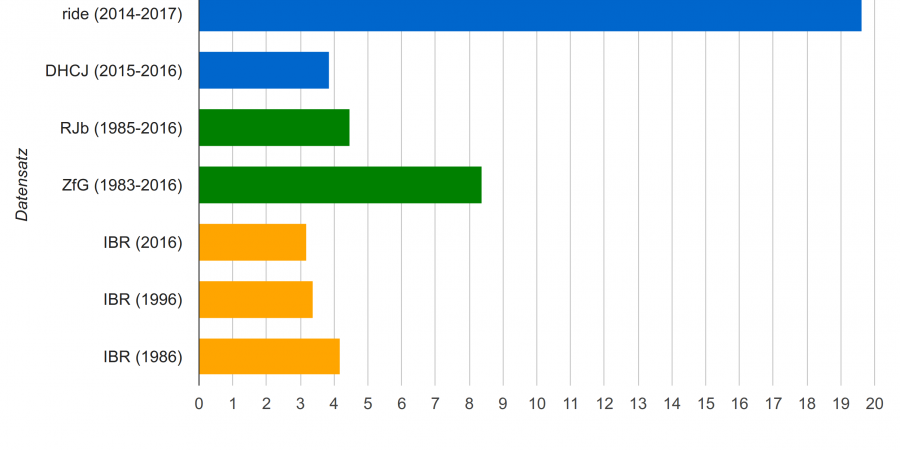

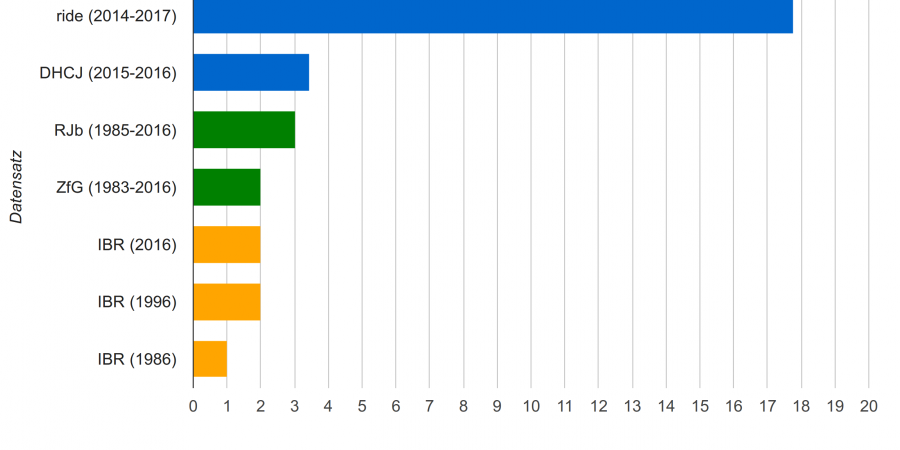

Eine weitere Eigenschaft der Rezensionen, die möglicherweise einem Wandel unterliegt, ist ihre Länge. Hat die Art des besprochenen Gegenstands Einfluss auf den Umfang der Rezensionen? Leider liegen nur wenige Daten für Rezensionen zu digitalen Editionen und digitalen Projekten insgesamt vor, so dass die Entwicklung des Umfangs von Rezensionen ebenso wie die Entwicklung der Anzahl digitaler Editionen nur tentativ erfolgen kann. Um einen Eindruck zu gewinnen, wird hier der Umfang der Rezensionen in ride und dem DHCommons Journal (DHCJ) mit demjenigen von Rezensionen aus dem Romanistischen Jahrbuch (RJb), der Zeitschrift für Germanistik (ZfG) sowie der Jahrgänge 1986, 1996 und 2016 aus der Internationalen Bibliographie der Rezensionen geistes- und sozialwissenschaftlicher Literatur (IBR-Online) verglichen. Die Auswahl der beiden Zeitschriften (RJb und ZfG) ist willkürlich getroffen. Die Untersuchung ließe sich auf weitere Zeitschriften ausweiten. Die Daten für das RJb und die ZfG stammen wie die übrigen bibliographischen Daten, die zum Vergleich mit ride und dem DHCJ herangezogen werden, aus der IBR. In IBR-Online werden bibliographische Metadaten zu Rezensionen in den Geistes- und Sozialwissenschaften ab 1983 erfasst. Aktuell werden 6.200 Zeitschriften indiziert. Für das IBR insgesamt wurden die Jahrgänge 1986, 1996 und 2016 ausgewählt, um Stichproben für die Entwicklung der Länge von Rezensionen zu erhalten. Es wurden jeweils die ersten 1000 Rezensionen aus diesen Jahrgängen berücksichtigt. Um die Länge der Rezensionen zu ermitteln, wurden die Seitenumfänge herangezogen. Einträge mit Umfängen bis 47 Seiten wurden als Rezensionen gewertet. Einträge ab 48 Seiten wurden als Monographien gewertet und nicht einbezogen. Da es bei ride und dem DHCJ keine Seitenangaben gibt, wurde dort ausgehend von den Volltexten und auf der Grundlage einer Normseite à 1500 Zeichen ein Seitenumfang berechnet, um einen Vergleich mit den Angaben aus der IBR zu ermöglichen. Abbildung 6 und 7 zeigen die Ergebnisse für die Mittelwerte und Mediane der Seitenumfänge der Rezensionen in den verschiedenen Datensätzen:

In beiden Abbildungen wird deutlich, dass die Rezensionen in ride deutlich länger sind als in den anderen Zeitschriften. Ein deutlicher Trend hin zu längeren Rezensionen für digitale Ressourcen im Vergleich zu Rezensionen zu gedruckten Publikationen lässt sich so nicht begründen, nicht nur wegen der wenigen vorliegenden Daten zu Rezensionen, die digitale Forschungsergebnisse zum Gegenstand haben. In ride liegen derzeit 25 Rezensionen vor, beim DHCJ sind es nur 14. Im Vergleich dazu wurden hier aus dem RJb 452 Rezensionen berücksichtigt, aus der ZfG 1.918 und aus den Jahren 1986, 1996 und 2016 jeweils 1000. Es ist außerdem nicht klar, wie viele der im Online-IBR erfassten Rezensionen digitale Ressourcen besprechen. Wird der Median als Vergleichsmaß angesetzt, dann liegt neben ride auch das DHCJ vor den anderen Gruppen, der Mittelwert dagegen ist insbesondere für die ZfG, aber auch das RJb und den Jahrgang 1986 höher. Ob ride den Umfang der Rezensionen betreffend ein Einzelfall ist, wäre näher zu untersuchen, sobald mehr Rezensionen zu digitalen Editionen aus anderen Publikationsorganen zugänglich sind.

Die Rezensionen in ride unterscheiden sich von ›klassischen‹ Rezensionen darüber hinaus auch dadurch, dass sie vor der Veröffentlichung einen Peer-Review-Prozess durchlaufen.[48] Das Peer Review soll dazu beitragen, die Rezensionen in die Nähe von wissenschaftlichen Aufsätzen zu rücken. Neben der Qualitätssicherung und Verbesserung der digital veröffentlichten Rezensionen hat das Peer-Review die Funktion, die Rezensenten durch das Feedback von ›peers‹ aus dem jeweiligen Fachbereich und den digitalen Geisteswissenschaften darin zu unterstützen, sowohl inhaltliche als auch technische Aspekte evaluieren zu können. Hier wäre natürlich auch ein Ansatz denkbar, bei dem mehrere Autoren Rezensionen verfassen, wie es bei DHCommons der Fall ist. Auch könnte man kritisieren, dass durch ein »Reviewing von Reviews« mit aller (übertriebener?) Kraft versucht wird, die Zweifel an der Wissenschaftlichkeit digitaler Veröffentlichungen auszuräumen. Es muss aber auch gesagt werden, dass solche Initiativen prinzipiell begrüßt werden sollten, da die verschiedenen Ansätze zur Evaluation digitaler Editionen im Moment noch Experimente sind.

Dadurch, dass Rezensionen in Zeitschriften veröffentlicht werden, haben sie z. B. internen Bewertungen oder Diskussionen in sozialen Medien gegenüber den Vorteil, dass die Begutachtungen für andere leichter auffindbar, nachvollziehbar und nachnutzbar sind. Die Rezensionen geben einen bestimmten Diskussionsstand wieder. Sie können von den Erstellern digitaler Editionen als Anregung dafür genutzt werden, die Edition noch zu verbessern – unter Umständen könnten die Rezensionen dann sogar wiederholt werden – und anderen als Inspiration für eigene, geplante Vorhaben dienen. Sie bieten als prinzipiell freie Textform Raum für die Auslegung, Diskussion und Anwendung von Evaluationskriterien und für eine Kontextualisierung. Wie in anderen Fachbereichen auch, ist der Blick zurück, das ›re-view‹, ein sinnvoller Ansatz, um zur weiteren Entwicklung des immer noch jungen Feldes der digitalen Editorik beizutragen.

5. Fazit

Die Betrachtung der Zielstellungen, Herausforderungen, Problemfelder und Lösungsansätze zur Evaluation digitaler Forschungsergebnisse insgesamt hat deutlich werden lassen, dass in diesem Themenbereich sowohl theoretisch als auch praktisch noch viel zu leisten ist. Ergebnisse dieses Beitrags sind, dass eine Bewertung durch mehrere Personen mit unterschiedlichen Kompetenzen sinnvoll sein kann oder Evaluatoren auf andere Weise unterstützt werden sollten, damit sowohl inhaltliche als auch methodische und technische Aspekte in Evaluationen einfließen können. Best Practices, Guidelines und Kriterienkataloge, die zunehmend entwickelt werden, unterstützen den Bewertungsprozess auf sinnvolle Weise. Sie können Gutachter, die über Disziplinengrenzen hinweg Evaluationen vornehmen müssen, zur Orientierung dienen. Kriterien können, wenn sie zu spezifisch formuliert werden, zugleich problematisch sein, da sie einen bestimmten methodischen Entwicklungsstand als Best Practice fixieren. Sie müssen daher selbst fortlaufend diskutiert werden.

Damit digitale Forschungsergebnisse aller Art auf allen Ebenen und in allen Facetten bewertet werden können, die sie ausmachen, sind Dokumentation, Transparenz und Offenheit von Seiten der Wissenschaftler wesentlich. Nur so können neben Präsentationsformen auch Forschungsdaten, Textcodierungen, in Projekten entwickelte Werkzeuge und Programmteile evaluiert werden, wenn diese entscheidend zum Wesen und der Gestalt der Edition beitragen. Ein bewusstes Publizieren von Teilergebnissen kann das Signal für die Beurteilungsfähigkeit digitaler Arbeiten geben. Eine Konzentration auf die Bewertung von Ergebnissen gegenüber Praktiken ist sinnvoll: Wenn beispielsweise Tools selbst Ergebnisse der Forschung in einem Editionsvorhaben sind, wären sie Gegenstand einer Rezension, während der Einsatz bestehender Tools zur Gewinnung von Ergebnissen als Praktik gewertet würde. Praktiken könnten eher im Rahmen von Gutachten zu Projektanträgen, also mit Blick auf die Zukunft, bewertet werden, oder in Form von Beratungen im Projektverlauf, sind ansonsten aber schwer zu erfassen, weshalb für Rezensenten die Beurteilung der publizierten Ergebnisse im Vordergrund stehen sollte. Praktiken würden nur im Sinne eines dokumentierten methodischen Vorgehens, welches Teil von publizierten Ergebnissen sein kann und sollte, in das Blickfeld von Rezensionen rücken. Digitale wissenschaftliche Editionen müssen den grundsätzlichen Anforderungen an wissenschaftliche Editionen genügen und unterscheiden sich in dieser Hinsicht nicht von gedruckten wissenschaftlichen Editionen. Als digitale Ressourcen haben digitale wissenschaftliche Editionen Vieles mit anderen Arten digitaler Forschungsergebnisse (wie z. B. digitale Archive oder digitale Tools) gemeinsam. Trotzdem sind für die Evaluation und insbesondere das Reviewing von digitalen wissenschaftlichen Editionen auch eigene Bedarfe und Kriterien auszumachen. Die Kriterien betreffend kann diskutiert werden, ob nicht für verschiedene Arten von digitalen wissenschaftlichen Ressourcen auf allgemeine Richtlinien verwiesen werden kann und Kriterien für einzelne Fachbereiche, bestimmte Arten von Ressourcen und bestimmte Gegenstände sich auf das jeweils Spezifische konzentrieren. Für digitale Editionen spielt die Repräsentation des edierten Gegenstandes in digitalen Daten eine besondere Rolle, z. B. in Form einer Textcodierung: Ist sie durchdacht und angemessen? Auf der anderen Seite ist wesentlich, wie die Edition sich digitale Präsentationsformen zunutze macht. Hier kann besonderer Wert auf Innovation gelegt werden, vor allem aber ist auch bei der Entwicklung von Benutzungsoberflächen entscheidend, dass Inhalt und Form gut aufeinander abgestimmt sind.

Digitale Editionen zu besprechen und zu bewerten trägt zur praktischen Weiterentwicklung und Etablierung des Edierens im digitalen Medium bei. Die Erstellung digitaler Editionen wird gefördert, die Qualität der entstehenden Editionen gesichert, gute Umsetzungen hervorgehoben und die Möglichkeit gegeben, aus Fehlern zu lernen. Wenn Evaluationen einzelne digitale Editionen diskutieren und einordnen, führt dies zugleich zu einem fortwährenden Diskurs zur Definition der ›digitalen Edition‹ und zu den Methoden und Zielen des digitalen Edierens.

Erfolgt die Evaluation wissenschaftlicher Ergebnisse im digitalen Medium und bezieht sie sich auf digitale Forschungsergebnisse, unterliegt sie selbst einem medial induzierten Wandel. Dies wurde am Beispiel der Rezension als Evaluationsform aufgezeigt. Rezensionen tendieren (zumindest im Fall von ride) zu mehr Umfang, orientieren sich an Kriterienkatalogen, folgen diesen unter Umständen in ihrer inhaltlichen Struktur und werden von formalen Auswertungen wie Datenvisualisierungen begleitet. Trotzdem ist die Rezension als narrative Textform, die offen gestaltet werden kann, besonders geeignet, um zwischen Theorie, Methodik und Empirie der digitalen Edition zu vermitteln und vor allem auch ein gutes Gegengewicht zu Kriterienkatalogen zu bilden, die zu einer Formalisierung und Festschreibung von Bewertung und Bewertungsmaßstäben tendieren. Rezensionen bleiben als Evaluations-Use Cases für andere zugänglich und nachvollziehbar. Während auch neue Formen der Evaluation entstehen, ist es zunächst sinnvoll, auf ein etabliertes Verfahren wie die Rezension zurückzugreifen, bei dem Produktion und Rezeption eingespielt sind, um so die Diskussion über die im Digitalen entstehenden Forschungsergebnisse in Gang zu bringen.

Schließlich kann festgehalten werden: Wenn digitale Forschung und ihre Ergebnisse und insbesondere das digitale Edieren als Methode noch nicht sehr etabliert sind, so gilt das für ihre Evaluation erst recht, weshalb die Diskussion möglicher Ansätze essentiell ist. Zugleich sollte es mehr Bewertungen digitaler Arbeiten geben, um deren Reputation zu fördern und zur Stabilisierung des Feldes beizutragen.

Fußnoten

-

[1]Im Rahmen dieses Beitrags wird Evaluation in einem allgemeinen Sinn als Begutachtung verstanden, die zu unterschiedlichen Zeitpunkten stattfinden (etwa vor oder nach Veröffentlichtung), unterschiedliche Funktionen haben (z. B. Qualitätssicherung oder Bewertung) und von unterschiedlichen Akteuren vorgenommen werden kann. Reviewing hingegen wird als eine bestimmte Form der Evaluation aufgefasst, die nach Veröffentlichung mit dem vorrangigen Ziel der Bewertung stattfindet.

-

[2]So Fitzpatrick: »In my own promotion review, despite the fact that I was a scholar whose work took new digital modes of communication as its explicit focus, questions were raised about the relative status of online and print publications.« (Fitzpatrick 2011, S. 196.) und Schreibman et al: »There is a growing consensus that humanities disciplines must find ways not simply of evaluating but also of valuing digital scholarship as part of hiring, promotion, and tenure decisions.« (Schreibman et al. 2011, S. 123.) Rockwell nennt die Aufforderung der Modern Language Association, die Legitimität von in neuen Medien produzierter Wissenschaft anzuerkennen, einen »dramatic move« (Rockwell 2011, S. 152) und Cohen und Fragaszy Troyano führen an, dass von mancher Seite gar eine Neudefinition oder zumindest Erweiterung dessen gefordert werde, was anrechnungsfähige Wissenschaft sei (Cohen / Fragaszy Troyano 2012). Im DFG-Projekt Future Publications in den Humanities (FuPush), in dem die Potentiale digitalen Publizierens untersucht worden und Handlungsempfehlungen entwickelt worden sind, ist festgestellt worden, dass Geisteswissenschaftler sich »nach wie vor weitgehend an traditionellen Formen aus der Printkultur« orientieren und wenn sie digital publizieren, dann an »den etablierten Modellen der Verlagspublikation in einem dem Printparadigma möglichst ähnlichen Format« (Kaden et al. 2016). In diesem Zusammenhang ist auch auf die Aktivitäten der AG Publikationen des DHd-Verbands hinzuweisen, der das Verständnis digitaler Publikationen fördern und Empfehlungen entwickeln möchte, welche Entscheidungsträgern für eine gute digitale Praxis an die Hand gegeben werden sollen. Vgl. Stäcker et al. 2016.

-

[3]

-

[4]Das Journal of Digital Humanities widmet dem Thema im Herbst 2012 eine ganze Ausgabe, vgl. Journal of Digital Humanities 1 (2012) H. 4. Im 2011er-Jahrgang der Zeitschrift Profession findet sich eine frei verfügbare Sektion zum Thema »Evaluating Digital Scholarship«, vgl. Profession (2011). Auf der internationalen Konferenz dh2016 wird das Thema »Evaluation« im Prä-Konferenz-Workshop »RDA/ADHO Workshop: Evaluating Research Data Infrastructure Components and Engaging in their Development«, bei dem Panel »The Scholarly Digital Edition: Best Practices, Guidelines, and Peer Evaluation« und den Beiträgen »Evaluating GitHub as a Platform of Knowledge for the Humanities« sowie »Prototypes as Thinking through Making. Decision Points and Evaluation in Prototyping a Visualisation Framework for Historical Documents« aufgegriffen. Vgl. Digital Humanities 2016.

-

[5]Pfannenschmidt / Clement 2014, Absatz 1–2.

-

[6]Pfannenschmidt / Clement 2014, Absatz 2.

-

[7]Vgl. Rockwell 2011, S. 152.

-

[8]Vgl. Rockwell 2011, S. 152–153. Rockwell weist darauf hin, dass es bei der Beurteilung der Leistung von Nachwuchswissenschaftlern aber auch sinnvoll sein kann, auch digitale Praktiken zu berücksichtigen, um auf künftige erwartbare Ergebnisse schließen zu können.

-

[9]Vgl. Pfannenschmidt / Clement 2014, Absatz 32.

-

[10]Vgl. Pierazzo 2015, S. 188.

-

[11]Zum Thema Peer-Review meint z. B. Cavanagh, dass es durch die digitale Revolution schon zu einem Wandel gekommen sei, der aber noch nicht ausreichend erkannt und diskutiert worden sei. Das Peer-Review habe schon andere Qualitäten angenommen und unterliege anderen Bedingungen. Während es bei traditionellen Vorhaben oft auch erst zu einem späten Zeitpunkt erfolgen kann, wenn etwa eine Finanzierung eingeworben werden soll, müsse man sich bei digitalen Projekten schon früh Bewertungen unterziehen, um überhaupt über eine konzeptionelle Phase hinausgehen zu können. Auch müsse man dabei direkt in Kontakt mit Zuständigen treten, um z. B. die Verfügbarkeit von technischen Ressourcen zu klären, so dass der Review-Prozess nicht in gleichem Maße anonym bleiben könne wie es traditionellerweise angestrebt wird. Zudem trete man auch in Konkurrenz zu Nicht-Geisteswissenschaftlern. Vgl. Cavanagh 2012.

-

[12]Hodel / Zerwas 2016. Versuche mit Open Peer-Review sind z. B. auch von den Zeitschriften Shakespeare Quarterly und Postmedieval durchgeführt worden. Vgl. Fitzpatrick 2011, S. 197.

-

[13]Vgl. Fitzpatrick 2011, S. 199.

-

[14]Vgl. Yates 2008.

-

[15]

-

[16]Vgl. Rockwell 2012.

-

[17]Vgl. Presner 2012.

-

[18]Vgl. DHCommons Journal 2015.

-

[19]

-

[20]

-

[21]Vgl. Reviews in History 1996.

-

[22]Vgl. 18th Connect 2010.

-

[23]Vgl. NINES und Della Coletta et al. 2011.

-

[24]

-

[25]

-

[26]

-

[27]

-

[28]Vgl. Sahle et al. 2014.

-

[29]

-

[30]

-

[31]Zu den öfter angeführten Tendenzen zählen die zunehmende Einbindung von Kontextmaterialien in die Edition, eine stärkere Orientierung an der Erschließung von Dokumenten statt an Werken und ein durch die digitalen Verfahren erst realistisch erscheinender Vollständigkeitsanspruch. Sahle meint dazu: »Wenn sich Inhalte, Strukturen und Präsentationsformen der Edition grundlegend wandeln, dann müssen die traditionellen Begriffe zur Kennzeichnung dieses Unternehmens neu justiert werden, weil ihr Verhältnis zu benachbarten Konzepten – die ebenfalls in Bewegung geraten – unklar wird und es zu Überschneidungen kommen kann. Für die Edition betrifft das vor allem das Konzept des Archivs. Wenn der Schwerpunkt editorischer Arbeiten sich zunächst in Richtung auf die Erschließung der Überlieferung und die genaue Wiedergabe der Dokumente verschiebt, das digitale Archiv aber zugleich die Grunderschließung durch vollständige bildliche Wiedergaben ergänzt, dann bewegen sich beide Begriffe offenkundig aufeinander zu« (Sahle 2013, S. 152f.). Zum Thema Dokumentorientierung führt Robinson an: »For both Gabler and Pierazzo, digital editing is rooted in the document […] However, Gabler sees an editor as much more than a collector of documents, and a digital edition as much more than an archive. In this document-centred editing, Gabler argues that the central responsibility of the editor is to explain to the reader the tale told by the documents« (Robinson 2013, S. 111).

-

[32]

-

[33]

-

[34]Sahle et al. 2014. Das Konzept »digitales Paradigma« wird bei Sahle näher erläutert. Ein Aspekt betrifft das Verhältnis zum Druck: »Eine digitale Edition ist dadurch bestimmt, dass sie nicht ohne wesentliche Informations- und Funktionsverluste in eine typografische Form gebracht werden kann – und in diesem Sinne über die druckbare Edition hinausgeht« und weiter: »Die digitale Edition ist dadurch gekennzeichnet, dass ihre Grunddaten in elektronischer Form vorliegen«, »Eine Theorie der digitalen Edition ist aus den allgemeinen Anforderungen und Zielstellungen an wissenschaftliche Editionen insgesamt abzuleiten und wird dadurch gekennzeichnet, dass sie hier einen umfassenden Anspruch verfolgt, was die inhaltliche Wiedergabe, die Erschließung, den Einsatz aktueller Technologien und die Berücksichtigung methodischer Rückwirkungen dieser Technologien betrifft« (Sahle 2013, S. 149f.).

-

[35]Sahle 2008ff. Die Diagramme wurden von der Autorin auf der Basis der XML-Daten erstellt, die dem Katalog zugrunde liegen, und mit Hilfe von XSLT und der Google Chart API umgesetzt. Dank an Patrick Sahle für das zur Verfügungstellen der XML-Daten des Katalogs. Ein ähnlicher Katalog, der jedoch eine andere, weiter gefassste Definition von digitaler Edition zugrundelegt, wird von Greta Franzini gepflegt. Vgl. Franzini 2016. Wegen der bisher geringeren Zahl von Einträgen und einem anderen Ansatz bei der Erfassung der Metadaten wurde der Katalog von Franzini, der bei GitHub verfügbar und nachnutzbar ist, hier nicht einbezogen. Sowohl gedruckte als auch digitale Editionen werden in der Editionen-Datenbank des Deutschen Literaturarchivs Marbach dokumentiert, die derzeit (Stand Juli 2016) 135 Editionen verzeichnet. Vgl. Editionen-Datenbank 2016.

-

[36]Dazu zählen die bereits genannten »Guidelines for the Evaluation of Digital Scholarship in History 2015«, »Bewertungskriterien für elektronische Editionen 1999« von Fotis Jannidis, die von der DFG herausgegebenen »Förderkriterien für wissenschaftliche Editionen in der Literaturwissenschaft 2015« sowie die von Porta Historica »Qualitätskriterien für elektronische Quelleneditionen 2008« und die »Empfehlungen zum Umgang mit Editionen im digitalen Zeitalter « der Arbeitsgemeinschaft für germanistische Edition in Verbindung mit dem Deutschen Literaturarchiv Marbach, bei denen aber betont wird, dass es hinsichtlich der Empfehlungen »prinzipiell keinen Unterschied zwischen germanistischen Editionen und Editionen in anderen Disziplinen wie z. B. Philosophie, Geschichte oder Musikwissenschaft« gibt. Vgl. Empfehlungen zum Umgang mit Editionen im digitalen Zeitalter 2012.

-

[37]»Metaprojekt« meint größere Unternehmungen, die mehrere Teileditionen umfassen können.

-

[38]So führt Rockwell an: »It could be argued that work on scholarly electornic editions is particularly important at this juncture since we are in a transformative epoch when new scholarly resources are being designed and built for the next generation to interpret« (Rockwell 2011, S. 156).

-

[39]

-

[40]

-

[41]

-

[42]

-

[43]

-

[44]So Sahle et al. 2014: »Es kann nicht übersehen werden, dass sich viele Fragen noch in der Diskussion befinden und deshalb keine allgemeinen Anforderungen abgeleitet werden können. Besprechungen digitaler Editionen sollen bei diesesn Fragen auch einen Beitrag zur Methodendiskussion leisten«.

-

[45]Bei dem Panel »The Scholarly Digital Edition: Best Practices, Guidelines, and Peer Evaluation«, welches während der Konferenz dh2016 in Kraków am 13.7.2016 stattfand, hat Elena Pierazzo hervorgehoben, dass Experimentierfreude beim digitalen Edieren zwar erfreulich sei, eine gewisse Standardisierung aber ebenso wichtig, damit mehr digitale Editionen produziert werden, die digitalen Methoden von mehr EditorInnen für sinnvoll erachtet und angenommen werden und die Herausforderungen für NeueinsteigerInnen nicht zu groß sind.

-

[46]Bardelle 1989, S. 54.

-

[47]Vgl. ride. A Review Journal for Digital Editions and Resources. 2014-, z. B. die von Helmut Klug verfasste Rezension »Welscher Gast digital« (Klug 2016), die in der aktuellen vierten Ausgabe von ride erschienen ist.

-

[48]Die Qualitätsprüfung der Rezensionen vor ihrer Veröffentlichung wird in ride als Double-Bind Peer-Review durchgeführt, was bedeutet, dass weder die Rezensenten wissen, wer ihre Rezension begutachtet noch die Gutachter wissen, wer die Rezension geschrieben hat.

Bibliographische Angaben

- Frank Bardelle: Formen der kritischen Auseinandersetzung oder: Wie man Urteile über wissenschaftliche Neuerscheinungen verhängt. [online] In: Zeitschrift für Soziologie 18 (1989) H. 1, S. 54–64. [online] [Nachweis im GVK]

- Sheila Cavanagh: Living in a Digital World: Rethinking Peer Review, Collaboration, and Open Access. In: Journal of Digital Humanities 1 (2012), H. 4. [online]

- Daniel J. Cohen / Joan Fragaszy Troyano: Closing the Evaluation Gap. In: Journal of Digital Humanities 1(2012), H. 4.[online]

- Cristina Della Coletta et al. NINES Summer Institute 2011 Group: Guidelines for Promotion and Tenure Committees in Judging Digital Work. 2011. [online]

- DHCommons Journal. Hg. von centerNet. 2015-. ISSN 2378-2544. [online]

- Die Schnake 15/16 (2000). In: Die Schnake. Zeitschrift für Sprachkritik, Satire, Literatur. Hg. von Rainer Kohlmayer. Germersheim 1982-. ISSN 0723-722. [Nachweis im GVK]

- Digital Humanities 2016, Conference Agenda, 9. Juli 2016. [online]

- Editionen-Datenbank. Deutsches Literaturarchiv Marbach, Referat Editionen und Digital Humanities. Hg. von Roland S. Kamzelak, unter Mitarbeit von Lydia Michel. Version 2.2 Release vom 17.5.2016. Marbach 2012-. [online]

- Eighteenth-century Scholarship Online (18th Connect): Peer Review. Hg. von der Initiative for Digital Humanities, Media, and Culture, Texas A&M University. College Station, TX. 2010. [online]

- Empfehlungen zum Umgang mit Editionen im digitalen Zeitalter. Hg. von der Arbeitsgemeinschaft für germanistische Edition in Verbindung mit dem Deutschen Literaturarchiv Marbach. Marbach 31. Januar 2012. PDF. [online]

- Kathleen Fitzpatrick: Peer Review, Judgement, and Reading. DOI: 10.1632/prof.2011.2011.1.196 In: Profession (2011), S. 196–201. [online]

- Förderkriterien für wissenschaftliche Editionen in der Literaturwissenschaft. Hg. vom Fachkollegium Literaturwissenschaft der Deutschen Forschungsgemeinschaft. Bonn 2015. PDF. [online]

- Greta Franzini: A Catalogue of Digital Editions. Centre for Digital Humanities. University College London. London 2016. [online] und [online]

- Guidelines for Editors of Scholarly Editions. Hg. von der Modern Language Association (MLA). New York, NY. 29. Juni 2011. [online]

- Guidelines for Evaluating Work in Digital Humanities and Digital Media. Hg. von der Modern Language Association (MLA). New York, NY. Januar 2012. [online]

- Guidelines for the Evaluation of Digital Scholarship in History. Hg. von der American Historical Association (AHA). Washington, D.C. Juni 2015. [online]

- Jan Hodel / Marco Zerwas: Wikipedia in der Praxis. In: DWGD. Arbeitskreis digitaler Wandel und Geschichtsdidaktik der Konferenz für Geschichtsdidaktik. Blogbeitrag im Open Peer Review vom 6. Juli 2016. [online]

- Journal of Digital Humanities 1 (2012), H. 4. Hg. von Daniel J. Cohen / Joan Fragaszy Troyano. In: Journal of Digital Humanities (JDH). Hg. von Roy Rosenzweig Center for History and New Media. Fairfax, VA. 1.2011-. ISSN 2165-6673. [online]

- Humanidades Digitales – Evaluación. Formulario de evaluación para proyectos de Humanidades Digitales & Guía de buenas prácticas para la elaboración y evaluación de proyectos digitales en las Humanidades. Instituto de Investigaciones Bibliográficas. Universidad Nacional Autónoma de México. Mexico Stadt 2013. [online]

- IBR-Online. Internationale Bibliographie der Rezensionen geistes- und sozialwissenschaftlicher Literatur. Berlin u.a. 2009. [Nachweis im GVK]

- Fotis Jannidis: Bewertungskriterien für elektronische Editionen. In: IASLonline Diskussionsforum. München 1999. [online]

- Ben Kaden / Michael Kleineberg / Martin Walk: Digitales Publizieren in den Geisteswissenschaften. Abschlussbericht und Handlungsempfehlungen des DFG-Projektes Fu-PusH. Posterpräsentation vom 16.03.2016 auf Jahrestagung des Verbandes Digital Humanities im deutschsprachigen Raum. (DHd 2016: 3, Leipzig, 7.-12.3.2016) DOI: 10.5281/zenodo.47091

- Helmut W. Klug: Review of ›Welscher Gast digital‹. [online] In: ride 4 (2016). [online]

- Magazin für digitale Editionswissenschaften. Hg. vom Interdisziplinären Zentrum für Editionswissenschaften. Friedrich-Alexander-Universität Erlangen-Nürnberg. Erlangen 2015. [online]

- Minimum Standards for Electronic Editions. Hg. von der Association for Documentary Editing. University of South Carolina. Columbia, SC. Oktober 2002. [online]

- Networked Infrastructure for Nineteenth-Century Electronic Scholarship (NINES): Peer Review. University of Virginia. Charlotteville 2008. [online]

- Sarah L. Pfannenschmidt / Tanya E. Clement: Evaluating Digital Scholarship: Suggestions and Strategies for the Text Encoding Initiative. DOI: 10.4000/jtei.949 In: Journal of the Text Encoding Initiative 7 (2014). [online]

- Elena Pierazzo: Digital Scholarly Editing: Theories, Models and Methods. Farnham 2015. [Nachweis im GVK]

- Todd Presner: How to Evaluate Digital Scholarship. [online] In: Journal of Digital Humanities 1 (2012), H. 4. [online]

- Profession (2011). Hg. von Rosemary G. Feal. Kapitel: Evaluating Digital Scholarship. In: Profession. Hg. von Modern Language Association of America. S. 152–168. New York 1977-. ISSN 0740-6959. [online] [Nachweis im GVK]

- Qualitätskriterien für elektronische Quelleneditionen. Hg. von Porta Historica. A network of scholars and institutions editing historical sources. Huygens Institute for the History of the Netherlands. The Hague 2008. [online]

- Reviews in History. Covering books and digital resources across all fields of history. Hg. von Lawrence Goldman. Institute of Historical Research, University of London. London 1996-. ISSN 1749-8155. DOI: 10.14296/RiH//issn.1749.8155

- ride. A review journal for digital editions and resources. Hg. vom Institut für Dokumentologie und Editorik (IDE). 2014-. ISSN 2363-4952. [online]

- Peter Robinson: Towards a Theory of Digital Editions. In: Variants 10 (2013), S. 105–131. [Nachweis im GVK]

- Geoffrey Rockwell: Short guide to evaluation of digital work. [online] In: Journal of Digital Humanities 1 (2012), H. 4. [online]

- Geoffrey Rockwell: On the Evaluation of Digital Media as Scholarship. DOI: 10.1632/prof.2011.2011.1.152 In: Profession (2011), S. 152–168. [online]

- Patrick Sahle: A Catalog of Digital Scholarly Editions. Version 3.0 vom 22.03.2017. 2008-. [online]

- Patrick Sahle: Digitale Editionsformen. Zum Umgang mit der Überlieferung unter den Bedingungen des Medienwandels. Teil 2: Befunde, Theorie und Methodik. Norderstedt 2013. (= Schriften des Instituts für Dokumentologie und Editorik, 8) [Nachweis im GVK]

- Patrick Sahle, unter Mitarbeit von Georg Vogeler und den Mitgliedern des IDE: Kriterien für die Besprechung digitaler Editionen, Version 1.1 von Juni 2014. [online]

- Susan Schreibman / Laura Mandell / Stephen Olsen: Evaluating Digital Scholarship. Introduction. DOI: 10.1632/prof.2011.2011.1.123 In: Profession (2011), S. 123–135. [online]

- Thomas Stäcker / Baum, Constanze / Timo Steyer / Michael Kleineberg / Anne Baillot / Ben Kaden / Esther Chen / Niels-Oliver Walkowski / Christian Schwaderer / Thomas Ernst: Digitales Publizieren. Bedingungen – Optionen – Empfehlungen. [online] In: Modellierung, Vernetzung, Visulisierung. Die Digital Humanities als fächerübergreifendes Forschungsparadigma. Dhd 2016 Konferenzabstacts. (DHd 2016: 3, Leipzig, 7.-12.3.2016). PDF. [online] [Nachweis im GVK]

- Kimberly Yates: Creating a Prize for the Best Digital Editions / Online Archives. Handle: 1807/43831 In: Scroll – Essays on the Design of Electronic Texts 1 (2008), H. 1. Handle: 1807/43803

Abbildungslegenden und -nachweise

- Abb. 1: Anzahl neuer digitaler wissenschaftlicher Editionen nach Jahren.

- Abb. 2: Gesamtzahl digitaler wissenschaftlicher Editionen nach Fachbereichen und Jahren.

- Abb. 3: Anteile digitaler wissenschaftlicher Editionen nach Art des edierten Materials.

- Abb. 4: Kriterienkatalog des Instituts für Dokumentologie und Editorik mit farblich hinterlegten Kriteriengruppen.

- Abb. 5: Kriterien zur Bewertung digitaler Editionen nach Yates mit farblich hinterlegten Kriteriengruppen.

- Abb. 6: Länge von Rezensionen in Seiten (Mittelwert).

- Abb. 7: Länge von Rezensionen in Seiten (Median).