DOI: 10.17175/sb004_002

Nachweis im OPAC der Herzog August Bibliothek: 1031308806

Erstveröffentlichung: 16.01.2019

Medienlizenzen: Medienrechte liegen bei den Autoren

Letzte Überprüfung aller Verweise: 16.01.2019

GND-Verschlagwortung: Maya-Schrift | Wörterbuch | Datenbank | Elektronische Publikation |

Empfohlene Zitierweise: Franziska Diehr, Sven Gronemeyer, Christian Prager, Elisabeth Wagner, Katja Diederichs, Maximilian Brodhun, Uwe Sikora: Modellierung von Entzifferungshypothesen in einem digitalen Zeichenkatalog für die Maya-Schrift. In: Die Modellierung des Zweifels – Schlüsselideen und -konzepte zur graphbasierten Modellierung von Unsicherheiten. Hg. von Andreas Kuczera / Thorsten Wübbena / Thomas Kollatz. Wolfenbüttel 2019. (= Zeitschrift für digitale Geisteswissenschaften / Sonderbände, 4) text/html Format. DOI: 10.17175/sb004_002

Abstract

Die einzigartigen Eigenschaften der Maya-Schrift stellen die Forschung vor besondere Herausforderungen, aus denen widersprüchliche und zweifelhafte Entzifferungshypothesen hervorgehen. Das Projekt ›Textdatenbank und Wörterbuch des Klassischen Maya‹ verfolgt das Ziel, ein maschinenlesbares Korpus aller Maya-Texte zu erstellen und anhand dessen ein Wörterbuch zu kompilieren. Zur Entzifferung der Schrift ist ein Inventar aller Hieroglyphen ein unverzichtbares Instrument. Dieser Beitrag schildert die Entwicklung des digitalen Zeichenkatalogs unter besonderer Berücksichtigung der Modellierung von Entzifferungshypothesen und deren qualitative Bewertung. Weiterhin thematisiert der Beitrag die Rolle der Wissensrepräsentation in Digital Humanities-Projekten.

The unique characteristics of Maya writing pose special challenges for research, from which contradictory and doubtful deciphering hypotheses emerge. The project ›Text Database and Dictionary of Classic Mayan‹ aims at creating a machine-readable corpus of all Maya texts and compiling a dictionary on this basis. An inventory of all hieroglyphs is an indispensable instrument for further decipherment. This paper describes the development of the digital Sign Catalogue with special consideration of the modelling of decipherment hypotheses and their qualitative evaluation. Furthermore, the article emphasises the role of knowledge representation in Digital Humanities projects.

- 1. Modellierung des Zweifels im Maya-Wörterbuch-Projekt

- 2. Charakteristika der Mayaschrift

- 3. Zeichenkataloge als Klassifikationsinstrumente

- 4. Modellierung des digitalen Zeichenkatalogs

- 4.1 Analyse domänen-spezifischer Anforderungen

- 4.2 Wissensrepräsentation mittels konzeptioneller Modellierung

- 4.3 Konstruktion eines maschinenlesbaren Modells

- 5. Entwicklung eines Systems zur qualitativen Bewertung von Entzifferungshypothesen

- 5.1 Entstehung und Plausibilität von Lesungshypothesen

- 5.2 Definition von Aussagelogiken zur Bestimmung eines Konfidenzlevels

- 6. Techniken zur Erzeugung eines maschinenlesbaren Textkorpus

- 7. Auf dem Weg zum Wörterbuch: linguistische Analyse des Textkorpus

- 8. Erforschung der Schrift anhand des Zeichenkatalogs

- 8.1 Ikonizität

- 8.2 Graphemrelationen

- 8.3 Zeichenrelationen

- 8.4 Einbindung forschungsgeschichtlicher Ergebnisse

- 9. Veröffentlichung der Daten und Möglichkeiten der Nachnutzung

- 10. Fazit: Modellierung als Forschungsmethode der Digitalen Geisteswissenschaften

- Bibliographische Angaben

- Abbildungslegenden und -nachweise

1. Modellierung des Zweifels im Maya-Wörterbuch-Projekt

Die noch nicht vollständig entzifferte Schrift der vorspanischen Kultur der Maya ist Forschungsgegenstand des Akademievorhabens ›Textdatenbank und Wörterbuch des Klassischen Maya‹. Projektziele sind die Erschließung der bislang rund 10.000 bekannten Texte und ihrer Schriftträger in einem maschinenlesbaren Korpus und die Kompilation eines darauf aufbauenden Wörterbuchs, das den gesamten Sprachschatz und dessen Verwendung in der Schrift abbildet.[1] Gefördert wird das bis voraussichtlich 2028 angelegte Langzeitvorhaben von der Nordrhein-Westfälischen Akademie der Wissenschaften und der Künste sowie der Union der deutschen Akademien der Wissenschaften. Die an der Universität Bonn angesiedelte Arbeitsstelle kooperiert mit der Niedersächsischen Staats- und Universitätsbibliothek Göttingen. Seit 2014 werden in interdisziplinärer Zusammenarbeit die Hieroglyphentexte mit geisteswissenschaftlichen Methoden und informationstechnologischen Werkzeugen aufbereitet, ausgewertet und interpretiert.[2]

Ein Ergebnis dieser Zusammenarbeit und gleichzeitig auch bedeutender Meilenstein des Projekts ist der digitale Zeichenkatalog, dem sich der vorliegende Beitrag widmet. Für die Erstellung des Textkorpus und des Wörterbuchs einer nicht entzifferten Sprache ist ein Zeichenkatalog, ein Inventar aller verwendeten Schriftzeichen, ein unverzichtbares Instrument. Gleichzeitig bildet der Katalog auch die Kernkomponente zur Generierung eines maschinenlesbaren Texts. Das Projekt beschäftigt sich mit einer nur teilweise entzifferten Schrift, deren Erforschung bisher zahlreiche Vermutungen und Interpretationen über Lesung der Schriftzeichen hervorbrachte. Für eine heuristische Entzifferungsarbeit sind diese Lesungshypothesen bei Untersuchung der Schrift einzubeziehen. Bei der Entwicklung des Zeichenkatalogs entstand ein System zur qualitativen Bewertung von Entzifferungshypothesen und Lesungsvorschlägen, welches unter anderem Hilfestellung bei der linguistischen Analyse der Texte bietet (siehe Abschnitt 5). Die Herausforderung bei der Modellierung dieses Systems bestand darin, sowohl mehrere Lesungsvorschläge abzubilden als auch jene Faktoren zu bestimmen, die zur Formulierung der jeweiligen Entzifferungshypothese geführt haben. Ziel der Wissensrepräsentation ist auch die explizite Beschreibung der dabei angewandten Methoden. Dies ermöglicht dem Wissenschaftler anhand des Modells Analysen durchzuführen und Schlussfolgerungen zu ziehen.

Die Modellierung unsicherer Entzifferungen und deren Bewertung fungieren als konkrete Beispiele für die Repräsentation komplexer Wissensobjekte mit interpretatorischem Charakter, wie sie typisch für geisteswissenschaftliche Forschungsdaten sind. In diesem Zusammenhang hebt der Beitrag insbesondere auf die Rolle der Wissensrepräsentation in Vorhaben ab, die sich in den digitalen Geisteswissenschaften verorten und berücksichtigt dabei vor allem die Herausforderungen, die sich bei der Modellierung von vagen und unsicheren Informationen stellen.

Um die Schwierigkeiten aufzuzeigen, die sich bei der Entwicklung eines digitalen Zeichenkatalogs für Maya-Schriftzeichen ergeben, beschreibt der folgende Abschnitt den Aufbau und die Charakteristika des Schriftsystems. Anschließend setzen wir uns mit den bisher publizierten Zeichenkatalogen als forschungsgeschichtliche Quellen auseinander und eruieren dabei insbesondere die Probleme, die sich in der Vergangenheit bei der Zeichenklassifikation stellten. Der vierte Teil widmet sich der Entwicklung des Zeichenkatalogs. Die jeweiligen Unterabschnitte beschreiben die einzelnen Schritte des Modellierungsprozesses. Dabei werden Konzepte und Methoden der Wissensrepräsentation definiert und deren Anwendung geschildert. Im Zusammenhang mit der Modellierung unsicherer Lesungen schließt Abschnitt Fünf in der Beschreibung des Systems zur qualitativen Bewertung von Entzifferungshypothesen an. Während der sechste Teil die genutzten Techniken aufzeigt, um mittels Zeichenkatalog und TEI-Kodierung ein maschinenlesbares Korpus zu erzeugen, schließt sich der siebte mit der linguistischen Analyse des Texts an und zeichnet den Weg zum Wörterbuch des Klassischen Maya. Weitere Features des Zeichenkatalogs, welche die Untersuchungen zum Schriftsystem unterstützen, werden in Abschnitt Acht vorgestellt. Im vorletzten Abschnitt geben wir Informationen rund um die Möglichkeiten der Nachnutzung der Daten und Forschungsergebnisse. Im Fazit erläutern wir anhand des Zeichenkatalogs wie Modellierung als eine Forschungsmethode der Digital Humanities den Umgang mit Unsicherheiten und Vagheiten in geisteswissenschaftlichen Forschungsdaten ermöglicht.

2. Charakteristika der Mayaschrift

Im Vergleich zu den anderen mesoamerikanischen Schriftsystemen wie Isthmisch oder Aztekisch weist die Mayaschrift einen überdurchschnittlich langen Anwendungszeitraum von rund 2000 Jahren auf. Erste präklassische Textzeugen entstanden bereits im 3. Jh. v. Chr. Ihren schöpferischen Höhepunkt erreichte die Schrifttradition in der Klassischen Periode (100–810 n. Chr.). Durch die Ankunft der spanischen Konquistadoren erfuhren die Maya einen tiefen Einschnitt in ihrer Kultur, was auch die Verwendung ihrer Schrift betraf. So war es ihnen nur noch möglich, ihre Schrift im Verborgenen zu gebrauchen. Im Untergrund schrieben sie noch bis in das späte 17. Jh. weiter, danach bricht die Verwendung der Maya-Schrift vollständig ab und wurde nicht weiter aktiv gepflegt.

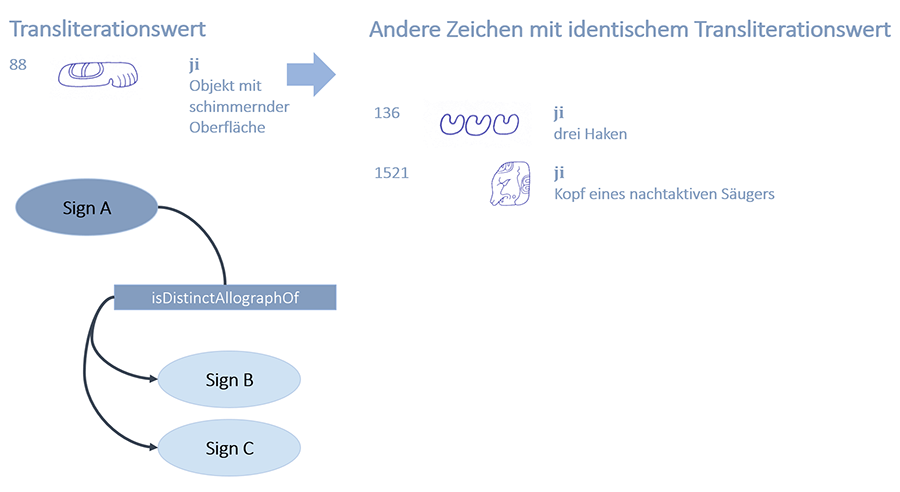

Erst die Entdecker und Gelehrten des 18. und insbesondere des 19. Jh. brachten die Maya-Texte wieder ans Licht, wodurch sie immer weiter in den Fokus der Forschung rückten. Bis heute haben sich schätzungsweise 10.000 Textträger erhalten (Abbildung 1), vor allem Monumentalinschriften, die an Gebäuden und auf Steinmonumenten wie Altäre und Stelen angebracht wurden. Auch auf Keramiken und Kleinartefakten wie Schmuck und Alltagsgegenstände sind zahlreiche Texte zu finden. Eine Besonderheit stellen die auf papierähnlichem Material geschriebenen Handschriften dar, von denen leider nur drei einwandfrei als authentisch geltende Exemplare überliefert wurden. Eine vierte, deren Echtheit bisher umstritten war, ist erst jüngst als authentisch bestätigt worden.

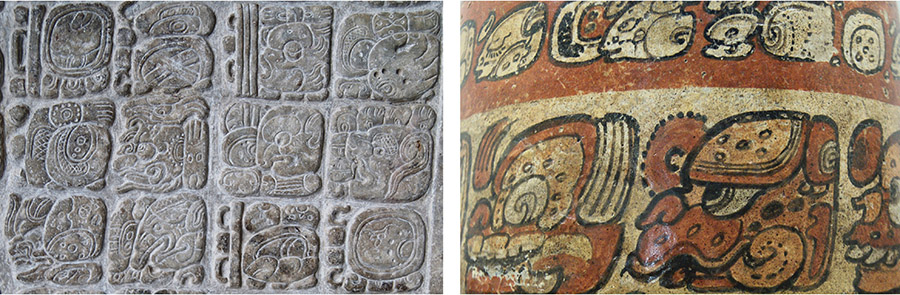

Das Schriftsystem des Klassischen Maya zeichnet sich durch einen ikonischen Charakter aus, weshalb es auch als Hieroglyphenschrift bezeichnet wird. Typologisch handelt es sich um ein logo-syllabisches System, das durch die zwei grundsätzlichen Zeichenklassen der Logo- und Syllabogramme gekennzeichnet ist. Logogramme stehen für konkrete sprachliche Begriffe, wie z.B. PAKAL das Wort für ›Schild‹, und verweisen dabei, mit nur wenigen Ausnahmen, immer nur auf ein Denotat. Vokal- und Silbenzeichen repräsentieren zum einen Silbenkomponenten und dienen zum anderen zur Schreibung lexikalischer und grammatischer Morpheme. Sie werden aber auch als phonetische Komplemente von Logogrammen verwendet, wie in PAKAL-la. Dies ermöglichte es, Wörter ausschließlich mit Logogrammen oder Silbenzeichen (pa-ka-la) zu schreiben, meist wurde aber beides miteinander kombiniert (Abbildung 2).[3]

Die Zeichen wurden derart angeordnet, dass sie nahezu rechteckige Blöcke bildeten. Dabei entspricht ein solcher Hieroglyphenblock wahrscheinlich der emischen Vorstellung eines Wortes. Innerhalb eines Blocks konnten die Graphe auf verschiedenste Weise arrangiert werden: Je nach Platzbedarf und Ästhetik konnten sie miteinander verschmelzen, sich überlappen, infigiert oder gedreht werden. Die Blöcke wurden in der Regel in Doppelkolumnen angeordnet und von links nach rechts und von oben nach unten gelesen. Die so konstruierten Sätze fügen sich zu komplexen Texten zusammen, deren Syntax und Struktur jener der modernen Maya-Sprachen ähneln.[4]

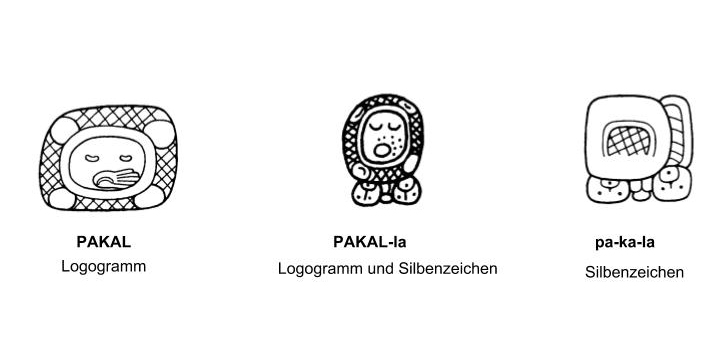

Die Inschriften weisen eine ausgeprägte kalligraphische Komplexität auf, die vor allem durch die Variation der Schreibung von Schriftzeichen entsteht. Dies erlaubte den Schreibern, Texte ästhetisch anspruchsvoll und ohne die Wiederholung von Zeichen zu verfassen. Für einen sprachlichen Ausdruck gibt es nicht nur eine eindeutige graphische Entsprechung, sondern meist mehrere, auch sehr unterschiedliche, Schreibvarianten. Das Syllabogramm u konnte entweder in seiner Vollform gebraucht werden oder alternativ nur jeweils eins seiner beiden Segmente. Die Segmente konnten aber auch reduziert oder multipliziert dargestellt werden. Als weiteres Beispiel zeigt das Silbenzeichen yi wie einfache Formen zu sogenannten Kopfvarianten transformieren. Selbst die diagnostischen Merkmale (in Abbildung 3 markiert) sind nicht in allen Graphvarianten vorhanden. Es war sogar möglich, andere Graphe einzuschieben bzw. zu umklammern, wie das Beispiel ma zeigt (Abbildung 3).

Die Art und Weise wie Varianten gebildet werden und somit die Komplexität der Mayaschrift erst ermöglicht wurde, war bisher nicht Gegenstand systematischer Untersuchungen. Es existieren einige wenige Einzelstudien,[5] die etwa Substitutionen, Rotationsprinzipien oder Symmetrien untersuchen. Wir konnten im Rahmen der Vorarbeiten für den digitalen Zeichenkatalog erstmalig erkennen, dass es allgemeingültige Regeln und Prinzipien für die Bildung von Graphen gibt, die sich über graphotaktische Analysen ableiten und definieren ließen.[6] Insgesamt haben wir 45 einzelne Variationsmöglichkeiten identifiziert, die sich in neun Klassen einteilen lassen (Mono-, Bi-, Tri-, & Variopartite, Division, Animation Head, Animation Figure, Multiplication, Extraction).

Eine weitere Besonderheit der Schrift und Sprache ist die Polyvalenz von Zeichen. Gleich aussehende Glyphen können sowohl als Logogramme oder als Silbenzeichen gelesen werden. Das Zeichen 528 kann als Logogramm TUN (›Stein‹) und CHAHUK (Name des 19. Tags im Maya-Kalender) oder als Silbe ku verwendet werden. Die verwendete Graphvariante gibt dabei keinen Hinweis darauf, welche der Lesungen vorliegt.

Dies verdeutlicht eindrucksvoll, wie frei die Maya-Schreiber bei der Gestaltung ihrer Texte waren und erklärt auch die Herausforderungen, die sich bei der Entzifferung der Schrift stellen, die bis heute noch nicht vollständig entschlüsselt werden konnte. Insbesondere die Variation der Graphe in synchroner wie diachroner Hinsicht macht die Bestimmung des Zeichengraphems und seiner Zuordnung zu einem sprachlichen Ausdruck schwierig. Bis heute konnte die genaue Anzahl von Zeichen und ihren Variationen nicht genau bestimmt werden. Eine Durchsicht publizierter Zeicheninventare weist zwischen 700 bis 1000 sprachlicher Zeichen aus, denen nach eigener Schätzung etwa 3000 Graphe zugeordnet werden können.

3. Zeichenkataloge als Klassifikationsinstrumente

Die Erforschung der Schrift erfolgt auf Grundlage bisher entdeckter Textträger. Viele Textzeugen wurden jedoch im Laufe der Zeit zerstört, sind in Depots von Archiven und Museen verschollen, in Privatsammlungen verborgen oder wurden schlicht noch nicht entdeckt. Es wird also zum einen immer eine geringe Zahl an Zeichen geben, die nicht inventarisiert sind. Zum anderen ist davon auszugehen, dass es in den kommenden Jahren zu weiteren Neuentdeckungen kommen wird. So wurden Anfang 2018 die Ergebnisse einer großangelegten Lidar-Prospektion (Lidar: Light detection and ranging) in Guatemala vorgestellt, die eine wesentlich dichtere Besiedlung im tropischen Tiefland aufzeigen als bislang angenommen,[7] was auch eine größere Anzahl an Textträgern impliziert.

Die Neuentdeckung von Inschriften und damit auch der Fund bisher unbekannter Zeichen stellt eine Herausforderung für die Klassifikation der Maya-Schriftzeichen dar. Bisherige Zeicheninventare konnten selbstverständlich immer nur die zur jeweiligen Zeit bekannten Zeichen für den Aufbau ihrer Kataloge berücksichtigen.

In unserem digitalen Zeichenkatalog wollen wir den Fall der Neuentdeckung antizipieren und die damit einhergehende Neuklassifikation von Zeichen als mögliches Szenario berücksichtigen. Daher benötigen wir einen Datenverarbeitungsprozess, der flexibel neue Erkenntnisse einbinden und verarbeiten kann.

Die Erforschung der Maya-Schrift ist, verglichen mit der antiker Sprachen und Schriften, noch relativ jung. Trotz der bereits im späten 19. Jh. gewonnenen Erkenntnis, dass viele Texte mit kalendarischen Daten durchsetzt sind,[8] wurde den Texten ein historischer Charakter und damit eine sprachliche Grundlage abgesprochen.[9] Erst in den 1950er Jahren erkannte Juri Knorosow den logo-syllabischen Charakter der Mayaschrift[10] und konnte die ersten sprachlich abgesicherten Lesungen präsentieren. Bedauerlicherweise blieb seine Arbeit aufgrund des Eisernen Vorhangs noch längere Zeit von der Forschung unbeachtet, obwohl sie 1958 in englischer Übersetzung erschien.[11]

Der Hieroglyphenkatalog von J. Eric S. Thompson[12] enthält etliche Mehrfach- und Falschklassifikationen, aber er dient der Forschung noch heute als Standardreferenz zur Zeichenidentifikation und anschließenden Transliteration als Vorbereitung für die linguistische Untersuchung der Texte, auch wenn Thompson in Ablehnung von Knorosows Arbeiten keine Lesungen angab.[13] Insgesamt wurden bisher neun andere Zeicheninventare vorgelegt. Sie alle weisen fehlerhafte Zuordnungen auf. Besonders problematisch sind dabei die Mehrfachklassifikationen von Zeichen, bei denen mehrere Allographe eines Graphems als verschiedene Zeichen inventarisiert wurden.[14] Die Kataloge sind zumeist einfache Graphinventare. Erst mit Knorosows »Compendio Xcaret«, posthum 1999 herausgegeben,[15] wurden erstmals Lesungen mit den entsprechenden Graphemen verknüpft. Diese basieren allerdings auf dem Forschungsstand der 1960er. Selbst die beiden neuesten Kataloge[16] bilden Lesungen nur unreflektiert ab.

Mit unserem digitalen Zeichenkatalog wollen wir beide Expressionsebenen eines Schriftzeichens, die funktional-sprachliche und die graphemische, berücksichtigen und so modellieren, dass die Zuordnung beider Ebenen zueinander feingranular und flexibel ist.

Ein weiterer Nachteil traditioneller Zeichenkataloge ist, dass sie durch ihre gedruckte Fassung unveränderbar und somit nicht dynamisch erweiterbar sind. Dies verhindert, dass Fehlklassifikationen korrigiert werden oder neue Relationen zwischen Zeichen etabliert werden können. Auch hier kann ein Zeichenkatalog in digitaler Form Abhilfe schaffen, indem er flexibel auf Änderungen reagieren kann und dabei gleichzeitig persistente Identifikationsmöglichkeiten bietet.

4. Modellierung des digitalen Zeichenkatalogs

Wir entwickeln den digitalen Zeichenkatalog mit dem Ziel, eine vollständige Neuinventarisierung der Maya-Zeichen vorzunehmen und damit eine gesicherte Aussage über die Anzahl bisher bekannter Schriftzeichen zu treffen. Mit dem Zeichenkatalog etablieren wir ein neuartiges Konzept zur Systematisierung und Klassifikation von Schriftzeichen. Die spezifischen Charakteristika des komplexen Schriftsystems des Klassischen Maya werden im Modell explizit repräsentiert: Graphvarianten, multifunktionale Zeichen und multiple Transliterationswerte werden definiert und miteinander in Beziehung gesetzt. Ein besonderes Augenmerk liegt dabei auf den Lesungshypothesen, die im Katalog nicht nur dokumentiert, sondern auch objektiv bewertet und qualitativ eingestuft werden, so dass sie in aufbereiteter Form für spätere Analysen zur Verfügung stehen. Der Katalog dient nicht nur als Werkzeug zur Klassifikation und zur Erforschung der Schrift, weiterhin bildet er auch die Kernkomponente zur Erstellung des Inschriftenkorpus.

Zur Entwicklung eines digital vorgehaltenen Zeichenkatalogs müssen die Schriftzeichen und ihre Spezifika in einem maschinenlesbaren Modell abgebildet werden. Wir verstehen Modellierung als eine Methode der digitalen geisteswissenschaftlichen Forschung, die darauf abzielt, Objekte und das Wissen über sie in einem Datenmodell zu repräsentieren. Im Sinne von Sowa bedeutet dies, die Semantik von Wissensobjekten explizit zu machen und in ein Datenmodell zu übertragen.[17] Als ›Wissensobjekt‹ bezeichnen wir die epistemische Vorstellung von konkreten Entitäten, die sich in einem spezifischen Wissenszusammenhang konstituieren. Wissensobjekte existieren nicht von sich aus. Sie werden durch wissensgenerierende Prozesse erzeugt; sie formen sich aus den Aussagen, Analysen und Interpretationen über konkrete Entitäten, die Gegenstand des Erkenntnisinteresses sind. Als ›Domäne‹ bzw. ›Gegenstandsbereich‹ bezeichnen wir den spezifischen Wissenszusammenhang aus dem sich Fragestellungen an das Objekt ergeben.

Der Prozess der Modellierung von Wissensobjekten und des spezifischen Gegenstandsbereichs lässt sich in folgende Schritte untergliedern: (a) Analyse domänenspezifischer Anforderungen, (b) Wissensrepräsentation mittels konzeptioneller Modellierung und (c) Konstruktion eines maschinenlesbaren Modells.

4.1 Analyse domänen-spezifischer Anforderungen

Die Anforderungen an unseren Katalog für die Schriftzeichen des Klassischen Maya wurden mittels intensiven Wissensaustauschs und -transfers zwischen Domänenexperte und Modellierer ermittelt. Dabei wurden konkrete Bedarfe an das Modell, dessen Implementierung in einem Erfassungssystem sowie an die technische Umgebung eruiert. Zur Ermittlung der Anforderungen wurde ein Vorgehen gewählt, das sich an die Methode des Experteninterviews anlehnt. Laut Reinhold stellt diese »insbesondere im Kontext der Modellierung von Forschungsprozessen und Forschungsdaten in den Digital Humanities [...] eine adäquate Methode der Informationsbedarfsanalyse dar, da aufseiten der Forschenden ein hohes Maß an implizitem Wissen zu erwarten ist«.[18] Es sei dabei aber zu beachten, dass von Experten nur Wissen mitgeteilt wird, wenn der Fragende bereits eine hohe Expertise in dem jeweiligen Thema besitzt.[19] Der Prozess fordert damit ein hohes Maß an Einarbeitung in das Domänenwissen auf Seite des Modellierers, der in der Lage sein muss das jeweilige Fachgebiet und den betreffenden Gegenstandsbereich aus disziplinärer Sicht zu beschreiben.

Der Prozess der Anforderungsermittlung stellt den am stärksten interdisziplinär geprägten Bereich in der gemeinsamen Projektarbeit dar. Einer explorativ-hermeneutischen Arbeitsweise entsprechend, gingen wir dabei wie folgt vor: In einem ersten Schritt erfolgte eine Einarbeitung in die grundlegenden Konzepte des Gegenstandsbereichs, also der Linguistik und Sprachforschung. Dabei analysierten wir auch den Gegenstand, den Zeichenkatalog, auf seine Bedeutung als unverzichtbares Hilfsmittel für die Entzifferungsarbeit und seine projekt- und auch disziplinspezifische Funktion. Weiterhin erfolgte eine intensive Auseinandersetzung mit dem Aufbau des Schriftsystems des Klassischen Maya mit dem Ziel dessen Schriftzeichen und vor allem deren Funktion im Schriftsystem explizit im Modell zu repräsentieren.

Die dabei entstandenen Gesprächsprotokolle bildeten die Grundlage für einen Anforderungskatalog, der als Arbeitspapier dazu dient weitere Bedarfe zu ermitteln und vorhandene zu konkretisieren. Anhand dieses Katalogs wurden in einer Phase des intensiven und regelmäßigen Wissensaustauschs einzelne Konzepte besprochen und Fragen zur Funktionsweise der Zeichen und des Schriftsystems erörtert.

4.2 Wissensrepräsentation mittels konzeptioneller Modellierung

Nach unserer Überzeugung stellt der Prozess der Wissensrepräsentation eine hermeneutische Methode dar, die darauf abzielt, ein maschinenlesbares Modell zu konstruieren. Mittels der konzeptionellen Modellierung wird definiert was Sowa ›ontologische Kategorien‹ nennt. Sie bestimmen alles, was in einer Computeranwendung dargestellt werden kann.[20] Die Erstellung eines ontologischen Modells zielt darauf ab, Wissensobjekte, ihre Beziehung zueinander und zu ihrer Domäne explizit zu beschreiben. Die Definition dieser Kategorien ist besonders schwierig, wenn es um vage und unsichere Informationen geht: »any incompleteness, distortions, or restrictions in the framework of categories must inevitably limit the generality of every program and database that uses those categories«.[21] Da ›Wissen‹ über Objekte hinterfragt oder unterschiedlich interpretiert werden kann, ist es notwendig, die verschiedenen Wissensstände im Modell abzubilden, um solchen Verzerrungen entgegenzuwirken und die Wissensbasis genau im Sinne der definierten ontologischen Kategorien zu begrenzen.

Zunächst recherchierten wir in fachspezifischer Literatur und linguistischen Terminologien wie bspw. SIL Glossary of Linguistic Terms[22] nach Definitionen und Konzepten zur Beschreibung von Schriftsystemen und Schriftzeichen. Die Analyse dieses Materials ergab jedoch, dass die meisten Konzepte für unser Modell nicht anwendbar sind, da sie bereits zu stark die Anwendbarkeit in einem konkreten linguistischen Zusammenhang fokussieren. Unser Ziel ist es aber, ontologische Kategorien zur Repräsentation von Schriftzeichen und ihrer Funktion in einem Schriftsystemen zu definieren. Linguistische Kategorien sind dabei nur auf einer Metaebene anwendbar.[23]

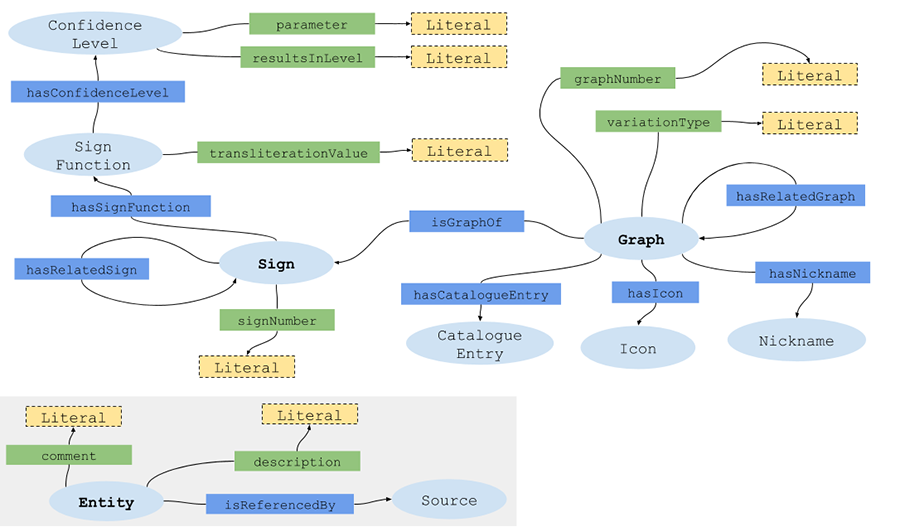

Auf der Literaturrecherche und den Ergebnissen der Anforderungsanalyse aufbauend, definierten wir Konzepte und modellierten deren Beziehungen zueinander und zum Gegenstandsbereich in einer Ontologie, die wir als OWL-Schema verfassten. Die Abbildung 4 zeigt das Domain-Model der Ontologie und veranschaulicht die Kernkonzepte und ihre Beziehungen zueinander.

In unserem Verständnis konstituiert sich ein Schriftzeichen aus der Vereinigung zweier Ebenen: einer sprachlich-funktionalen Ebene, die zum einen in Anlehnung an Ferdinand de Saussure[24] die Vorstellung und das Lautbild enthält und zum anderen die konkrete Funktion des Zeichens im Schriftsystem beschreibt, und einer Ebene der graphischen Repräsentation, die alle möglichen Darstellungsformen beinhaltet, welche das Konzept der sprachlich-funktionalen Ebene repräsentieren.

Betrachten wir als Beispiel ein Maya-Schriftzeichen: Es hat die sprachliche Expression yi und erfüllt damit die Funktion eines Silbenzeichens. Für das Syllabogramm yi existieren mindestens drei unterschiedliche graphische Repräsentationsformen (siehe Abbildung 3).

Diese Repräsentationsform bezeichnen wir als Graph.[25] Ein Graph ist eine abstrahierte, typisierte Form eines konkret realisierten Individuums eines Schriftzeichens. Das im Katalog erfasste Graph von yi in der Variation ›anthropomorphic head variant‹ stellt einen Typ dar, der alle individuellen Schreibvarianten und damit alle konkreten Vorkommen für yi in Form einer ›Kopfvariante‹ prototypisch abbildet.

Alle Graphe, die einer gemeinsamen sprachlichen Expression zugeordnet werden, stehen in einer allographen Beziehung zueinander und bilden in ihrer Gesamtheit Varianten des Graphems des Schriftzeichens.[26]

Ein Graph kann nur genau einer sprachlich-funktionalen Expression (idiomcat:Sign) zugeordnet werden. Diese Relation (idiomcat:isGraphOf) ist optional, so dass auch Graphe inventarisiert werden können, die bisher noch keinem ›Sign‹ zugeordnet werden konnten.

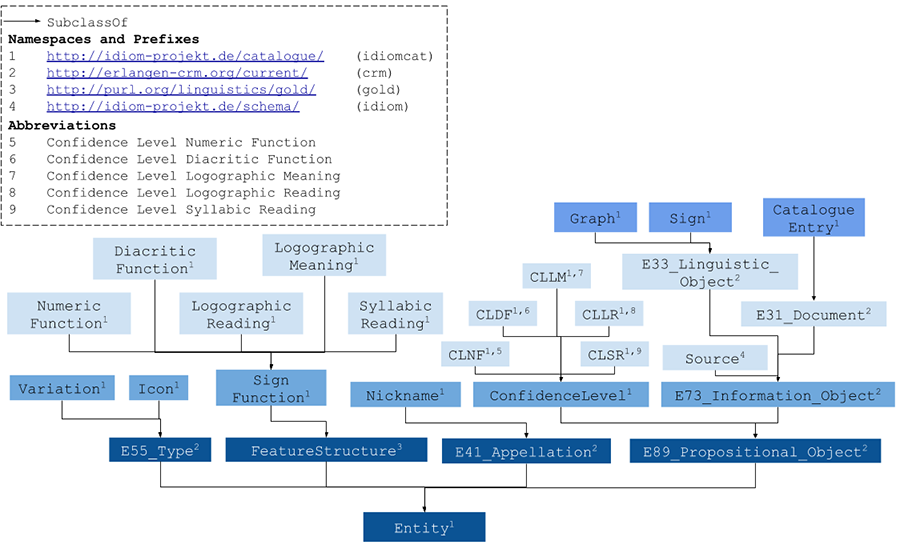

Die Funktion eines Zeichens innerhalb des Schriftsystems bezeichnen wir als Zeichenfunktion (idiomcat:SignFunction). Für das Klassische Maya konnten neben den beiden Hauptklassen Logogramm und Syllabogramm (idiomcat:SyllabicReading, siehe Abbildung 4) zwei weitere Funktionstypen identifiziert werden, da wir nach Rogers[27] auch Numerale (idiomcat:NumericFunction) und Diakritika (idiomcat:DiacriticFunction) einbeziehen. Logogramme werden in ihrer Funktion noch weiter unterteilt: Hier unterscheiden wir solche, die einen identifizierten Lautwert haben (idiomcat:LogographicReading) und jene, für die lediglich ein semantisches Feld eingegrenzt werden kann (idiomcat:LogographicMeaning). Zur Klassifikation von Schriftzeichen mag diese Unterscheidung irrelevant sein, da die Funktion des Zeichens für das Schriftsystem ein und dieselbe ist. Jedoch modellieren wir mit der Ontologie einen konkreten Anwendungsfall: Der Zeichenkatalog dient als Hilfsinstrument zur Entzifferung des Schriftsystems. Im Katalog dokumentieren wir auch Lesungshypothesen und bewerten diese qualitativ (idiomcat:ConfidenceLevel). Daher ist eine Differenzierung der Logogramme notwendig, weil jeweils unterschiedliche Bewertungskriterien (idiomcat:parameter) anzusetzen sind. Auch bei der linguistischen Analyse des Korpus ist es sinnvoll zwischen konkreten Lautwerten und einer Bedeutung zu unterscheiden. Der Lautwert bzw. die Bedeutung wird als Transliterationswert (idiomcat:transliterationValue) repräsentiert.

4.3 Konstruktion eines maschinenlesbaren Modells

Nachdem die Objekte definiert, ihre Strukturierung und Beziehungen zueinander in einem konzeptionellen Modell erfasst wurden, erfolgte die Entwicklung des Datenmodells. Konzepte und Strukturen werden in eine maschinenlesbare Form übertragen indem sie in einer entsprechenden Syntax formuliert werden, die sich zur Abbildung des konzeptionellen Modells eignet. Da der vorliegende Zeichenkatalog als Ontologie konzipiert wurde, wird eine Datenstruktur benötigt, die semantische Relationen zwischen eindeutig referenzierbaren Entitäten abbilden kann.

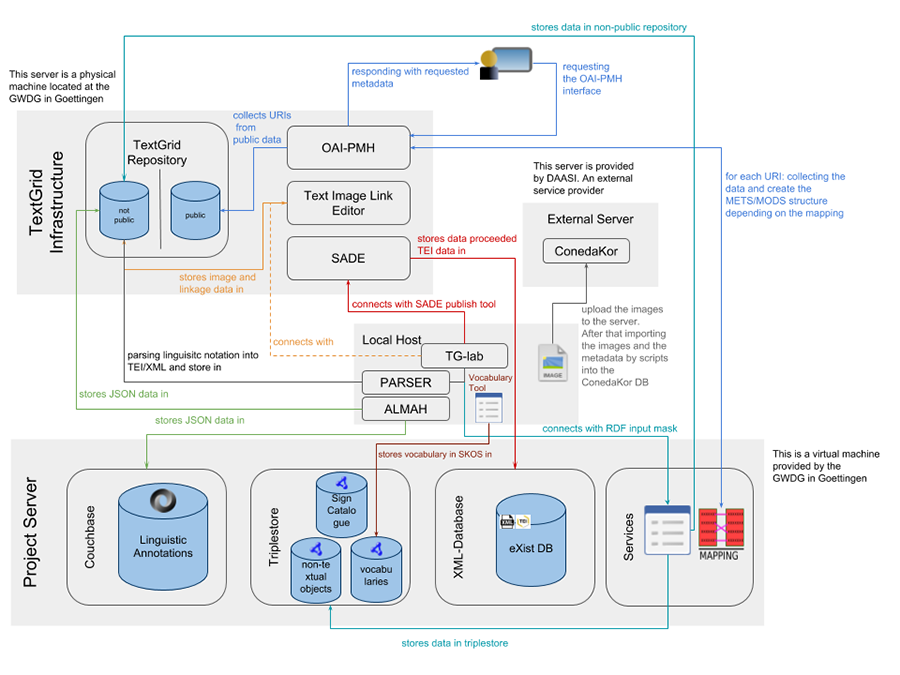

Für die Verwaltung, Erstellung und Präsentation der im Projekt erzeugten Daten nutzen wir die virtuelle Forschungsumgebung TextGrid.[28] Zur Datenerfassung nutzen wir die RDF-Eingabemaske des TextGrid-Labs nach, die wir an unsere projektspezifischen Bedürfnisse angepasst haben. Die Maske rendert anhand eines in Turtle-Syntax hinterlegten RDF-Schemas HTML-Formulare, die zur Erfassung der Daten dienen. Um die Eingabemaske für den Zeichenkatalog nutzbar zu machen, muss das als Ontologie konzipierte Modell in ein RDF-Schema übertragen werden. Während die in OWL repräsentierte Ontologie vor allem zur Dokumentation des konzeptionellen Modells dient, stellt das RDF-Schema die Maschinenlesbarkeit her.

Dies veranschaulicht, dass bei der Datenmodellierung oft auch pragmatische Entscheidungen getroffen werden müssen. Da die Funktionsweise der Eingabemaske auf ein RDF-Schema in Turtle-Syntax ausgerichtet ist, war es nicht möglich die in OWL verfasste Ontologie direkt zu nutzen. Im vorliegenden Fall ist dies jedoch unproblematisch, da das in OWL verfasste Schema verlustfrei in ein RDF-Schema übertragen werden konnte. Die erzeugten Daten werden in einem Triple Store gespeichert. Die Triple-Struktur repräsentiert die Komplexität der ontologischen Beziehungen, die im konzeptionellen Modell definiert wurden. Mittels der Query Language SPARQL sind dementsprechend anspruchsvolle Abfragen möglich.

Neben dem Ziel die Wissensobjekte und den Gegenstandsbereich maschinenlesbar abzubilden, spielt die Herstellung von Interoperabilität zu anderen Systemen und Schemata eine wichtige Rolle bei der Entwicklung von Datenmodellen. Die Übernahme bereits definierter Konzepte ermöglicht die Ausschöpfung des Potenzials vorhandener Metadatenstandards: Ihre Integration verbessert die Auffindbarkeit von Ontologien und erhöht sowohl deren Qualität, als auch die der darauf zugreifenden Anwendungen, da die Wissensbasis kontinuierlich angereichert wird.[29] Für die Nachnutzung und Integration von Ontologien benennt Simperl folgende Schritte: (1) Recherche nach nachnutzbaren Ontologien, (2) integrationsorientierte Evaluation und (3) Integration der Ontologien in das eigene Modell.[30]

Die Auffindbarkeitschancen bereits existierender Ontologien sind dann gering, wenn es sich um fachspezifische Schemata handelt, die häufig nur in den jeweiligen Domänen bekannt sind. Die dort entwickelten Ontologien sind naturgemäß sehr spezifisch und auf einen konkreten Anwendungsfall ausgerichtet, was ihre unmittelbare Nachnutzung und die Integration von Konzepten erschwert.[31] Daher ist es sinnvoll, neben fachspezifischen Ontologien, auch sogenannte Top-Level-Ontologien nachzunutzen. Letztere ermöglichen die Verständigung über allgemeingültige Konzepte, die dementsprechend im eigenen Schema nicht neu definiert werden müssen.[32]

Bei der Recherche nach nachnutzbaren Ontologien für das Zeichenkatalog-Schema fanden wir u.a. die General Ontology for Linguistic Description (GOLD). Mit dem Ziel grundlegende Kategorien und Relationen für die wissenschaftliche Beschreibung von menschlicher Sprache zu definieren, schien GOLD für unsere Zwecke nachnutzbar zu sein. Bei der integrationsorierentierten Evaluation stellte sich heraus, dass GOLD den Fokus auf grammatikalische Regeln mit der Betrachtung der Morphosyntax als Ausgangspunkt legt.[33] In unserem Kontext konnten die in GOLD definierten Konzepte nur eingeschränkt genutzt werden, da unser Konzept eine Metaebene abbildet, die zur Organisation von Schriftzeichen dient.

Dennoch boten einige Konzepte einen guten Anhaltspunkt für die Definition unseres Schemas. Mit der Definition von gold:FeatureStructure als »a kind of information structure, a container or data structure, used to group together qualities or features of some object«[34] ist das Konzept so allgemein gehalten, dass sich unsere Definition von idiomcat:SignFunction als »a feature assessed to a Sign. The nature of the feature is specified by the subclasses«[35] als Subklasse fassen lässt.

Die Evaluation geeigneter Top-Level-Ontologien zeigte, dass das CIDOC Conceptual Reference Model (CIDOC CRM) trotz dessen Fokus‘ auf die Beschreibung von Prozessen zur Dokumentation von Objekten des kulturellen Erbes viele Metakonzepte beinhaltet, die für den Aufbau unseres Katalogs geeignet sind. Die Klassenhierarchie des Zeichenkatalog-Datenmodells zeigt, dass die meisten Klassen unseres Schemas als Subklassen des CIDOC CRM definiert wurden (Abbildung 5). Als »identifiable expressions in natural language« wurden Sign und Graph als spezifische Subkonzepte von crm:E33_Linguistic_Object gefasst.[36]

5. Entwicklung eines Systems zur qualitativen Bewertung von

Entzifferungshypothesen

In unserem Zeichenkatalog wollen wir publizierte wie auch eigene Lesungshypothesen berücksichtigen, vor allem da die Lesungen für die linguistische Analyse des Textkorpus zur Erstellung des Wörterbuchs verwendet werden.

Auch wenn die Forschung mit fehlerbehafteten Katalogen arbeitet, konnte die Entzifferung der Maya-Schrift in den vergangenen Jahrzehnten deutlich vorangetrieben werden. So legte insbesondere David Stuart in den 1980er Jahren eine bedeutende Studie mit Entzifferungen vor,[37] die dem Prozess neue Impulse brachte. Doch es herrscht keinesfalls Einigkeit über die Lesung aller Zeichen. Die Gründe, warum Zeichen nicht gleichermaßen entziffert sind, können vielfältig sein, wenn etwa ein Zeichen nur ein einziges Mal attestiert ist, oder keine Indikatoren vorliegen, die auf die Phonemik hindeuten. Da Entzifferungen bisher meist an isolierten Beispielen in ›handverlesenen‹ Texten durch den einzelnen Epigraphiker vorgenommen wurden, wurden sie bisher nie anhand eines umfassenden Textkorpus überprüft und abgeglichen, da dieser bisher nicht besteht und erst durch das Projekt ›Textdatenbank und Wörterbuch des Klassischen Maya‹ aufgebaut wird. Nicht nur aus diesen Gründen wurden und werden für etliche Schriftzeichen unterschiedliche Lesungshypothesen vorgelegt. Individuelle Interpretationen des Kontexts oder linguistische Grundlagen tragen ebenso hierzu bei.

5.1 Entstehung und Plausibilität von Lesungshypothesen

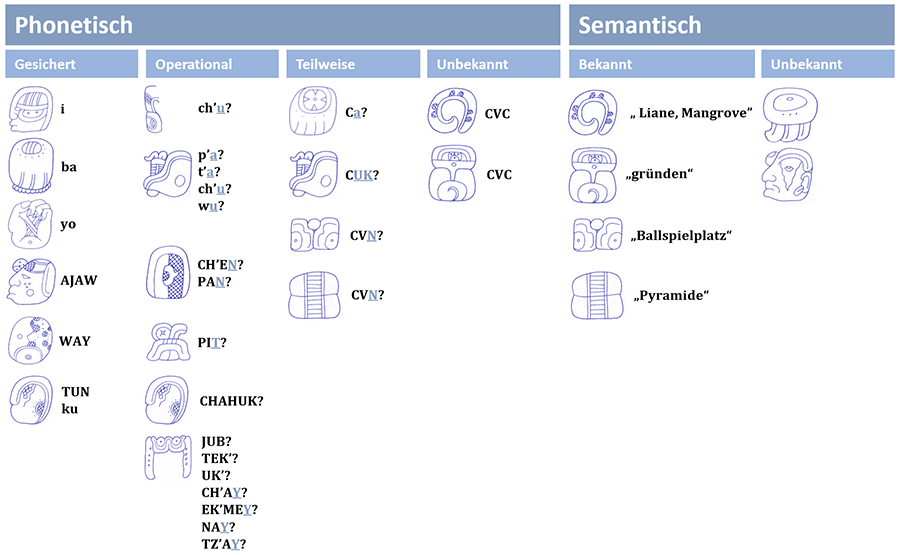

Grammatologisch können verschiedene Kategorien von Entzifferungen definiert werden, die sprachlich und semantisch sind, erweitert nach der Zeichenfunktion bei Riese[38] und Entzifferungskriterien bei Houston.[39] Der Lautgehalt von sprachlich gesicherten Zeichen kann in einer Reihe von Kontexten verifiziert werden, häufig mit semantischer und lexikalischer Übereinstimmung bei Morphographen, teilweise auch mit polyvalenten Lesungen. Bei operationalen Lesungen kann aufgrund bestimmter Indizien auf den Lautwert geschlossen werden, etwa durch vokalharmonische Regeln, phonemische Komplemente oder das semantische Feld. Allerdings können hier auch multiple Lesungsvorschläge auftreten, die keine Polyvalenz aufweisen und eine unterschiedliche Plausibilität haben, basierend auf der individuellen Interpretation des Kontexts oder der Kenntnis des Materials in Ermangelung eines Korpus. Teilweise können aufgrund fehlender Indizien auch nur Teile des Lautgehalts isoliert werden, etwa der Auslaut durch Komplemente. Von nur teilweise oder gar nicht lesbaren Zeichen kann aber oftmals die Semantik und fast immer die Wortklasse eingegrenzt werden, entweder aufgrund des Kontexts oder auch der Ikonizität des Graphs. Etwa ein Drittel des Zeicheninventars widersetzt sich bisher jeder vernünftigen Interpretation, meist sind dies Morphographe und unter diesen überwiegend Substantive.

5.2 Definition von Aussagelogiken zur Bestimmung eines

Konfidenzlevels

Da jede Zeichenfunktion eine unterschiedliche linguistische Funktion erfüllt, erfordert jede die Zusammenstellung eines eigenen Kriterien-Sets anhand derer eine Hypothese zur Entzifferung eines Zeichens überprüft werden kann. Beispielsweise kann ein Logogramm nicht in einer stammmedialen Position eines Wortes auftauchen, ein Silbenzeichen dagegen schon (Kriterium ›m‹). Die Bewertung einer Entzifferung geschieht qualitativ über die Verknüpfung bestimmter Kriterien in Aussagenlogiken, die in disjunkten numerischen Werten die Plausibilität anzeigen. Jede Zeichenfunktion hat eine unterschiedliche Anzahl an Plausibilitäten, und kommen durch neue Texte neue Vorkommen mit bisher nicht berücksichtigten Kriterien hinzu, können diese ergänzt werden, wodurch gegebenenfalls die Plausibilität um ein oder mehrere Level steigen kann.

Für die Silbenzeichen etwa sind folgende Kriterien definiert worden:

- d = Landa’s Manuscript

- l = Consonant in Landa’s Alphabet

- u = Vowel in Landa's Alphabet

- k = Complete logographic substitution

- t = Partial logographic substitution

- a = Allographic substitution

- o = Preposed to deciphered logogram

- c = Postposed to deciphered logogram

- f = Stem initial

- m = Stem medial

- g = Word medial

- r = Word final

- y = Ergative spellings

- s = Correspondence with image

- q = Correspondence with object

- b = Doubling is possible

- v = Vowel harmony

- i = Lexical correspondence with graph icon

Diese werden in vier Aussagenlogiken zur Festlegung von vier Plausibilitätsstufen kombiniert:

1 (excellent) = d ∨ u ∨ (k ∧ (s ∨ q)) ∧ (a ∧ (f ∨ m) ∧ (s ∨ q)) ∨ ((o ∨ f

∨ m ∨ y) ∧ (g ∨ r ∨ c) ∧ (s ∨ q))

2 (good) = ((t ∨ o ∨ c) ∧ v ∧ (s

∨ q)) ∨ (a ∨ o ∨ f ∨ m) ∧ (g ∨ r ∨ c)) ∨ (g ∨ r ∨ c) ∧ (s ∨ q)) ∨ (f ∨

m) ∧ (s ∨ q))

3 (partial) = t ∨ c ∨ l ∨ r ¬ v

4 (weak) = g ∨ m

∨ r

Die Kriterien und Aussagenlogiken wurden auch unter kritischer Betrachtung der bisherigen Entzifferungspraxis konzipiert. Mit einer Rechtfertigungsschrift für einen Inquisitionsprozess des Bischofs von Yucatan, Diego de Landa, haben wir tatsächlich eine zeitgenössische Beschreibung der Maya-Schrift[40] etwa aus dem Jahre 1566, auch wenn Landa von einem Alphabet ausging. Trotzdem finden sich im Manuskript Annotationen zu bestimmten Hieroglyphen mit einem syllabischen Wert, die dann den Schlüssel zur Entzifferung brachten. Und zu den Silbenzeichen gehören natürlich auch die Zeichen, die reine Vokale repräsentieren.

Schon vor Knorosow war bekannt, dass es in den erhaltenen Kodizes einen starken Text-Bild-Bezug gibt. So konnte Paul Schellhas strukturalistisch die Eigennamen verschiedener Götter isolieren.[41] Und dieser Bezug stellte sich auch als hilfreich bei der Kontrolle der Entzifferungen heraus, so wie sie durch Knorosow den Anfang nahmen.[42] Unter den Belegen mit einer syllabischen Annotation im Landa-Manuskript finden sich auch <cu> und <ku> (ku und k’u in heutiger Transliteration). Diese Beispiele sind also nur durch das Kriterium ›d‹ entziffert, da sie durch einen Zeitzeugen belegt sind, weitere Kriterien wären ausschließlich komplementär.

Beide Zeichen finden sich in initialer Position (Kriterium ›f‹) in Hieroglyphenblöcken, die Tiere benennen, die in der entsprechenden Vignette ebenfalls abgebildet sind: ein Truthahn und ein Geier (Abbildung 7). Ein Abgleich mit kolonialzeitlichen Wörterbüchern ergab die Bezeichnungen kutz bzw. k’uch für die beiden Tiere. Damit haben wir jeweils auch eine Hypothese zum Anlaut des jeweils zweiten Silbenzeichens (tzV und chV), ohne jedoch den Vokal zu kennen, denn beide Hieroglyphen sind nicht in Landas Liste vorhanden. Damit wäre das Kriterium ›r‹ erfüllt und Stufe 3 erreicht.

Das Silbenzeichen tzV taucht aber in initialer Wortposition bei der Abbildung eines Hundes auf, der in den Wörterbüchern als tzul belegt ist. Damit ist der syllabische Wert tzu bestätigt und das Zeichen steigt auf Stufe 2, wobei es in Verbindung mit der Vignette sogar in Stufe 1 (Kriterium ›s‹) aufrückt. Das zweite Zeichen ist somit lV; der Anlaut wird durch die Annotation <L> bei einem sehr ähnlichen Zeichen im Landa-Manuskript bestätigt. Die Beispiele haben bisher Vokalharmonie (KV1-KV1) gezeigt, so dass man als Hypothese die Lesung lu aufstellen kann, die mit den entsprechenden Kriterien auf Stufe 2 gestellt werden kann.

Das Zeichen taucht an anderer Stelle in einem Block in einer stammmedialen Schreibung auf. Aufgrund struktureller Analogien muss hier eine Zahl stehen, die aus der arithmetischen Struktur dieses Almanachs berechnet werden kann. Statt des entsprechenden Zahlzeichens »11« wurde hier also phonemisch bu-lu-ku für buluk geschrieben (wobei das zerstörte Silbenzeichen bu rekonstruiert wurde). Der angenommene Vokal kann also hier bestätigt werden und das Zeichen ist auf Stufe 1 entziffert.

6. Techniken zur Erzeugung eines maschinenlesbaren Textkorpus

Ein Ziel des Projekts ist es, ein maschinenlesbares Textkorpus aller Inschriften zu erstellen. Aufgrund der komplexen Graphemik, der Zeichenpolyvalenz und des geringen Entzifferungsstatus ist es jedoch nicht möglich den Text in phonemisch transliterierten Werten zu erfassen. Daher ist es auch wenig verwunderlich, dass derzeit kein standardisierter maschinenlesbarer Schriftsatz, wie etwa Unicode, für die Maya-Schrift vorhanden ist. Es gibt zwar Bestrebungen in diese Richtung, [43] diese genügen in ihrer jetzigen Ausführung aber nicht den klassifikatorischen Anforderungen der Maya-Schrift.

Für die Erstellung des Textkorpus möchten wir auf die jeweils konkret verwendeten Graphvarianten verweisen, um Untersuchungen zur Verwendung der Schrift in ihrer räumlich-zeitlichen Entwicklung und ihres Gebrauchs in Abhängigkeit vom Textträger, dessen Aufstellungsort sowie des Textinhalts durchzuführen.

Das Textkorpus kodieren wir in XML unter Benutzung der TEI-P5-Richtlinien.[44] Um die Struktur, die Anordnung der Glyphen zueinander und weitere inschriftenspezifische Phänomene auszuzeichnen, haben wir ein TEI-konformes, anwendungsspezifisches Schema erarbeitet. Statt phonemisch transliterierte Werte zu nutzen, verwenden wir Semantic-Web-Technologie um im XML-Dokument auf die in RDF gespeicherte Ressource zu verweisen. Im Zeichenkatalog ist jede Graphvariante als eigenständige Ressource erfasst und verfügt dadurch über einen URI. Im TEI-kodierten Text erfassen wir jede Glyphe mit dem Element <g> (character or glyph) und nutzen das Attribut @ref (»«) um auf den jeweiligen URI zu verweisen (Abbildung 8). Der Text selbst besteht somit aus externen Ressourcen und bildet zusammen mit dem Zeichenkatalog ein ontologisch-verlinktes System.

Mit dieser Vorgehensweise tragen wir auch der Anforderung Rechnung, verschiedene Entzifferungshypothesen zu berücksichtigen. Da im Textkorpus auf das Graph verwiesen wird, welches im digitalen Katalog potenziell mit mehreren möglichen Lesungsvorschlägen verbunden ist, besteht nun die Möglichkeit die Inschrift unter Berücksichtigung verschiedener Hypothesen zu analysieren. Ein weiterer Vorteil dieser Vorgehensweise ist, dass neue Entzifferungen flexibel eingebunden werden können. Auch im Falle neu formulierter, gesicherter Aussagen müssen diese nicht aufwändig in das Korpus eingearbeitet werden. Durch die Verwendung von URIs kann eindeutig auf die entsprechende Ressource im Zeichenkatalog referenziert werden. An der Kodierung des Korpustexts selbst ändert sich nichts, sie bleibt stabil.

7. Auf dem Weg zum Wörterbuch: linguistische Analyse des Textkorpus

Die linguistische Analyse der Texte ist kein Bestandteil des Korpus und wird durch ein separates Tool realisiert, einer weiteren Komponente unserer virtuellen Arbeitsumgebung (Abbildung 9).[45] Um einen ›lesbaren‹ Text aus dem in TEI kodierten und aus URI-Referenzen bestehenden Korpus zu generieren, ist ein weiterer Prozessierungsschritt notwendig. Dazu liest das Annotationsprogramm die XML-Dokumente ein und fragt die im Zeichenkatalog hinterlegten Transliterationswerte mittels API (Application Programming Interface) ab.

Zur Vorbereitung der linguistischen Analyse wird die Zeichennummer (idiomcat:signNumber, siehe Abbildung 4) als Grundlage einer numerischen Transliteration benutzt, und diese zunächst in eine graphematische Transliteration (idiomcat:transliterationValue) überführt, wofür die Nummer mit dem der Zeichenfunktion zugeordneten Transliterationswert ersetzt wird, z. B. 1.[[528.116]:713] in u.[[TUN.ni]:K’AL]. Dies kann wegen Polyvalenz nur semi-automatisch erfolgen, da kontextabhängig die Zeichenfunktion bzw. die korrekte Lesung eruiert werden muss. So kann Zeichen 528 hier nicht die Silbe ku (kein sinnvolles Wort) oder den Tagesnamen CHAHUK (keine Kalenderangabe) repräsentieren.

An dieser Stelle wird auch das Konfidenzlevel einer Lesungshypothese relevant. Jeder für ein Zeichen getroffene Entzifferungsvorschlag kann im Textkorpus in der Gesamtheit der Belege analysiert werden, ebenso kann jedes Kriterium überprüft werden. Im Idealfall ergeben sich dadurch neue Kriterien, welche die Plausibilität einer Hypothese steigern und vielleicht zu einer vollständigen Entzifferung führen.

Mit den Transliterationswerten kann nun auch in der folgenden graphemischen Transliteration auf Zeichentranspositionen reagiert werden, aus u.[[TUN.ni]:K’AL] wird nun u-K’AL-TUN-ni. Als kritisch für den weiteren Analyseverlauf ist die folgende phonemische Transliteration.

Hier werden die quasi als Container genutzten Transliterationswerte aus dem Zeichenkatalog kontextuell der korrekten sprachlichen Lesung angepasst. So besitzt das Zeichen 561 CHAN üblicherweise die Lesung chan - ›Himmel‹. Syllabische Substitutionen ka-na in Nordwest-Yucatan zeigen aber, dass das Zeichen dort in einem vernakularen Kontext káan ausgesprochen wurde. Der Einfluss lokaler Maya-Sprachen (relevant sind die drei Sprachfamilien Ch’olan, Yukatekan und Tzeltalan) auf die Schriftsprache ist noch nicht systematisch erforscht und mit Ergebnissen der historischen Linguistik abgeglichen worden, Einzelstudien weisen aber auf eine gewisse Permeabilität der Hochsprache hin.[46] Ab diesem Schritt ist auch die Zeichenfunktion nicht mehr von Bedeutung, sondern die Zeichenverwendung, also ob ein Zeichen zur Schreibung einer Wortwurzel, eines grammatikalischen Morphems oder als phonemisches Komplement gebraucht wird, was auch durch spezifische Operatoren ausgedrückt wird: u=k’al=tuunni.

Die Anlage paralleler Analysestränge ist aber nicht nur bei verschiedenen, zu überprüfenden Entzifferungsvorschlägen eine Notwendigkeit. Bestimmte unentzifferte Logogramme tauchen stets mit einem nachgestellten Silbenzeichen auf, bei dem nicht ganz klar ist, ob es ein phonemisches Komplement ist oder ob tatsächlich ein einzelnes Digraph vorliegt, das vielleicht eine andere Lautstruktur hat, als das phonemische Komplement anzeigen mag. Weiter können bestimmte Schreibungen aufgrund der Morphosyntax des Klassischen Maya auf mehr als eine Art analysiert werden. So kann der Krönungs-Ausdruck HUN-K’AL-ja tu-BAH als (1) k’al=huun=ja tu=baah > k’al-Ø+huun-[a]j-Ø t.u-baah oder (2) k’ahl=ja huun tu=baah > k’ahl-[a]j-Ø huun t.u-baah analysiert werden. Im ersten Fall finden wir ein inchoatives Kompositum mit Ellipse des Agens vor: ›es bekam Stirnband-gehalten an seinen Kopf‹, im zweiten Fall ist das Verb passiviert und huun ist das syntaktische Agens: ›es wurde gehalten das Stirnband an seinen Kopf‹. Derartige Fälle können im Korpus jeweils mit anderen syntaktisch ähnlichen Konstruktionen abgefragt und einer weiteren Studie unterzogen werden.

Durch die Verbindung von Zeichenkatalog, Textkorpus und linguistischer Analyse entsteht letztendlich ein dynamischer Text, der je nach Forschungsfrage individuell generiert werden kann. Dieser Ansatz der ontologischen Vernetzung der Komponenten dürfte auch für die Erforschung weiterer nicht entzifferter Schriften von Interesse sein.

Die analytische Annotation erfasst Wortwurzeln, Wortstämme und grammatikalische Morpheme. Damit wird bereits in der Analyse lemmatisiert und die Grundlage für eine semi-automatische Erstellung des Wörterbuches geschaffen, das damit auch alle Belegstellen eines Lemmas listen kann. Die bei der Analyse entstehenden Texte schaffen auch ein dynamisches Wörterbuch, etwa wenn neue Wortbedeutungen im Kontext isoliert werden.

8. Erforschung der Schrift anhand des Zeichenkatalogs

Der Zeichenkatalog ist nicht nur ein Repositorium der Zeichen und Graphe der Mayaschrift oder Hilfsmittel zur Kodierung des Textkorpus, sondern es werden auch weitreichende Informationen zur Ikonizität der Graphe erfasst. So wird der Zeichenkatalog selbst zu einer Infrastruktur für grammatologische Forschungsfragen.

8.1 Ikonizität

Wie andere hieroglyphische Schriftsysteme weist auch die Mayaschrift einen hohen Grad an Ikonizität auf. Diese wird im Zeichenkatalog durch das in SKOS[47] modellierte kontrollierte Vokabular ›Icon‹ abgebildet (siehe Abbildung 3), das auf der Basis der fünf Kategorien intuitiver Ontologie (Person, Tier, Pflanze, Artefakt, natürliches Objekt) nach Pascal Boyer[48] entwickelt und verfeinert wurde. Es soll nicht nur das konkrete Designat beschrieben werden, sofern dies Grundlage für die Gestaltung des Graphs ist, wie etwa der Schild für das Logogramm PAKAL. Weitere Facetten, die zur Zeichenidentität beitragen, basieren auf ikonographischen Standards, die natürliche Existenz des Designats zu abstrahieren oder immaterielle wie dingliche Eigenschaften sichtbar zu machen. So stellt etwa das Logogramm MAM ›Großvater‹ einen menschlichen Kopf dar, den wir weiter als männlich und senil beschreiben können. Oder das Logogramm EB ›Treppe‹ ist nicht wie zu erwarten mit der ikonographischen Konvention für die Darstellung von ›Stein‹ markiert, sondern mit der für ›Holz‹. Mit einer feingranularen Charakterisierung der Ikonizität eines Graphs können u.a. auch kognitionswissenschaftliche Fragestellungen an den Katalog gerichtet werden, die dann auch verwendet werden können, um darzustellen, wie die klassischen Maya ihre Welt wahrgenommen haben.

8.2 Graphemrelationen

Zwangsläufig werden bestimmte ikonographische Facetten bei mehr als einem Graph auftauchen. Im Laufe der Schriftgeschichte bildeten bestimmte Ikone die Grundlage für die Bildung neuer Schriftzeichen. Dadurch teilen die Schriftzeichen sich zumeist diagnostische Merkmale, die aber auch unabhängig von deren Ableitung bei verschiedenen Graphen bestehen können. Relationen wie diese können im Zeichenkatalog auf der Graphebene ebenfalls erfasst werden. Neben der Möglichkeit, die Evolution des Schriftsystems damit zu erforschen, ergeben sich konkrete Mehrwerte bei der Entzifferungsarbeit, etwa wenn im Fall einer erodierten Textstelle auch nach anderen Graphen mit einer bestimmten Facette im Ikon gesucht werden kann und so sichergestellt werden kann, dass keine Möglichkeit der Lesung und Rekonstruktion unberücksichtigt bleibt.

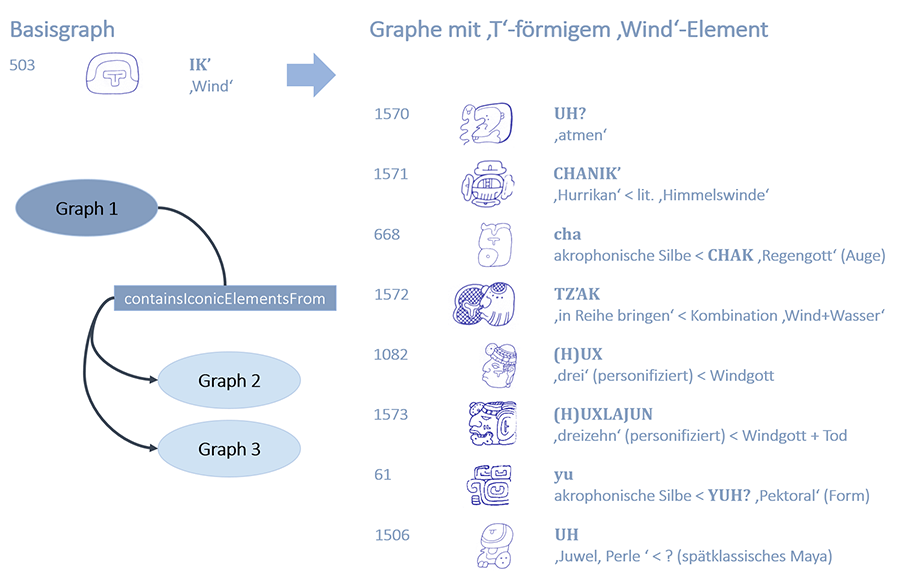

Die Einbettung eines Ikons (idiomcat:containsIconicElementsFrom) in ein anderes Graph (Abbildung 10) kann auf konzeptionelle Verwandschaften bei den Graphen hinweisen. In der Maya-Ikonographie wird ›Wind‹ durch ein T-förmiges Element dargestellt, dass sich auch in anderen Graphen inkorporiert wiederfindet.

Wie man sehen kann, taucht es häufiger in Graphen auf, die direkt in Verbindung zu Luft und Wind stehen. Im ersten Beispiel für das Logogramm UH? findet sich das Wind-Element im oberen Bogen einer mäandernden Linie wieder, die allgemein für einen Luftstrom steht, der den Mund verlässt. In anderen Fällen markiert das Ikon Körperteile von übernatürlichen Akteuren, die in Verbindung zu Wind und atmosphärischen Phänomenen stehen, wie auch das Auge des Regengottes, das akrophonisch für die Silbe cha gebraucht wird. Der Fall von TZ’AK ist besonders interessant. Die Semantik ist ›etwas in Reihe(nfolge) bringen, ordnen‘ und das Verb wird etwa in der Zeitzählung benutzt. Es existieren mehrere Digraphe, die zwei Ikone mit einem gegensätzlichen, konsekutiven oder kasaulistischem Konzept kombinieren,[49] hier Wind und Wasser, so wie im Maya-Tiefland häufig auf einen kurzfristig anschwellenden Wind der nachmittäglichem Regen folgt.

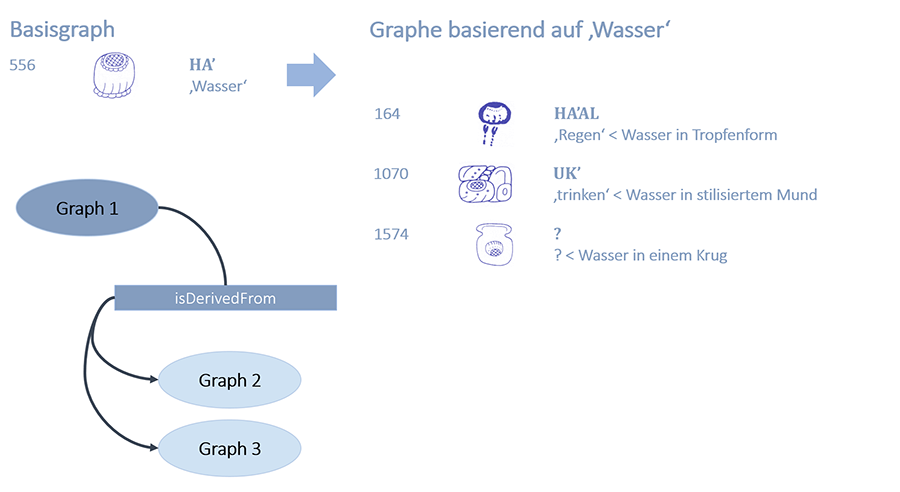

Eine andere Methode ist die Derivation von Graphen (Abbildung 11). Hierbei wird die Form des Basisgraphs beibehalten, und entweder Binnenelemente verändert oder weitere Elemente an das Basisgraph angefügt (idiomcat:isDerivedFrom). Häufig besitzt das zugehörige Zeichen, sofern es sich um ein Logogramm handelt, eine verwandte semantische Domäne.

Werden dem Logogramm HA’ für ›Wasser‹ Reihen von Tropfen angefügt, so wird hieraus das Logogramm HA’AL ›Regen‹.[50] Fügt man das Graph an die stilisierte Repräsentation eines Mundes, so entsteht hieraus das Logogramm UK’ für ›trinken‹. Einen besonders anschaulichen Fall stellt das Logogramm PAS ›öffnen, dämmern‹ dar, welches das Ikon von ›Sonne‹ zwischen die von ›Himmel‹ und ›Erde‹ stellt.

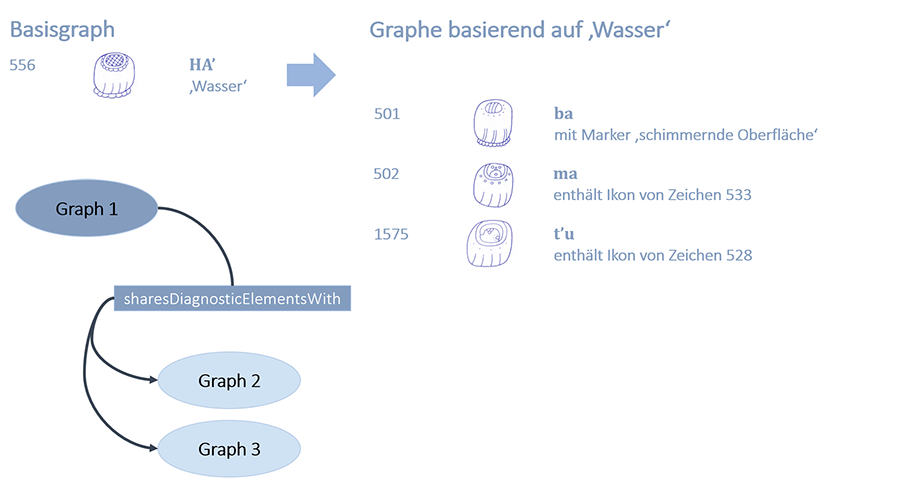

In einer Studie zur Innovation von Zeichen, speziell Silbenzeichen mit Lautwert bV und mV, konnte Alfonso Lacadena[51] nachweisen, dass mit der Übernahme des Vorläufers der Mayaschrift, der eine Sprache aus der Familie des Mije-Sokean kodierte, u.a. neue Zeichen für die dort nicht vorkommenden Laute /b/ und /C’/ geschaffen werden mussten, ein Prozess der im Prinzip nach aktueller Notwendigkeit die gesamte Frühklassik andauerte. Auch wurden nach ähnlichem Prinzip in der Spätklassik weitere Allographe für bestehende Silbenzeichen generiert (Abbildung 12). Hier führen häufig nur Detailänderungen im Graph zu einer neuen Zeichenidentität, so dass wir (nicht nur) für diese Fälle eine weitere Relation geteilter Merkmale anzeigen können (idiomcat:sharesDiagnosticElementsWith).

Schriftgeschichtlich können wir beobachten, dass das Logogramm HA’ bereits in den ältesten frühklassischen Texten auftaucht. Die offenbar daraus abgeleiteten Silbenzeichen teilen sich mit dem Basisgraph die diagnostischen Merkmale einer innen liegenden Kartusche (in der jeweils die Zeichenidentität festgelegt wird), einer darunterliegenden Punktereihe und einer Anzahl von (Doppel-)Bögen am unteren Rand. Wir können also erst einmal rein deskriptiv Ähnlichkeiten abbilden, bevor wir tatsächlich nachweisen können, ob die Relation ›idiomcat:isDerivedFrom‹ tatsächlich zu setzen ist.

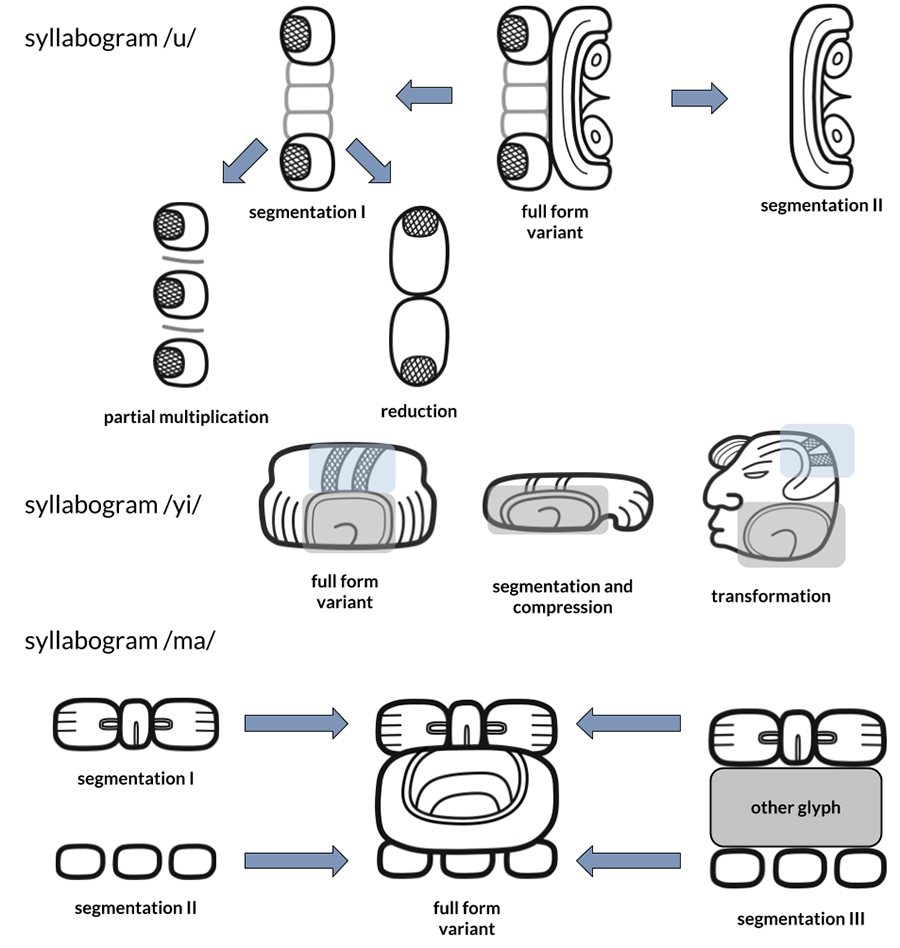

8.3 Zeichenrelationen

Für die meisten Zeichen gibt es jeweils mindestens eine Graphvariante, die auf denselben diagnostischen Merkmalen basiert, und welche die Zeichenidentität bestimmt, unbeschadet der Segmentation oder Transformation. Eine geringe Anzahl an Lautwerten wird dabei mit Graphen realisiert, die über keine Verwandtschaft verfügen und auf unterschiedlichen Graphikonen aufbauen (Abbildung 13). Eine Durchsicht der beiden neuesten Kataloge, die auch eine Liste der Silbenzeichen umfassen, zeigt, dass hier die Zahl dieser sogenannten diskreten Allographe üblicherweise sehr beschränkt ist und Variabilität zumeist mit Graphvarianten eines Zeichens erzeugt wird.

Wir finden bei Logogrammen das Phänomen von Homonymen, wobei jede unterschiedliche semantische Domäne üblicherweise heterographisch realisiert wird[52], es aber teilweise zu rebusartigen Schreibungen kommt,[53] was noch einmal die inhaltliche Komponente bei Logogrammen betont. Wie bei den Silbenzeichen auch scheint aber die Anzahl von diskreten Allographen bei gleicher Wortbedeutung recht begrenzt zu sein. Es können dabei unterschiedliche Konnotationen eines Wortes repräsentiert werden, z. B. AJAW ›Herrscher‹ abstrakt durch eine Thronbank oder konkret durch eine Kopfvariante mit Stirnband als Zeichen der Autorität, oder pars pro toto, etwa AK ›Schildkröte‹ einmal durch den Panzer oder den Kopf.

Die dafür im Zeichenkatalog verwendete Relation (idiomcat:isDistinctAllographOf) erlaubt also die Suche nach anderen Zeichen mit demselben Transliterationswert. So können etwa Abfragen zur Innovation von Zeichen in Verbindung mit dem Textkorpus gestellt oder Aussagen über regionale Varianten getätigt werden, wie etwa über eine spezielle Variante von bi auf Keramiken aus Xultun.[54]

8.4 Einbindung forschungsgeschichtlicher Ergebnisse

Die Neuinventarisierung der Schriftzeichen durch das Projekt stellt im Wesentlichen eine Revision des Zeichenkatalogs von J. Eric S. Thompson aus dem Jahre 1962 dar, der als Quasi-Standard in der Forschung weite Verbreitung gefunden hat. So werden etliche ›Thompson-Nummern‹ als Zeichennummern in unserem Katalog weiterverwendet, was ihren Wiedererkennungswert bei Fachkollegen steigert. Neben Thompson steht unser Zeichenkatalog natürlich auch in einer forschungsgeschichtlichen Tradition und Reflexion der anderen Katalogisierungsbemühungen.

Daher wird auf Graphebene eine Konkordanz (idiomcat:hasCatalogueEntry, siehe Abbildung 4) zu den bisherigen Werken angelegt. In dieser werden die Katalognummern, Kommentare und Abbildungen der bereits publizierten Inventare hinterlegt. Damit ist auch erstmalig ein Vergleich aller Kataloge möglich, was auch die Entscheidungen der Revision und die Entscheidung für Graphvarianten in unserem Katalog transparenter macht.

Überhaupt möchten wir mit dem Zeichenkatalog eine Wissensbasis zur Schriftforschung schaffen. Gemäß guter wissenschaftlicher Praxis werden wir dokumentierte Aussagen mit entsprechenden Quellenverweisen versehen. Damit sind sämtliche Informationen nachvollziehbar und überprüfbar. Insbesondere bei den Lesungsvorschlägen ist eine Nennung der entsprechenden Studie unverzichtbar. Alle Entitäten des Schemas können mit Quellen verbunden werden (dct:isReferencedBy, siehe Abbildung 4). Die Bibliographie wird über die Open-Source-Plattform Zotero verwaltet und frei zugänglich zur Verfügung gestellt und sowohl mit dem URI der entsprechenden Ressource als auch mit einer formatierten bibliographischen Angabe bei der entsprechenden Instanz gespeichert.

9. Veröffentlichung der Daten und Möglichkeiten der Nachnutzung

Die Inventarisierung und Klassifikation der Maya-Schriftzeichen ist aktuell in Bearbeitung und wird voraussichtlich im Laufe des Jahres 2018 zum Abschluss kommen. Sobald alle Graphvarianten und Zeichen erfasst wurden, wird konsequent mit der Auszeichnung der Inschriften und der Erstellung des Korpus begonnen. Dokumentation und wissenschaftliche Erschließung der Texte und der Textträger werden sich über die verbleibende Projektlaufzeit bis 2028 erstrecken. Die Daten werden sukzessive auf unserem, sich derzeit in der Konzeption befindlichen, Projektportal zugänglich gemacht. Des Weiteren werden die Korpusdaten auch im TextGrid Repository (TG Rep) veröffentlicht, wo sie mittels OAI-PMH Schnittstelle auch für externe Nutzer abrufbar sind. Die RDF-Daten des Zeichenkatalogs werden ebenfalls über das Portal, das TG Rep und auch mittels eines SPARQL-Endpoints abrufbar. Sämtliche im Projekt entstandenen Schemata sind im öffentlichen Bereich unseres Git-Repositoriums[55] einsehbar und können unter einer CC BY-4.0 Lizenz genutzt werden. Die Dokumentation der Zeichenkatalog-Ontologie steht auch als Webseite zur Verfügung.[56]

10. Fazit: Modellierung als Forschungsmethode der Digitalen

Geisteswissenschaften

Im vorliegenden Beitrag wurde am Beispiel des Zeichenkatalogs für die Maya-Schrift beschrieben, wie Methoden der Wissensrepräsentation genutzt werden können, um vage und unsichere Informationen in einem maschinenlesbaren Modell abzubilden und sie somit für weitere Analysen aufzubereiten. Um Vagheiten und Unsicherheiten zu beschreiben und bewertbar zu machen, wurde ein qualitativer Ansatz gewählt. Die Angabe eines Bewertungslevels erfolgt durch sprachspezifische Kriterien, die mittels Aussagenlogik miteinander kombiniert sind. Durch die Kombination bestimmter Kriterien kann die Plausibilität einer Hypothese geschlussfolgert werden. Es wäre von Interesse diesen Ansatz auch auf andere Anwendungsfälle zu übertragen und zu explorieren, inwieweit die kriterienbasierte Bewertung den Umgang mit zweifelbehafteten Wissensobjekten in der digitalen geisteswissenschaftlichen Forschung ermöglicht.

Modellierungsprozesse bewirken eine Reflexion der Definitionen und Methoden des jeweiligen Fachbereichs, der Fragen an die betreffenden Wissensobjekte und ihren Gegenstandsbereich stellt. Die Repräsentation dieses Wissens in einem maschinenlesbaren Modell erfordert die präzise Definition der Objekte sowie deren Beziehungen zueinander und zu ihrer Wissensbasis. Fachtraditionen werden dabei hinterfragt und angewandte Methoden auf ihre Grundlagen überprüft. So wurde im konkreten Fall der Modellierung der Entzifferungshypothesen deutlich, dass Aussagen über die Plausibilität von Lesungsvorschlägen nur anhand formaler Bewertungskriterien getroffen werden können. Ohne Reflexion der intuitiv-pragmatischen Bewertungsmechanismen hätte kein Evaluationssystem entstehen können, welches auf Grundlage formalisierter und logisch-kategorisierter Parameter operiert.

Modellierung leistet damit einen zentralen Beitrag zu den Forschungsmethoden der Digitalen Geisteswissenschaften, indem sie durch bewusstes Hinterfragen zur Reflexion disziplinspezifischer Wissensgenerierung anregt. Durch den Modellierungsprozess entstehen explizit definierte Objekte und Beziehungen, die in maschinenlesbare Daten und Datenstrukturen transformiert werden. Durch diesen Transformationsprozess stehen die Wissensobjekte und ihre Wissensbasis für weitere Analysen zur Verfügung, seien es hermeneutische oder auch quantitative Verfahren.

Fußnoten

-

[1]

-

[2]

-

[3]Diehr et al. 2017, S. 1186.

-

[4]

-

[5]vgl. Beyer 1934a, passim; Beyer 1934b, passim; Beyer 1936, passim; Beyer 1937, passim; Lacadena 1995, S. 204f.

-

[6]Die Systematik wurde erstmals am 8. April 2016 im Rahmen der Tagung ‚Ägyptologische »Binsen« Weisheiten III‘ an der Akademie der Wissenschaften und der Literatur in Mainz vorgestellt und wird demnächst in der Tagungsakte publiziert.

-

[7]

-

[8]Morley 1915, passim.

-

[9]Thompson 1956, S. 169.

-

[10]Knorosow 1952, passim.

-

[11]vgl. Knorosow 1958, passim.

-

[12]vgl. Thompson 1962, passim.

-

[13]

-

[14]vgl. Grube 1990, passim; Kelley 1962, passim; Kurbjuhn 1989, passim; Riese 2006, passim; Ringle / Smith-Stark 1996, passim.

-

[15]Knorosow 1999, passim.

-

[16]vgl. Macri / Looper 2003, passim; Macri / Vail 2009, passim.

-

[17]Sowa 2000, S. 132.

-

[18]Reinhold 2015, S. 330.

-

[19]Flick 2007, S. 218–219.

-

[20]Sowa 2000, S. 51.

-

[21]Sowa 2000, S. 51.

-

[22]Loos et al. 2003, passim.

-

[23]Diehr et al. 2018, S. 38.

-

[24]Saussure 1931, S. 28–29.

-

[25]Die vom Projekt gewählte Bezeichnung ›Graph‹ als Konzept der abstrahierten, typisierten Form eines konkret realisierten Schriftzeichens, steht projektintern noch zur Diskussion. Da gemeinhin im linguistischen Diskurs das konkret realisierte Schriftzeichen als ›Graph‹ bezeichnet wird, stellt die abstrahierte Form eine Art Prototyp des Graphs dar. Hier ist noch zu überlegen, wie eine derartige Typisierung in einem Zwischenschritt zwischen dem konkret realisierten Graph und dem Graphem betrachtet werden kann. So könnte etwa die typisierte Form in Abgrenzung zum Graph als Meta-Graph oder Proto-Graph betrachtet werden.

-

[26]vgl. Bussmann 2002, S. 294.

-

[27]Rogers 2005, S. 10.

-

[28]vgl. Neuroth et al. 2015, passim.

-

[29]Gradmann et al. 2013, S. 275–276.

-

[30]Simperl 2010, S. 246.

-

[31]So auch bei der vorliegenden Zeichenkatalog-Ontologie, die spezifisch für den Projektkontext entwickelt wurde, auch wenn sie prinzipiell auch auf andere Anwendungsfälle abstrahierbar ist.

-

[32]Milton / Smith 2004, S. 85.

-

[33]Farrar / Langendoen 2003, S. 100.

-

[34]Farrar 2010, passim.

-

[35]

-

[36]

-

[37]vgl. Stuart 1987, passim.

-

[38]vgl. Riese 1971, S. 20–23.

-

[39]vgl. Houston 2001, S. 9–10.

-

[40]Landa 1959, S. 104–106.

-

[41]vgl. Schellhas 1897, passim.

-

[42]Knorosow 1958, S. 288–289.

-

[43]vgl. Pallan Gayol / Anderson 2018, passim.

-

[44]Text Encoding Initiative 2018, passim.

-

[45]ALMAH (Annotator for the Linguistic Analysis of Maya Hieroglyphs) wird derzeit in Kooperation mit Dr. Cristina Vertan (Universität Hamburg) entwickelt. Vgl. Grube et al. 2018, S. 5–7.

-

[46]vgl. Lacadena / Wichmann 2002, passim; Lacadena / Wichmann 2005, passim.

-

[47]Miles / Bechhofer 2009, passim.

-

[48]Boyer 2009, passim.

-

[49]Stuart 2003, passim.

-

[50]Lacadena 2004, S. 88–93.

-

[51]Lacadena 2010, passim.

-

[52]Gronemeyer 2015, S. 110–112.

-

[53]Houston 1984, passim.

-

[54]Krempel / Matteo 2012, S. 145.

-

[55]

-

[56]

Bibliographische Angaben

- Hermann Beyer (1934a): The Position of the Affixes in Maya Writing I. In: Maya Research 1 (1934), H. 1-2, S. 20–29. [Nachweis im GVK]

- Hermann Beyer (1934b): The Position of the Affixes in Maya Writing II. In: Maya Research 1 (1934), H. 1-2, S.101–108. [Nachweis im GVK]

- Hermann Beyer: The Position of the Affixes in Maya Writing III. In: Maya Research 3 (1936), H. 1, S.102–104. [Nachweis im GVK]

- Hermann Beyer: Studies on the Inscriptions of Chichen Itza. In: Contributions to American Anthropology and History 4 (1937), H. 21, S. 29–175. [Nachweis im GVK]

- Pascal Boyer: Functional Origins of Religious Concepts: Ontological and Strategic Selection in Evolved Minds. In: The Journal of the Royal Anthropological Institute 6 (2009), H. 2, S. 195–214. [Nachweis im GVK]

- Hadumod Bussmann: Lexikon der Sprachwissenschaft. 3. aktualisierte und erweiterte Auflage. Stuttgart 2002. [Nachweis im GVK]

- Tom Clyens: Exclusive: Laser Scans Reveal Maya »Megalopolis« Below Guatemalan Jungle. A vast, interconnected network of ancient cities was home to millions more people than previously thought. In: National Geographic. Beitrag vom 01.02.2018. [online]

- Franziska Diehr / Sven Gronemeyer / Christian Prager / Maximilian Brodhun / Elisabeth Wagner / Katja Diederichs / Nikolai Grube: Modellierung eines digitalen Zeichenkatalogs für die Hieroglyphen des Klassischen Maya. DOI: 10.18420/in2017_120 In: Informatik 2017. Hg. von Maximilian Eibl / Martin Gaedke. (Informatik 2017, Chemnitz, 25.-29-09-2017) Bonn 2017, S. 1185–1196. Handle: 20.500.12116/3568

- Franziska Diehr / Sven Gronemeyer / Christian Prager / Elisabeth Wagner / Maximilian Brodhun / Katja Diederichs / Nikolai Grube: Ein digitaler Zeichenkatalog als Organisationssystem für die noch nicht entzifferte Schrift der Klassischen Maya. In: Knowledge Organization for Digital Humanities. Proceedings of the 15th Conference on Knowledge Organization WissOrg’17 of the German Chapter of the International Society for Knowledge Organization. Hg. von Christian Wartena / Michael Franke-Maier / Ernesto De Luca. (ISKO: 15, Berlin, 30.11.-01.12.2017) Berlin 2018, S. 37–43. Handle: fub188/20535

- Scott Farrar: General Ontology for Linguistic Description (GOLD). Department of Linguistics (The LINGUIST List), Indiana University, 2010. [online]

- Scott Farrar / D. Terence Langendoen: A Linguistic Ontology for the Semantic Web. In: GLOT International 7 (2003), H. 3, S. 97–100. [Nachweis im GVK]

- Uwe Flick: Qualitative Sozialforschung: Eine Einführung. 7. Auflage, vollständig überarbeitet und erweiterte Neuausgabe. Reinbek 2007. [Nachweis im GVK]

- Stefan Gradmann / Evelyn Dröge / Julia Iwanowa / Violeta Trkulja / Steffen Hennicke: Wege zur Integration von Ontologien am Beispiel einer Spezifizierung des Europeana Data Model. In: Informationswissenschaft zwischen virtueller Infrastruktur und materiellen Lebenswelten. Hg. von Hans-Christoph Hobohm. (Internationales Symposiums für Informationswissenschaft. Proceedings des 13. Internationalen Symposiums für Informationswissenschaft. (ISI: 13, Potsdam, 19.-22.03.2013) Glückstadt 2013, S. 273–284. [Nachweis im GVK]

- Sven Gronemeyer: Class Struggle: Towards a Better Understanding of Maya Writing Using Comparative Graphematics. In: On Methods: How We Know What We Think We Know About the Maya. Hg. von Harri Kettunen / Christophe Helmke. (European Maya Conference: 17, Helsinki, 09-15.12.2012) München 2015, S.101–117. # (= Acta Mesoamericana, 28) [Nachweis im GVK]

- Nikolai Grube / Christian Prager / Katja Diederichs / Sven Gronemeyer / Antje Grothe / Céline Tamignaux / Elisabeth Wagner / Maximilian Brodhun / Franziska Diehr: Annual Report 2017. Bonn 2018. (= Textdatenbank und Wörterbuch des Klassischen Maya/Project Report, 5) DOI: 10.20376/IDIOM-23665556.18.pr005.de

- Nikolai Grube: Die Entwicklung der Mayaschrift: Grundlagen zur Erforschung des Wandels der Mayaschrift von der Protoklassik bis zur spanischen Eroberung. Berlin 1990. (= Acta Mesoamericana, 3) [Nachweis im GVK]

- Stephen Douglas Houston: Introduction. In: The Decipherment of Ancient Maya Writing. Hg. von Stephen D. Houston / Oswaldo Chinchilla Mazariegos / David Stuart. Norman, OK. 2001, S. 3–19. [Nachweis im GVK]

- Stephen Douglas Houston: An Example of Homophony in Maya Script. In: American Antiquity 49 (1984), H. 4, S. 790–805. [Nachweis im GVK]

- ICOM/CIDOC CRM Special Interest Group: CIDOC Conceptual Reference Model. Hg. von Martin Doerr / Matthew Stiff / Nick Crofts / Stephen Stead / Tony Gill. Version 5.0.4. 2011. [online]

- David Humiston Kelley: Review. John Eric Sidney Thompson: A Catalog of Maya Hieroglyphs. American Journal of Archaeology 66 (1962), H. 4, S. 436–438. [Nachweis im GVK]

- Juri Valentinovich Knorosow: Drevnyaya pis’mennost’ Tsentral’noy Ameriki. In: Sovetskaja Etnografija 3 (1952), H. 2, S. 100–118. [Nachweis im GVK]

- Juri Valentinovich Knorosow: The Problem of the Study of the Maya Hieroglyphic Writing. In: American Antiquity 23 (1958), H. 3, S. 284–291. [Nachweis im GVK]

- Juri Valentinovich Knorosow: Compendio Xcaret de la Escritura Jeroglífica Maya. 3 Bde. Chetumal 1999. [Nachweis im GVK]

- Guido Krempel / Sebastián Matteo: Painted Styles of the North-Eastern Peten from a Local Perspective: The Palace Schools of Yax We’en Chan K’inich, Lord of Xultun. In: Proceedings of the 1st Cracow Maya Conference: Archaeology and Epigraphy of the Eastern Central Maya Lowlands. Hg. von Christophe Helmke / Jarosław Źrałka. (Cracow Maya Conference: 1, Krakau, 25.-27.02.2011) Kraków 2012, S. 135–171. [Nachweis im GVK]

- Kornelia Kurbjuhn: Maya: The Complete Catalogue of Glyph Readings. Kassel 1989. [Nachweis im GVK]

- Alfonso Lacadena: Evolución formal de las grafías escriturarias mayas: Implicaciones históricas y culturales. Madrid 1995. PDF. [online]

- Alfonso Lacadena: On the Reading of Two Glyphic Appelatives of the Rain God. In: Continuity and Change: Maya Religious Practices in Temporal Perspective, Hg. von Daniel Graña-Behrens / Nikolai Grube / Christian M. Prager / Frauke Sachse / Stefanie Teufel / Elisabeth Wagner. (European Maya Conference: 5, Bonn, 12.2000) Markt Schwaben 2004, S. 87–98. (= Acta Mesoamericana, 14) [Nachweis im GVK]

- Alfonso Lacadena: Historical Implications of the Presence of Non-Mayan Linguistic Features in the Maya Script. In: The Maya and Their Neighbours: Internal and External Contacts Through Time. Hg. von Laura van Broekhoven / Frauke Sachse / Benjamin Vis / Rogelio Valencia Rivera. (European Maya Conference: 10, Leiden, 09.-10.12.2005) Markt Schwaben 2010, S. 29–39. (= Acta Mesoamericana, 22) [Nachweis im GVK]

- Alfonso Lacadena / Søren Wichmann: The Distribution of Lowland Maya Languages in the Classic Period. In: La organización social entre los mayas. Hg. von Vera Tiesler Blos / Rafael Cobos / Merle G. Robertson. 2 Bde. (Mesa Redonda de Palenque: 3, Palenque, Chiapas, Mexico, 27.06.-01.07.1999) México (u.a.) 2002. Bd. 2, S. 275–319. [Nachweis im GVK]

- Alfonso Lacadena / Søren Wichmann: The Dynamics of Language in the Western Lowland Maya Region. [online] In: Art for Archaeology’s Sake: Material Culture and Style across the Disciplines, Hg. von Andrea Waters-Rist / Christine Cluney / Calla McNamee / Larry Steinbrenner. (Conference of the Archaeological Association of the University of Calgary : 33, Calgary, 2005) Calgary, Alta 2005, S. 32–48.

- Diego de Landa: Relación de las cosas de Yucatán. 8. edition. México 1959. (= Biblioteca Porrúa, 13) [Nachweis im GVK]

- Eugene E. Loos / Susan Anderson / Dwight H. Day / Paul C. Jordan / J. Douglas Wingate: Glossary of Linguistic Terms. Hg. von SIL International. Dallas, TX. 2003. [online]

- Martha Jane Macri / Matthew George Looper: The New Catalog of Maya Hieroglyphs. 2 Bde. Norman, OK. 2003. Bd. 1: The Classic Period Inscriptions. (= Civilization of the American Indian Series, 247) [Nachweis im GVK]

- Martha Jane Macri / Matthew George Looper: The New Catalog of Maya Hieroglyphs. 2 Bde. Norman, OK. 2009. Bd. 2: The Codical Texts.(= Civilization of the American Indian Series, 264) [Nachweis im GVK]

- SKOS Simple Knowledge Organisation System. Reference. Hg. von Alistair Miles / Sean Bechhofer. In: W3C. Recommendation vom 18. August 2009. [online]

- Simon K. Milton / Barry Smith: Top-level Ontology: The Problem with Naturalism. In: Formal Ontology in Information Systems. Hg. von Achille Carlo Varzi / Laure Vieu. (FOIS 2004, Turin, 04.-06.11.2004) Amsterdam (u.a) 2004, S. 85–94. [Nachweis im GVK]

- Sylvanus Griswold Morley: An Introduction to the Study of the Maya Hieroglyphs. Washington, D.C. 1915. (= Bulletin/Bureau of American Ethnology/Smithsonian Institution, 57) [Nachweis im GVK]

- TextGrid: Von der Community – für die Community. Eine Virtuelle Forschungsumgebung für die Geisteswissenschaften. Hg. von Heike Neuroth / Andrea Rapp / Sibylle Söring. Göttingen 2015. DOI: 10.3249/webdoc-3947 [Nachweis im GVK]

- Carlos Pallan Gayol / Deborah Anderson: Achieving Machine-Readable Mayan Text via Unicode: Blending »Old World« Script-encoding with Novel Digital Approaches. [online] In: Digital Humanities 2018: Puentes-Bridges. Book of Abstracts. Hg. von Jonathan Girón Palau / Isabel Galina Russell. (DH 2018, Mexico City, 26.-30.06.2018) Mexico 2018, S. 256–261. PDF. [online]

- Christian Prager (2014a): Überblick über das Projekt. In: Textdatenbank und Wörterbuch des Klassischen Maya. 16. Dezember 2014. [online]

- Christian Prager (2014b): Zielsetzung. In: Textdatenbank und Wörterbuch des Klassischen Maya. 4. Dezember 2014. [online]

- Christian Prager (2014c): Zeichentypen und Kataloge. In: Textdatenbank und Wörterbuch des Klassischen Maya. 16. Dezember 2014. [online]

- Anke Reinhold: Das Experteninterview als zentrale Methode der Wissensmodellierung in den Digital Humanities. In: Information Wissenschaft Praxis 66 (2015), H. 5-6, S. 327–333. [Nachweis im GVK]

- Berthold Riese: Grundlagen zur Entzifferung der Mayahieroglyphen, dargestellt an den Inschriften von Copan. München 1971. (= Beiträge zur mittelamerikanischen Völkerkunde, 11) [Nachweis im GVK]

- Berthold Riese: Drei neue Maya-Hieroglyphen Kataloge. [online] In: Anthropos 101 (2006), H. 1, S. 238–246. [online] [Nachweis im GVK]

- William M. Ringle / Thomas C. Smith-Stark: A Concordance to the Inscriptions of Palenque, Chiapas, Mexico. New Orleans, LA. 1996. (= Publication/Middle American Research Institute, 62) [Nachweis im GVK]

- Henry Rogers: Writing Systems: A Linguistic Approach. Oxford (u.a.) 2005. (= Blackwell Textbooks in Linguistics, 18) [Nachweis im GVK]

- Ferdinand de Saussure: Cours de Linguistique Générale. 3. Auflage. Paris 1931. [Nachweis im GVK]

- Paul Schellhas: Die Göttergestalten der Mayahandschriften. Ein mythologisches Kulturbild aus dem alten Amerika. Dresden 1897. [Nachweis im GVK]

- Elena Simperl: Guidelines for Reusing Ontologies on the Semantic Web. DOI: 10.1142/S1793351X10001012 In: International Journal of Semantic Computing 4 (2010), H. 2, S. 239–283. [online] [Nachweis im GVK]

- John F. Sowa: Knowledge Representation. Logical, Philosophical, and Computational Foundations. Pacific Grove, CA. 2000. [Nachweis im GVK]

- David Stuart: On the Paired Variants of TZ’AK. Cambridge, MA. 2003. PDF. [online]

- David Stuart: Ten Phonetic Syllables. Washington, D.C. 1987. (= Research Reports on Ancient Maya Writing, 14) [online] [Nachweis im GVK]

- Text Encoding Initiative, P5: Guidelines for Electronic Text Encoding and Interchange, Version 3.4.0., 23. July 2018. [online]

- Text Database and Dictionary of Classic Mayan: Ontology of the Sign Catalogue for Classic Mayan, 2017. [online]

- Text Database and Dictionary of Classic Mayan: Gitolite Repository, 2018. [online]

- John Eric Sidney Thompson: The Rise and Fall of Maya Civilization. Norman, OK. 1956. (= The Civilization of the American Indian Series, 39) Siehe auch: [Nachweis im GVK]

- John Eric Sidney Thompson: A Catalog of Maya Hieroglyphs. Norman, OK. 1962. (= The Civilization of the American Indian Series, 62) [Nachweis im GVK]

Abbildungslegenden und -nachweise

- Abb. 1: Beispiele für Maya-Hieroglyphen, links La Corona Panel 1, rechts polychrome Keramik unbekannter Herkunft; Fotos: Sven Gronemeyer.

- Abb. 2: Schreibung von Hieroglyphen. John Montgomery: How to Read Maya Hieroglyphs. Hippocrene, New York, NY, 2002.

- Abb. 3: Graphvarianten. Konzept: Franziska Diehr; Zeichnungen: Christian Prager.

- Abb. 4: Domain-Model der Zeichenkatalog-Ontologie. Konzept: Franziska Diehr.

- Abb. 5: Klassenhierarchie der Zeichenkatalog-Ontologie. Konzept: Franziska Diehr.

- Abb. 6: Entzifferungskategorien. Konzept: Sven Gronemeyer; Zeichnungen der Glyphen: Matthew Looper.

- Abb. 7: Entzifferung von Silbenzeichen. Konzept: Sven Gronemeyer; Zeichnungen der Silbenzeichen: Diego de Landa, Relación de las cosas de Yucatán. Fray Di[eg]o de Landa: MDLXVI. Unveröffentlichtes Manuskript. Madrid, Biblioteca de la Real Academia de Historia, 1566; Faksimile Codex Dresden: SLUB [online]; Faksimile Codex Madrid: Ferdinand Anders Codex Tro-Cortesianus (Codex Madrid): Museo de America Madrid. Codices Selecti Phototypice Impressi 8. Akademische Druck- u. Verlagsanstalt, Graz, 1967.

- Abb. 8: Exemplarische Auszeichnung eines Hieroglyphenblocks in TEI/XML. Screenshot aus dem Projektbereich von ›Textdatenbank und Wörterbuch des Klassischen Maya‹ im TextGrid Lab.

- Abb. 9: Systemarchitektur des Projekts ›Textdatenbank und Wörterbuch des Klassischen Maya‹. Konzept: Maximilian Brodhun.

- Abb. 10: Graphemrelationen: ikonische Elemente. Konzept: Sven Gronemeyer; Zeichnungen der Glyphen: Ian Graham, Matthew Looper, John Montgomery, David Mora-Marín.

- Abb. 11: Graphemrelationen: Derivation. Konzept: Sven Gronemeyer; Zeichnungen der Glyphen: Matthew Looper.